INTRODUCCIÓN

La evaluación, considerada actualmente un factor clave en el proceso de enseñanza-aprendizaje (Asiú et al., 2021), en muchas ocasiones se le asocia con “calificación” en lugar de “aprendizaje”. En el primer caso se entiende como la acción de ofrecer una nota numérica “

” (Hortigüela et al., 2019, p. 14). En el segundo, contribuye a la formación integral de los estudiantes (Asiú et al., 2021). Por ello, resulta crucial que los docentes abandonen el modelo tradicional de evaluación para implementar la evaluación formativa, centrada en mejorar los aprendizajes de los estudiantes (Bizarro et al., 2021).al finalizar un proceso y sobre la que no se ha constatado intencionadamente el aprendizaje adquirido

La evaluación formativa incrementa la motivación del estudiante, quien desarrolla autonomía y responsabilidad para adquirir estrategias, aprender de forma permanente y optimizar su rendimiento académico; además, mejora la calidad de enseñanza del docente. Mediante la retroalimentación oportuna el estudiante conoce el progreso en el desarrollo de sus competencias durante su proceso de aprendizaje y no solo al final (Vallés et al., 2018; Gutiérrez et al., 2021). De este modo, en caso de ser necesario, el docente propone intervenciones pedagógicas que buscan mejorar el aprendizaje del alumno (Borjas et al., 2022).

Para ello, se requiere adoptar un estilo reflexivo que forme un pensamiento crítico en el estudiante y que le permita involucrarse en su proceso de enseñanza (Silva & Lázaro-Cantabrana, 2020). En esta línea, la evaluación formativa busca la innovación de estrategias que desarrollen competencias a través de herramientas de evaluación, sesiones de aprendizaje y participación continua de los estudiantes, posibilitando “el desarrollo de habilidades por parte del estudiante que lo convierten en un ser humano inserto y activo en la sociedad” (Hidalgo, 2021, p. 193).

Por su parte, las técnicas de evaluación se emplean para recopilar datos que muestren las necesidades educativas, los resultados del proceso de aprendizaje, la adquisición de competencias y desarrollan los aprendizajes en el mayor grado posible (Kiliç & Taptik, 2020). Por lo tanto, la evaluación no debe enfocarse en la memorización de contenidos, sino en actitudes, habilidades o valores esenciales para la adquisición de conocimientos, habilidades y destrezas. En este contexto, la autoevaluación y la evaluación entre iguales favorecen el aprendizaje significativo del alumno para su desarrollo académico y profesional, incluidas las competencias de juicio crítico y reflexivo (Adachi et al., 2018; Cañadas et al., 2021).

La rúbrica, otra herramienta utilizada para mejorar la evaluación del aprendizaje, consiste en un cuadro de doble entrada con variables y dimensiones, niveles de calidad que pueden alcanzarse e indicadores que demuestran el rendimiento. Su propósito es alcanzar niveles óptimos de entendimiento, como también buenos resultados en el proceso de enseñanza-aprendizaje (Kweksilber & Trías, 2020). A través de ella, los docentes establecen criterios que evalúan el progreso del estudiante y definen los niveles del logro en forma cualitativa. Además, el estudiante puede revisar los criterios con los que fue evaluado, ya que son fáciles de usar y ayudan a alcanzar los objetivos propuestos (Artiles et al., 2022).

En tanto, el portafolio del estudiante recolecta textos, narraciones, diarios o videos (Orbea-Aizpitarte et al., 2019), se basa en la reflexión (Franco et al., 2020) y muestra evidencias de las competencias y aprendizajes adquiridos, lo que implica más que una acumulación de trabajos. A través de esta herramienta el estudiante debe sustentar los materiales incluidos y argumentar la importancia para su formación (Orbea-Aizpitarte et al., 2019).

Mientras, el portafolio electrónico emplea las TIC y enfatiza en el desarrollo de competencias comunicativas, tecnológicas, de desarrollo profesional y de reflexión (Álvarez, 2020). Por otro lado, la guía de evaluación define criterios uniformes para evaluar el desempeño de los estudiantes con el fin de minimizar la subjetividad en las calificaciones. Esta herramienta contribuye a la mejora del proceso evaluativo, así como al desarrollo y evaluación de competencias requeridas según la asignatura a evaluar (Martín et al., 2019).

Las investigaciones sobre instrumentos de evaluación demuestran los beneficios y ventajas que su implementación en la educación superior conlleva, principalmente los relacionados con el desarrollo de competencias profesionales (Herrán et al., 2019). Las competencias se refieren a la capacidad de los estudiantes para adquirir habilidades, conocimientos y actitudes para resolver y afrontar problemas o desafíos. Entre las más utilizadas se encuentran las genéricas o transversales relacionadas con el perfil profesional y formativo de la mayoría de profesiones, incluyendo habilidades como la creatividad, adaptabilidad a nuevas situaciones y el trabajo en equipo, requeridas cada vez más en el actual mercado laboral.

Las competencias específicas o profesionales se refieren a los conocimientos imprescindibles para ejercer una profesión específica de manera amplia y segura (Cañadas et al., 2021; Vallés et al., 2018). Ante lo expuesto, no es suficiente que los docentes solo enseñen a los estudiantes, sino que además se aseguren de que hayan logrado los aprendizajes de los temas propuestos. Para ello, es necesario utilizar herramientas de evaluación que complementen la implementación de la evaluación formativa en las aulas universitarias.

El objetivo planteado fue analizar los beneficios de la aplicación de instrumentos de evaluación en la formación de competencias profesionales de estudiantes universitarios, con base en artículos indexados en Scopus y Scielo. Además, se constató la percepción de los alumnos universitarios sobre la rúbrica y otros instrumentos de evaluación.

METODOLOGÍA

La presente investigación asumió un enfoque mixto y diseño descriptivo (Hernández et al., 2014). Se optó por este enfoque porque se abordó de manera integral el problema mediante la recopilación de datos cuantitativos y cualitativos al mismo tiempo con el objetivo de maximizar sus ventajas inherentes y minimizar sus desventajas (Dawadi et al., 2019).

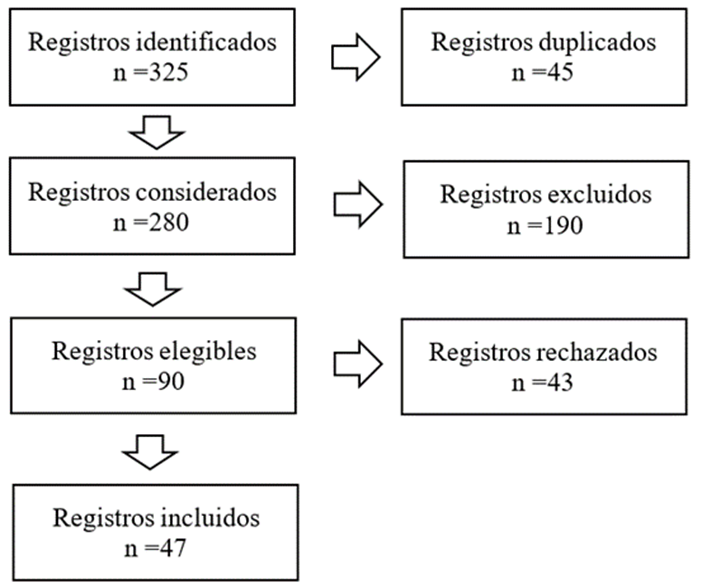

Por tal motivo, se analizó la literatura existente sobre instrumentos de evaluación en la etapa universitaria siguiendo el proceso analítico de literatura de Spelt et al. (2009). Esta secuencia permite la recopilación de datos a través de diversos métodos estructurados para sintetizar y evaluar los resultados de un conjunto de investigaciones (Borba et al., 2021). El proceso sigue cuatro etapas (Figura 1) y asegura que puedan ser replicadas y reproducidas en la búsqueda de otras temáticas (Komba & Lwoga, 2020).

Siguiendo este proceso, se calculó el tamaño de la muestra a analizar, calculada a través de un muestreo no probabilístico intencional con la definición de criterios de inclusión y exclusión (Tabla 1). Estos criterios aseguraron la calidad y pertinencia de los artículos de investigación que conformaron la muestra.

Una vez definidos los criterios se eligieron dos bases de datos para iniciar con la búsqueda: (a) Scopus, mediante su buscador ScienceDirect, por ser una base de datos confiable, multidisciplinaria y con altos estándares de calidad (Pranckutė, 2021), y (b) Scielo, base de datos electrónica dedicada a publicar investigación de Latinoamérica y El Caribe (Beigel et al., 2022).

Posteriormente, se empleó la herramienta ERIC Online Thesaurus [ERICOT] (Haas et al., 2020) para definir las palabras clave: evaluación formativa, rúbrica, instrumentos de evaluación, educación superior y sus correspondientes en inglés. Los términos fueron ingresados en los motores de búsqueda de las bases de datos seleccionadas empleando los operadores booleanos AND y OR en combinaciones como (rubric AND evaluation) o (“assessment instruments” AND (evaluation OR formative assessment)) en su versión en inglés y español.

La tercera etapa correspondió a la identificación de investigaciones relevantes que se adecuaran a los criterios establecidos en la primera etapa. El proceso de selección se basó en la declaración PRISMA (Preferred Reporting Items for Systematic reviews and Meta-Analyses), metodología diseñada para mostrar de forma transparente cómo se identificaron, seleccionaron, evaluaron y sintetizaron los estudios sobre la temática a investigar (Figura 2).

Luego de completadas las tres etapas, se estableció el tamaño de la muestra en un total de 47 artículos de investigación, los cuales se clasificaron e ingresaron en una base de datos en MS Excel. En dicha base de datos se sistematizó información crucial como los objetivos, la metodología y los resultados de cada artículo de investigación. Además de ello, se clasificaron los artículos por la base de datos de procedencia.

La cuarta etapa definida por Spelt et al. (2009) implicó la exploración y análisis de estas investigaciones. Estos procesos fueron realizados y se exponen en el siguiente apartado. Para el análisis del contenido de las publicaciones, se utilizó el software VOSviewer a partir de las palabras clave tanto en español como en inglés y con los términos más relevantes se generó la red bibliométrica. Asimismo, se usó el software Excel en la elaboración de los gráficos estadísticos.

RESULTADOS Y DISCUSIÓN

A continuación, se presentan los resultados de la revisión sistemática de los 47 artículos seleccionados para este estudio.

DESCRIPCIÓN DE LOS ESTUDIOS

La exploración inicial de los artículos seleccionados permitió identificar sus características. Esta primera clasificación determinó que el mayor número de publicaciones corresponde a la base de datos Scopus (66 %); mientras que de Scielo solo se seleccionaron 16 publicaciones (34 %). La predominancia se debió a que Scopus es una base de datos de amplia cobertura, en la cual los investigadores desean publicar sus manuscritos por su prestigio y riguroso proceso de selección (Aksnes & Sivertsen, 2019).

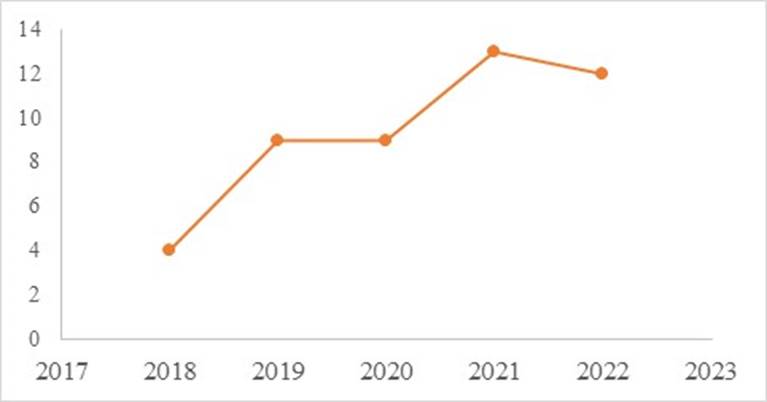

Posteriormente, los artículos seleccionados se clasificaron por el año de publicación (Figura 3) respetando los criterios de inclusión propuestos en la sección metodológica.

Se evidencia que la cantidad de publicaciones fue incrementándose con el paso de los años, probablemente debido al interés de aplicar instrumentos de evaluación en la formación de los futuros profesionales, mostrando un aumento considerable luego de la pandemia. De esta manera, de los artículos seleccionados, 4 fueron publicados en 2018 (9 %); mientras que de 2019 y 2020 se contabilizaron 9 artículos en cada año (19 %). Luego, el mayor número de publicaciones seleccionadas correspondieron al 2021 (28 %) y las publicaciones de 2022 fueron 12 en total (26 %).

Posteriormente, se distribuyeron las publicaciones seleccionadas por el idioma en el cual fueron publicadas (Figura 4).

La distribución por idioma de publicación no reveló una lengua predominante; por lo contrario, se identificaron cantidades similares de publicaciones en ambos idiomas, diferenciándose solo por una publicación. De los artículos seleccionados, 24 se publicaron en inglés (51 %); mientras que 23 en español (49 %). Esta mínima diferencia se debe a que, según Céspedes (2021), el español es un idioma predominante en Scopus, por la presencia de revistas latinoamericanas y españolas; además de una correspondencia con los países en los cuales se desarrollaron las investigaciones. Esto última distribución se explica en la Figura 5.

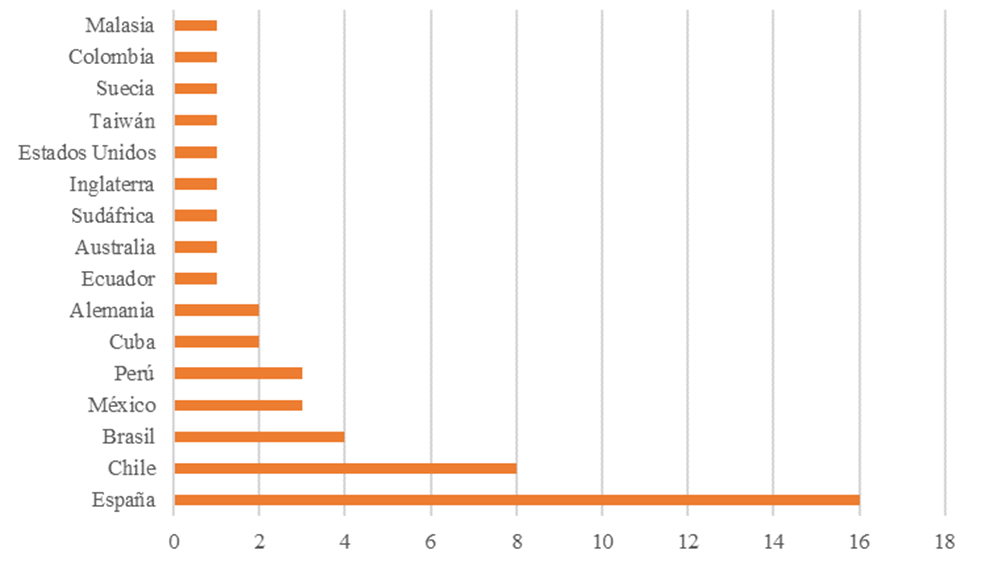

De acuerdo con esta distribución, se observa una predominancia de las investigaciones realizadas en España, puesto que el número de publicaciones fue de 16 (34 %). A este país le siguen Chile, con 8 publicaciones (17 %); Brasil, con 4 publicaciones (9 %), y Perú y México con 3 publicaciones cada uno (6 %). Por su parte, se registraron 2 publicaciones en Alemania y Cuba (4 %); mientras que en el resto de países (Malasia, Colombia, Suecia, Taiwán, EE. UU., Inglaterra, Sudáfrica, Australia y Ecuador), solo se registró una de las publicaciones seleccionadas (2 %).

La predominancia de las investigaciones realizadas en España se debió a que en este país se está implementando la Convergencia UE en el sistema universitario, que requiere cambios en los modelos de evaluación y enseñanza (Sánchez et al., 2022).

CO-OCURRENCIA DE PALABRAS CLAVE

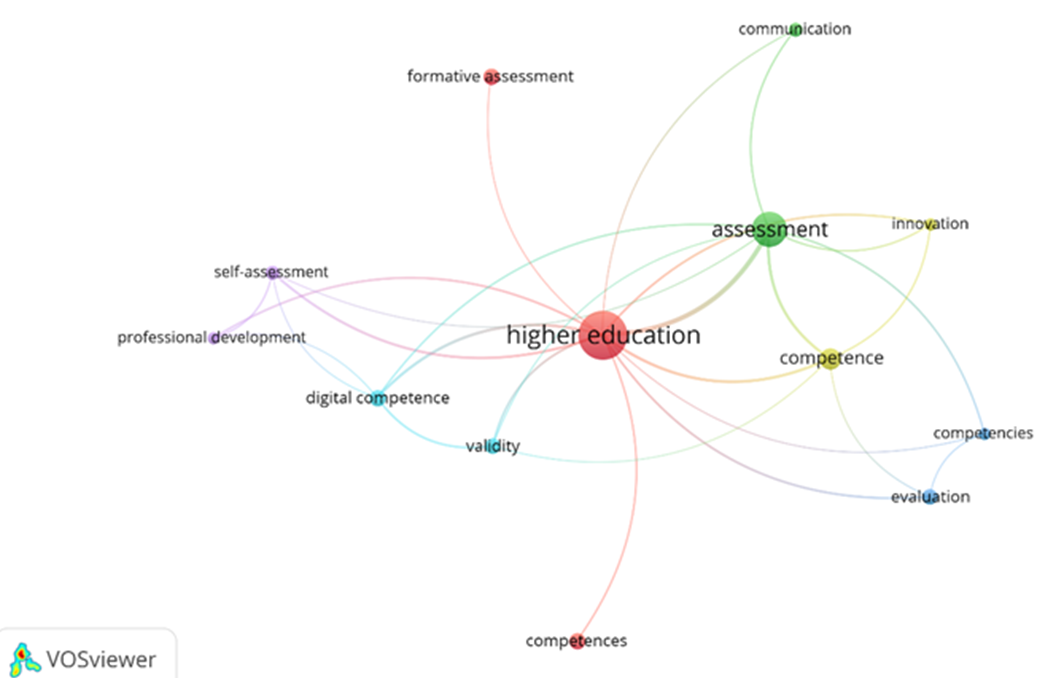

Se realizó un análisis bibliométrico de palabras clave siguiendo las recomendaciones del software VOSViewer (Figura 6). Se observó la existencia de seis clústeres dispersos, lo cual evidencia que no se relacionan entre sí.

El clúster rojo representa a aquellos estudios enfocados en la educación superior; su centralidad y su conexión con otros clústeres evidencia que, aunque distante, este clúster se relaciona con los otros cinco, ya que las investigaciones se realizaron en esta etapa de formación. Por otro lado, los nodos de este clúster se encuentran alejados, por lo que la relación entre los nodos de este clúster con los otros clústeres es relativamente débil.

El clúster verde y el clúster amarillo con su nodo, ubicados muy cercanos al clúster central rojo, poseen una relación entre ellos, ya que se encuentran en una posición cercana. Sin embargo, el nodo del clúster verde no se relaciona con estos por su lejanía en la red. Esto permite afirmar que la formación y las competencias específicas (como las históricas o clínicas) fueron temas relevantes en los artículos seleccionados, como, por ejemplo, los de Martín et al. (2019) y Álvarez (2020).

El clúster celeste está muy próximo al morado, lo que evidencia una fuerte relación entre ellos. Asimismo, los nodos de este clúster no se encuentran alejados entre sí, por lo que la relación entre estos es cercana. De esta manera, se afirma que las competencias digitales y la validación de instrumentos fueron dos campos de interés en las publicaciones bajo examen, donde destaca la de Wild & Schulze (2021).

Por su parte, el clúster morado, de autoevaluación, alejado también de los demás clústeres, pero próximo al celeste, evidencia una relación débil con los clústeres y una relación cercana con el clúster celeste. Los nodos de este clúster poseen una relación positiva, debido a su posición en la red bibliométrica. Destacan las investigaciones en las que los instrumentos fomentaron la autoevaluación (Pérez-Guillén et al., 2022; Tipán, 2021).

El clúster azul se encuentra más alejado de la red bibliométrica y posee menos conexiones. Asimismo, la cercanía de los nodos azules evidencia una relación fuerte entre ellos. Destacan investigaciones en las que se identificaron las competencias a ser evaluadas para refuerzo (Gallardo-Fuentes et al., 2020b).

EFECTOS DE LOS INSTRUMENTOS DE EVALUACIÓN

Posteriormente, se consideró detalladamente el contenido de las investigaciones seleccionadas con base en sus objetivos, alcance y metodología. Por ello, en primer lugar, se identificaron las especialidades de los estudiantes que fungieron como objeto de investigación. De esta manera, algunas investigaciones fueron realizadas con estudiantes de Ciencias de la Salud (Almalkawi et al., 2021; Cervantes-Sánchez et al., 2022; Díaz-Veliz et al., 2021; Martín et al., 2019; Mora-Luco et al., 2021; Tsai et al., 2022); mientras que otras se realizaron con estudiantes de Ingenierías (Arribas et al., 2019; Cantera et al., 2021; Flores & Alcalá, 2019; Pui et al., 2021; Tobajas et al., 2019) o de ciencias puras (Tipán, 2021).

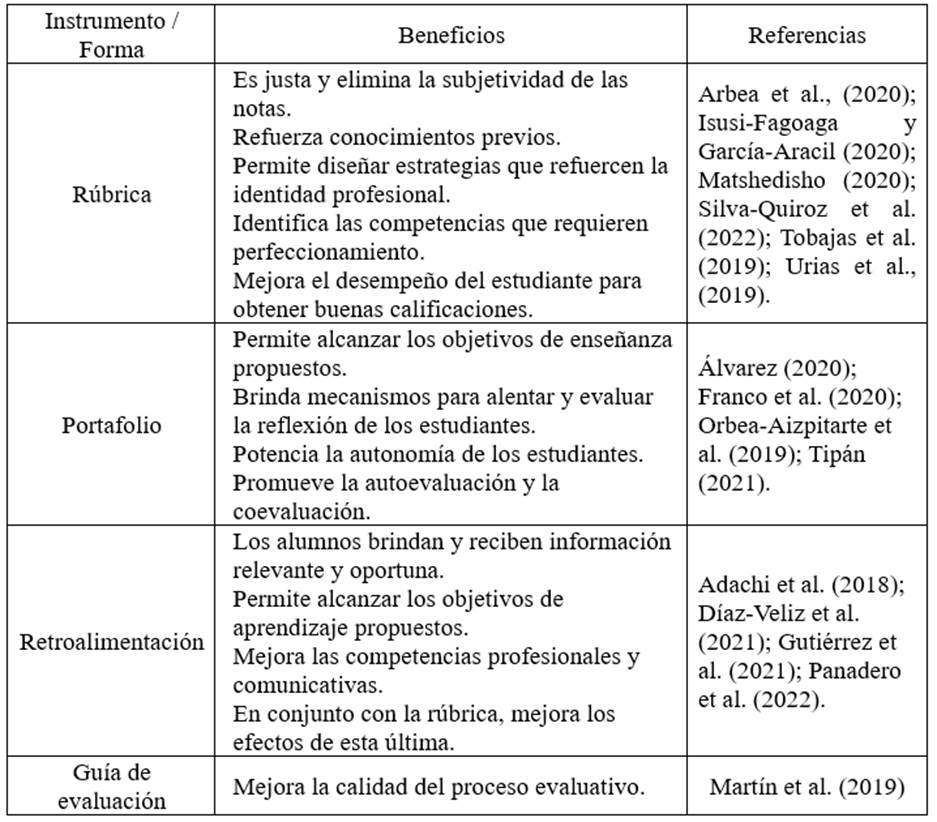

Los estudios que trataron sobre la formación de futuros docentes fueron predominantes (Adachi et al., 2018; Cañadas et al., 2021; Felipa & Páez, 2021; Gallardo-Fuentes et al., 2020a; González et al., 2018; Gray et al., 2019; Vallés et al., 2018). Gracias al uso de los instrumentos como la rúbrica o la guía de evaluación, los futuros docentes aprendieron a diseñar insumos adecuados que les ayudó a desarrollar aprendizajes de segundo orden. Además, proporcionaron información valiosa para identificar competencias en las que necesitaban alcanzar un mayor nivel de perfeccionamiento, las cuales son de utilidad en su futuro desempeño profesional, como las lingüísticas, por ejemplo. Los resultados más relevantes se muestran en la Tabla 2.

Tabla 2 Principales beneficios de los instrumentos en la evaluación de los estudiantes universitarios

Además de estos instrumentos, se incorporaron las TIC para complementarlos (Mendoza et al., 2021; Souza et al., 2022; Teodoro et al., 2022; Wild & Schulze, 2021). Los resultados de la versión digital fueron similares e inclusive superan el formato físico, ya que la virtualidad permite que los estudiantes se relacionen entre sí y verifiquen su propio progreso; además “

” (Quincho et al., 2022, p. 428). Asimismo, las TIC facilitaron la retroalimentación y la autoevaluación (Pérez-Guillén et al., 2022).la aplicación de instrumentos de evaluación en línea, está permitiendo que tanto docentes como estudiantes logren desarrollar competencias, las cuales permiten adecuar a las necesidades educativas y sirvan de apoyo en el proceso de enseñanza-aprendizaje

Las publicaciones seleccionadas se propusieron indagar el papel de los instrumentos de evaluación en la formación por competencias de los estudiantes universitarios. De esta manera, se observa un consenso al afirmar que los instrumentos aplicados beneficiaron la adquisición de competencias (Cañadas et al., 2021; Díaz-Mohedo et al., 2021; Díaz-Veliz et al., 2021; Oseda et al., 2020; Panadero et al., 2022; Prediger et al., 2020; Quincho et al., 2022; Suárez & Castro, 2022; Tsai et al., 2022; Vallés et al., 2018). También, otros estudios indagaron en competencias específicas como las históricas (Álvarez, 2020), clínicas (Martín et al., 2019), lingüísticas (Cantera et al., 2021; Gutiérrez et al., 2021) y digitales (Wild & Schulze, 2021); todos con resultados positivos.

La retroalimentación ayudó a que los estudiantes universitarios alcanzaran niveles óptimos en su escritura y su habilidad comunicativa, ambos asociados con la competencia lingüística (Felipa & Páez, 2021; Gutiérrez et al., 2021). En relación con las competencias digitales, el instrumento digital facilitó la creación de contenidos digitales y la resolución de problemas propios de los entornos digitales (Wild & Schulze, 2021). Por su parte, la guía de evaluación estableció criterios uniformes en la evaluación de competencias clínicas, logrando que las estudiantes de enfermería mejoraran su desempeño profesional (Martín et al., 2019). El e-portafolio fue útil para adquirir conocimientos sólidos y actualizados sobre la disciplina histórica y su enseñabilidad (Álvarez, 2020).

Asimismo, otros beneficios de utilizar los instrumentos de evaluación fueron: el refuerzo de conocimientos previamente adquiridos (Álvarez, 2020; Arbea et al., 2020) y eliminar la subjetividad de los procesos evaluativos y de las notas puestas por los docentes (Martín et al., 2019). Además de ello, también se demostró que, mediante los instrumentos de evaluación fue posible alcanzar objetivos de enseñanza (Díaz-Veliz et al., 2021; Franco et al., 2020). Esto último porque los instrumentos de evaluación permiten identificar aquellas competencias que necesitan refuerzo y desarrollo (Matshedisho, 2020; Tobajas et al., 2019).

PERCEPCIÓN DE LOS ESTUDIANTES

El análisis de los artículos demostró que los estudiantes universitarios se sintieron satisfechos con los instrumentos de evaluación (Díaz-Veliz et al., 2021; Gallardo-Fuentes et al., 2020b; González et al., 2018; Granberg et al., 2021; Gutiérrez et al., 2021; Mora-Luco et al., 2021). Asimismo, los estudiantes afirmaron que los instrumentos traen ventajas para su formación profesional como la autoevaluación y la coevaluación, y promueve un aprendizaje transformador que posibilita los niveles más altos de reflexión (Adachi et al., 2018; Gallardo-Fuentes et al., 2020a; Isusi-Fagoaga & García-Aracil, 2020; Pui et al., 2021).

Los estudiantes consideraron que la evaluación formativa es de apoyo para su carrera; además de que logra medir habilidades aprendidas con anterioridad, por lo que consideran a la evaluación formativa como ventajosa en comparación con la evaluación tradicional (Gallardo-Fuentes et al., 2020b). No obstante, hubo consenso en la necesidad de que los docentes generen en los estudiantes interés hacia los instrumentos, ya que, de no ser así, se puede evidenciar una respuesta negativa ante la aplicación de estos instrumentos (Arribas et al., 2019; Matshedisho, 2020).

Con base en estos resultados, las investigaciones recomiendan el uso de instrumentos de evaluación, teniendo en cuenta que los docentes los consideran métodos novedosos y objetivos (Almalkawi et al., 2021; Artiles et al., 2022; Mendoza et al., 2021; Tipán, 2021). Los instrumentos elaborados con estándares de calidad (Franco et al., 2020; Gray et al., 2019; Pancorbo et al., 2020; Silva-Quiroz et al., 2022) eliminan posibles inconvenientes durante su uso y traen beneficios tanto para estudiantes como docentes (Cantera et al., 2021; Martiáñez-Ramírez et al., 2022; Pérez-Guillén et al., 2022). Por ello, se recomienda diseñar instrumentos de evaluación en conjunto con programas de intervención para implementar acertadamente la evaluación formativa en las instituciones universitarias (Arbea et al., 2020; Flores & Alcalá, 2019; Regino et al., 2019).

CONCLUSIONES

Los instrumentos de evaluación en el contexto universitario revelan resultados beneficiosos para los estudiantes universitarios. De acuerdo con los artículos analizados, el desempeño académico de los estudiantes fue mejorado, al obtenerse buenos resultados en la adquisición de competencias profesionales. En específico, la rúbrica fue el instrumento que se aplicó en la mayoría de las investigaciones analizadas, eliminando la subjetividad al momento de colocar las notas e identificando aquellas competencias que necesitaron de reforzamiento. Así, los estudiantes universitarios alcanzaran niveles óptimos en su escritura y habilidad comunicativa, crearon contenidos digitales de forma más sencilla y adquirieron conocimientos sólidos y actualizados sobre su disciplina.

En relación con la percepción de los universitarios hacia los instrumentos de evaluación, las investigaciones revelaron que se sintieron satisfechos hacia esta nueva modalidad de evaluación, ya que afirmaron que traían grandes beneficios para su formación y posterior ejercicio profesional. Además, consideraron que estos instrumentos fueron de apoyo para su carrera y medían habilidades aprendidas con anterioridad. En el caso de los futuros docentes, los instrumentos de evaluación proporcionaron información valiosa para identificar competencias en las que necesitaban alcanzar un mayor nivel de perfeccionamiento.

Aunque en el estudio la aplicación de los instrumentos de evaluación en la enseñanza universitaria fue positiva, se debe ejecutar más investigaciones sobre el desarrollo de competencias profesionales en distintas carreras universitarias. Investigaciones futuras de este tipo deben abordar otros niveles de formación y abarcar un periodo más amplio. Asimismo, el uso de las TIC en los ámbitos educativos ha evolucionado la forma de estos instrumentos de evaluación, por lo que una investigación posterior debe evaluar en concreto la utilización de instrumentos de evaluación digitales.