Introducción

La incidencia algorítmica de la Inteligencia Artificial (en lo adelante IA) en los Derechos Humanos constituye la línea que inspira la redacción del presente artículo, en el que se detecta la necesidad de universalizar y sistematizar su futura normatividad, que emerge por el independiente avance del autoaprendizaje algorítmico de profundidad o Deep learning (Parte y Torres, 2018), al instituir el alma de la estructura de programación permitiendo un procesamiento de conjunto de datos para entrenamiento, validación y prueba, cuyo sistema se espera regularlo con jurisdicción internacional, de modo eficiente, de tal forma que las ciencias jurídicas y las informáticas puedan ser controladas, a fin de que esta revolución tecnológica no pueda convertirse -en un futuro indeterminado- en un dominio global carente de regulación moral (Bostrom, 2014).

De esta manera, las decisiones algorítmicas de aprendizaje profundo se futurizan hacia emanciparse totalmente de la decisión humana, se asiste al enfrentamiento de la IA respecto a los efectos universales de los derechos humanos que implican el soporte sobre el que se propugna modelizar patrones universales de integridad de los sistemas de aprendizaje automático de esta aplicabilidad informática, suponiendo así, configurar un posible entorno de regulación algorítmica transnacional con principios éticos.

El objetivo de este estudio es analizar los criterios de responsabilidad jurídica internacional que incluyan principios de humanidad y conciencia pública en la programación computacional de la Inteligencia Artificial.

El estudio pondera -adicionalmente- que el agente humano, experto en las ciencias y actividades de toda índole y en constante expansión, debe preservar su rol medular y avalador del comportamiento electrónico de la Superinteligencia definida como cualquier intelecto que se comporta de manera bastamente superior en comparación con los mejores cerebro humanos en prácticamente todos los aspectos y en especial: creatividad científica, sabiduría en general y desempeño científico o la llamada Singularidad explicada como una cinética de explosión de inteligencia artificial (Bostrom, 2014); por tal razón, el enfoque investigativo de aplicabilidad normativa universal de Derechos Humanos es fundamental para asegurar el bienestar común ante la expansibilidad aplicativa y constante de dicha revolución computacional respecto a los principios mencionados y de una ya no risible sublevación artificial.

Por consiguiente, se atisba un inquietante impacto de la IA en las ciencias jurídicas y particularmente en el respeto al paquete normativo de Derechos Humanos en la vida de las sociedades modernas, principalmente tras la nominación que la obra futurista de la IA nominada Vida 3.0 (Tegmark, 2018) le ha dado a esta alta capacidad computacional, cuyo argumento es consonante con el desarrollo del autoaprendizaje algorítmico con integridad humana, así como de la ingeniería del conocimiento y su cohesión con una correcta emulación de la subjetividad humana.

De ahí que la IA, al constituirse en bases de información que todos los seres humanos alimentan a cada segundo al expresarse en las redes sociales, en los formularios ocultos, en la ejecución de software instalados en teléfonos inteligentes, en tecnología de fines corporativos, industriales y militares; en fin, en todo aquello que exige aporte a números de datos a las redes, públicas o privadas, (Venezolana et al., 2020), debe regularizarse en sus respectivos y futuros sistemas algorítmicos a fin de evitar dictaduras digitales que puedan concentrarse en una élite minúscula. Así, se podría preservar su filosofía de sistema automático y autónomo, pero irradiado de la humanización programada de sus códigos de programación, que evitará que la IA superinteligente pueda atentar, en un futuro no lejano, contra los principios connaturales a los derechos fundamentales.

Metodología

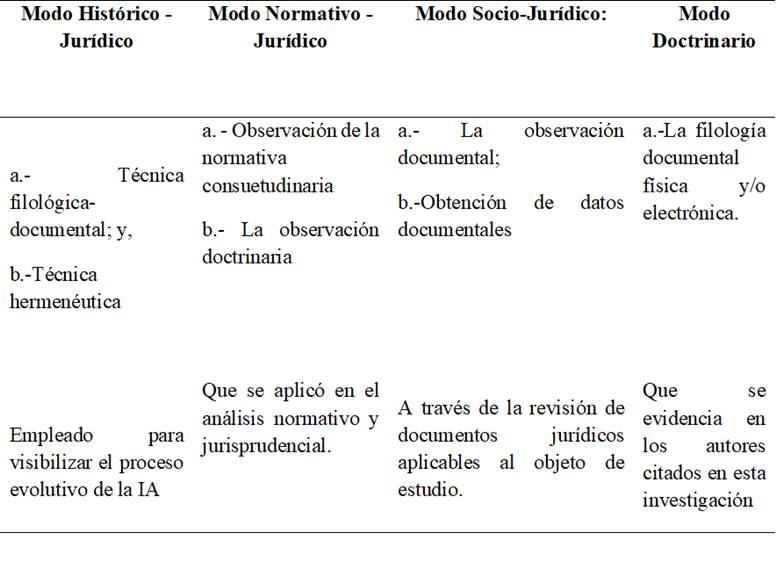

Se abordó problemática indicada desde los enfoques o modos: histórico jurídico; normativo-jurídico y doctrinario, apoyados por una comparación o análisis de dichas fuentes.

Las técnicas de recolección de datos y análisis de los mismos que se implementaron en la investigación son las siguientes, de acuerdo a los modos, a saber, de los expuestos en la tabla 1, en la que se se muestran los métodos empleados para la investigación:

Fuente: Elaboración propia

Resultados y discusión

Escenario e interrogantes para la IA en el mundo actual.

La IA está afectando cada vez más la vida humana e intenta reemplazar los valores éticos y sensibilidades humanas por actividades centradas en la fiabilidad computacional, por ejemplo, en las directrices de conciencia que se proponen en plataformas virtuales que se desarrollan con los algoritmos basados en el análisis de los requisitos y los proyectos orientados a fines específicos, que es la base para el desarrollo de software (Ocaña-Fernández et al., 2019).

Precisando dichos fines, se pueden enfocar éstos respecto a los automotores tipo Tesla que se multiplican por las carreteras del mundo, las herramientas de diagnóstico médico para profundizar la detección de patologías clínicas, los sistemas electrónicos de sugestión adquisitiva de artículos registrados en páginas web que utilizan software de reconocimiento de elegibilidades históricas para analizar el gusto de los usuarios y optimar la satisfacción de compra; de igual forma, los análisis predictivos de IA en servicios financieros, fiscales y en el ámbito criminal, para ser filtrados en los sistemas de justicia, donde se aplican configuraciones de vigilancia automatizadas por doquier, y lo que es más, bots (Mejía, 2020) de matar y nuevas tecnologías de IA armadas para la defensa militar de los países.

De alguna manera, los sistemas de aprendizaje inteligente no son nada nuevo, ya que han sido útiles en varios aspectos, como la geografía, los circuitos eléctricos, el diagnóstico médico, la informática y la programación, la transmisión móvil y la química, etc. Así tenemos que la IA confluye todo un sistema variado de potentes aplicaciones basadas en minería de datos que permiten sistematizar la toma de decisiones, usando a la tecnología (Syloper, 2015). Sin duda alguna, estas tecnologías pueden mejorar el bienestar de los humanos. No obstante, presentan problemas consustanciales, resultantes de la imperfección de las aplicaciones de IA y del cual surge la siguiente interrogante: ¿Podemos transferir los derechos humanos a una IA representándola en programación computacional? Identificar y codificar los objetivos finales es una tarea difícil porque las representaciones humanas son complejas (Bostrom, 2014).

Ergo, la comunidad de la IA exige acciones globales inmediatas, pues siendo las críticas cada vez más fuertes sobre la galopante brecha jurídica al respecto, son los gestores de las empresas transnacionales y las gobernanzas estatales de turno con dicha capacidad, aquellos que deben de responsabilizarse en cooperar internacional e interdisciplinariamente, con la debida precaución respecto a las particularidades exclusivas en la elaboración de sistemas de profundización analítica del algoritmo, a fin de que impacten positivamente en los principios normativos pro ser humano, bajo la autorización estatal y legal que al respecto debe configurarse.

El dominio de la IA: ¿Un escenario que margina los DDHH?

Frente a la realidad de la presencia de la IA en las sociedades modernas, las personas comunes, las corporaciones y las naciones, están ya lidiando con las brechas legales y éticas de su uso (Violino, 2018). No obstante, se advierte que a medida que la industria de la tecnología continúa creciendo y perfilando la forma en que la sociedad interactúa en un mundo globalizado, la regulación de la IA ha sido relegada peligrosamente (Erdélyi y Goldsmith, 2020), de tal forma, que las corporaciones transnacionales han aplicado -en paralelo a dicho avance- la capacidad de aprendizaje automático en sus productos y servicios, soslayándose que la difusión de esa tecnología implique grandes alcances.

En la enmarcación del problema, es necesario evocar que la IA podría ramificarse a diferentes destinos identificados, tales como; 1) automatizar los procesos de capital; 2) el acopio de la información receptada y generación de criterios de toma de decisión para corporaciones; y, 3) autonomía absoluta e independiente a la interacción humana frente al servicio público o privado.

En la especie, Davenport y Ronanki, (2018) examinaron 152 proyectos de empresas que utilizan "tecnología cognitiva", que es sinónimo del conjunto de técnicas, distinguiendo a la automatización y las labores de intervención humana. Esto incluyó la serie automatizada de las tareas financieras y administrativas. En la estadística aplicada, 71 de los 152 proyectos (46%) se expusieron como robótica y automatización cognitiva, 57 (38%) se delinearon como conocimiento cognitivo; y, 24 (16%) se clasificaron como proyectos de participación cognitiva, lo que confirma la amplia participación de la IA en estos campos centrales del control económico y político de las sociedades.

En esta perspectiva, los autores han referido que la primera clase de destino (automatización de procesos de capital) es la inversión más dúctil y ahorradora de la tecnología corporativa, debido a que, produciría un alto retorno de las inversiones. Sin embargo, es notable que el segundo destino (acopio de información y toma de decisiones), tenga el mayor impacto en ciertos derechos reconocidos, tales como, los derechos humanos, de privacidad y de no sufrir discriminación, ya que, la capacidad cognitiva electrónica de la IA para predecir el comportamiento del consumidor, identifica defraudaciones, automatización en el marketing focalizado a cada usuario y trata masivamente los datos, siendo esta la más reconocible respecto a las regulaciones jurídicas, justamente por afectar derechos inmediatamente detectables como aquellos devenidos de la identidad y la privacidad de las personas.

De modo análogo, Maestre (2020) ha señalado que, una Fintech Europea denominada Advicerobo, intenta generar nuevas ideas y determinar cómo se entienden y entregan los servicios financieros a través de nuevas tecnologías de la información, aplicaciones móviles, entre otras, que revolucionaron a los riesgos con el nuevo sistema de puntuación de crédito psicográfico, que aprovecha la IA de Microsoft para facilitar a los bancos europeos la estimación de inseguridad y la solvencia del cliente, analizando las características del consumo psicológico, estilo de vida, emociones, intereses, deseos, de esta forma, una supuesta “voluntad” de pagar los préstamos y ver qué producto de este tipo es el más adecuado para sus circunstancias (Ramírez, 2018).

Estas prácticas plantean el riesgo de someter a las personas de determinados grupos de población a la detección discriminatoria de mentiras o al rechazo sesgado de solicitudes, pues se basan en estudios inclinados hacia la biometría (Kaspersky, 2021), características físicas que pueden utilizarse para identificar a las personas; la clasificación de huellas dactilares, el reconocimiento facial y el escaneo de la retina son formas de biometría, así como las mejores opciones conocidas, tanto para resolver o captar desde servicios personales hasta la colocación de los capitales financieros, generando con ello presuntos falsos positivos o negativos de oportunidades personales soportadas en la autonomía de algoritmos programados.

Como resultado, se percibe un aumento significativo del uso de la tecnología y el dominio de la inteligencia artificial sin las regulaciones necesarias. Un ejemplo claro de aquello es la República Popular China, que aplica procedimientos de reconocimiento facial y registro de datos a los propietarios de nuevos teléfonos, lo que genera polémica en el gigante asiático (BBC News Mundo, 2019).

Como corolario a todo aquello, las conclusiones de las implicaciones cibernéticas de la IA, según Kambil (2016) de la Consultora Deloitte University Press, define que al llegar a la era inicial de la computación cuántica -punto de inflexión futura de la IA cuando ésta se universalice- con el tipo de algoritmos y modelos de datos que ésta puede soportar, la modelación predictiva del riesgo puede volverse un componente aún más valioso de la administración del riesgo (Bragado, 2003), pudiéndose así cambiar potencialmente el juego, la capacidad, el detalle y el conocimiento, que dominen posiblemente, todas las esferas de los análisis masivos de datos, a una velocidad impensada por el ser humano.

La potencialidad deprimida del Soft Law frente a la IA.

La opacidad del sesgo de la programación algorítmica de la IA crea incertidumbre y problemas de aplicación efectivos de los derechos humanos, especialmente la privacidad y la integridad humana, que se ven amenazados por el uso de IA en las empresas, entre los cuales la libertad de pensamiento, expresión, seguridad, al hecho de no sufrir discriminación, a la asociación y sociedad pacífica, al trabajo y la libre elección de empleo; y finalmente, al orden social y universal, en violación directa a los artículos 3, 7, 19, 20 y 28 de la Declaración Universal de Derechos Humanos (1948), en su orden. Todos estos principios merecen ser objeto de un análisis ponderativo de fortalezas y debilidades de la aplicabilidad jurídica de sus preceptos en la IA.

En sentido sinalagmático, la propuesta del Reglamento del Parlamento Europeo y Normas Armonizadas, emitido en Bruselas (Abril, 2021) ha advertido que si la IA no es controlada en cuanto a los efectos antes citados, derechos fundamentales, aquello podría tener repercusiones negativas respecto a la Carta de los Derechos Fundamentales de la Unión Europea principalmente al derecho a la dignidad humana (artículo 1), el respeto de la vida privada y familiar y la protección de datos de carácter personal (artículos 7 y 8), la no discriminación (artículo 21) y la igualdad entre hombres y mujeres (artículo 23) así como efectos paralizantes sobre los derechos a la libertad de expresión (artículo 11) y de reunión (artículo 12), frente a la garantía a la tutela judicial efectiva y a un juez imparcial, la presunción de inocencia y los derechos de la defensa (artículos 47 y 48), y finalmente el principio de buena administración.

Un escenario publicitado de ausencia de legislación internacional y de falta de poder sancionatorio ante una eventualidad del dominio decisional de la IA, lo constituyen los programas que almacenan y rastrean datos de usuarios en sitios web, pues pueden infringir el derecho a la privacidad y utilizan estos datos para orientar anuncios a través de la coincidencia de patrones de IA, tal como el famoso caso de la consultora Cambridge Analytica (Lozano, 2018), donde los datos sobre el abuso de la empresa de 50 millones de usuarios de la red social Facebook durante la campaña presidencial estadounidense de 2016 pusieron en observancia las repercusiones legales de esta red electrónica respecto a su representante ejecutivo, Marck Zuckerberg.

En una disyuntiva positiva con aquello, la científica Poppy Crum durante la charla en Technology, Entertainment Design (TED Spaker, 2018), declaró que se podrían implementar cámaras con la biometría suficiente para detectar las intenciones y designios de las personas, utilizando a la IA para hacer coincidir los datos de los casquillos de electroencefalograma térmicos, imágenes y monitores de frecuencia cardíaca para definir juicios e ideas humanas. El dominio de la comunicación multimodal de la maquinaria humana, deja muchos desacuerdos en el uso de los robots humanoides y en todas las nuevas tendencias de desarrollo de la robótica, ya que difícilmente pueden ser la clave al generar el sentido común de todo ser humano que interactúa naturalmente (López-De Mántaras, 2018).

Por ejemplo, el grupo de expertos Jigsaw (2013) impulsó una aplicación de nombre Perspective que utiliza el aprendizaje automático para crear una puntuación para el impacto dañino de un comentario en un blog o artículo permitiendo que los productores de contenido decidan qué hacer con el comentario en función de esta puntuación; su funcionamiento podría disminuir el trolling o troleo tóxico en Internet; el problema ético surge del hecho de que los usuarios no sabrán cómo la IA desarrolló la puntuación y quién determinó lo que se considera dañino (Ramírez, 2021). La tecnología con esta capacidad aún se encuentra en etapa de prueba, pues se cree que la IA sabrá más de los humanos que ellos mismos.

Es aquí donde, la independencia de pensamiento y locución de informaciones, pueden estar implicados, porque la IA ha configurado, en muchas ocasiones, la tarea de analizar las opiniones de los beneficiarios de los sitios web, así como, excluir de forma selectiva a aquellos que cumplen cierto criterio de respeto y razonabilidad, desechando los contrarios.

Un aspecto objetivable y casi concomitante a la invención de la IA es su correlación con el aspecto fiabilidad sostenible de la alimentación de la información, pues se considera una de las mayores admoniciones negativas de esta tecnología (Prabhu, 2018), dado que la IA aprende de los datos que recibe, los operadores que ejecutan dicha tecnología, en fase de prueba, utilizan datos corporativos de prueba que eventualmente emplearán el bien/servicio, lo que puede generar fuga de información de la estructura de gobierno de datos y traslucir información corporativa a agentes externos.

Es así que, un hipotético instrumento de regulación jurídica de la IA sin poder de control y/o sanción, puede representar una seria amenaza para la humanidad cuando esté disponible para aquellos que quieran desarrollar dispositivos autónomos, que no requieran intervención humana (Simpson y McLendon, 2022). Un ejemplo latente de aquello es la actual manufactura de aprendizaje automático e independiente de los inventores físicos, como la vanguardista ingeniería de Google ejecutada por Goldie y Mirhoseini (2020) que ha creado un sistema de IA que diseña chips tan buenos como los erigidos por los humanos, pero en una fracción de tiempo de lo que tardan en diseñarlo aquéllos, basado en un sistema de premios y castigos (Mundo, 2021) inspirados en la psicología conductista, cuyo mecanismo de creación no asegura la dirección social en la que fueron concebidos.

Como se puede ver, la discriminación de la IA es un problema preocupante porque depende de la psiquis y por tanto, del criterio del programador. Por ejemplo, un estudio implementado por MIT Media Lab, planificado para proyectos de investigación sobre asociaciones con capacidades de diseño, multimedia y tecnología, encontró que un software de reconocimiento facial basado en IA tenía una precisión del 99% cuando se le presentaban imágenes de hombres blancos, pero tenía un 39% por ciento de precisión y una tasa de error del 5% para las mujeres con piel más oscura (Lohr, 2018).

Otro ejemplo latente, es el caso People vs. Loomis (Corte Suprema de Justicia 2015, EE.UU.), en el que se resolvió extrañamente en la instancia de apelación la constitucionalidad de la herramienta informática denominada “Compas” en cuanto a la evaluación cuantitativa y cualitativa de los beneficios de regímenes de libertad condicional en el Estado de Winsconsin, lo cual -a todas luces- violenta el derecho de comprensión y entendimiento de todo fallo judicial al sobrevalorar la fiabilidad de las nuevas tecnologías y descansar en ellas ciegamente a la hora de tomar las posiciones y decisiones que corresponden a los diversos agentes, (Castellanos y Montero, 2020) constituyéndose ésta en la segunda decisión estadounidense que apertura una determinación irrefragable de “eficacia”.

En la especie, el primer fallo relacionado con aquél, en el citado país norteamericano, ha sido el tristemente pionero caso Indiana vs Malenchik (Corte de justicia de Indiana, 2010), en el que se considera haberse violentado los artículos 7 (No discriminación) y 8 (Recurso efectivo) señalados en la Declaración Universal de los Derechos Humanos (Asamblea General de las Naciones Unidas, 1948), y las disposiciones 24 (Igualdad ante la Ley) y 25 (Protección Judicial), instrumentos de los cuales el país norteamericano es signatario desde 10/12/1948 (Paris) y 06/11/1977 (San José de Costa Rica).

El derecho de reunión y asociación pacífica también se ve implicado en las redes electrónicas de IA para regularizar el comportamiento en foros virtuales, cuya modulación jurídica la ha tratado de evocar la libertad de expresión en el uso del internet la Organización de Estados Americanos (OEA, 2009). En la especie, Rico-Carrillo (2012), refiere que, dentro de las bases de la aludida declaración, debe promoverse este derecho en redes sociales no obstante ser necesario distinguir excepciones para el caso de su uso impúdico ante la dignidad e imagen de las personas como cuando se trata de personas vulnerables como los menores de edad, con las debidas sanciones como las ejemplarizadas en la legislación interna.

Uno de los campos evocados al iniciar este estudio fue la amenaza de reemplazo de la IA a trabajos humanos, que se constituye en una advertencia posible si esta tecnología se vuelve lo suficientemente competente para este particular. El ex ejecutivo de Google, Apple y Microsoft, Kai-Fu Lee, señaló que hasta el cuarenta por ciento (40%) de las labores humanas será reemplazada por inteligencia artificial en tan sólo quince o veinte años (Díaz-Meco, 2020). Por ejemplo, los empleados de servicios al cliente ahora han sido reemplazados por chat-bots (Peris, 2017).

En muchos otros casos, se convierte en un socio virtual integrado en sitios web, aplicaciones, conversaciones, considerando a la IA de percepción (reconocimiento facial y otros biométricos), la IA de Internet ya presente entre nosotros (Google, Amazon, Alibaba), la IA empresarial (seguros, bancos, hospitales) y la IA autónoma, que es la de más impacto (drones, autos, robots inteligentes).

Dentro de este índice, Bill Gates, Stephen Hawking y Elon Musk advertían de los riesgos de la posible creación de una IA superior al cerebro del hombre que se tornase en contra de los seres humanos (Sainato, 2015). En 2018, el presidente de Microsoft, Brad Smith, exigió públicamente la regulación jurídica en el uso de la IA, y particularmente de la tecnología de reconocimiento facial, siendo este particular muy importante porque justamente las corporaciones gozan de absoluta discreción para diagramar la dirección de la IA, sin control alguno.

Uno de los ejemplos más claros de este particular lo encontramos en el descontrol actual del uso de armas autónomas, donde drones militarizados habrían atacado por primera vez a seres humanos, de forma totalmente independiente y sin la guía u órdenes oficiales, generando bajas personales según informe de Naciones Unidas (ONU, 2022), hecho ocurrido en Marzo/2020 durante la guerra civil en Libia, escenario que fue advertido antecesoramente (Tegmark, 2018) al referirse que:

“[…] los drones dotados de IA del futuro podrían hacer innecesaria toda intervención humana, usando un algoritmo para elegir sus objetivos y a quién matar […]”. (p. 141) Señalando en su ya indicada obra Vida 3.0 que, en la actualidad: “[…]resulta tentador eliminar cualquier intervención humana para ganar rapidez en una refriega entre un dron del todo autónomo capaz de reaccionar al instante y otro que lo hace más despacio porque lo controla remotamente un humano situado en la otra punta del mundo ¿Cuál cree usted que se impondrá? […]” (p. 143)

La respuesta lógica a esta interrogante citada, cae por su propio peso.

Algo similar pronunció la Corte de Justicia de Alabama- Estados Unidos de Norteamérica, en el caso Holbrook (2021) en la sentencia contra Prodomax Automation (People vs. Prodomax), donde se alegó reclamos por negligencia por diseño y responsabilidad del producto contra los acusados, respecto a los fabricantes de un robot que ingresó a una sección de la fábrica donde se suponía que no debía, aplastando el cráneo de la empleada Wanda Holbrook mientras estaba realizando sus tareas de mantenimiento como técnico.

Exteriorizado el actual escenario tecnológico de la IA frente a las experiencias judiciales de derecho comparado, es claro que los principios internacionales nominados, muy a pesar de propender a la transparencia algorítmica, no han calado suficientemente al traslucir ético y/o proteccionista frente a la violación de derechos fundamentales en su ejecución post codificación, pues simplemente aquello ha desbordado el campo actual de la regulación en desarrollo, el bloque internacional de derechos humanos que ya constan legislados y/o las políticas y valores enfocados a declaraciones de regulación de la IA.

Concretamente, la Declaración de Toronto sobre la Protección del Derecho a la Igualdad y la No Discriminación en los Sistemas de Aprendizaje Automático (UN Human Rights Committee, 2018), modifica el Convenio para la Protección de las Personas con respecto al Procesamiento Automático de Datos Personales (Consejo de Europa, 1981) sobre los impactos de los sistemas algorítmicos en los derechos humanos, entre otros, no fueron configurados para exteriorizar el sesgo de la subjetividad decisional que sus programadores conscientes y/o inconscientemente hayan formulado, y por tanto, sus designios no guardan garantías indiscutibles de responsabilidad.

En el marco europeo, un punto focalizado jurídicamente lo constituye el Libro Blanco de la IA (Comisión Europea de Bruselas, 2020) en que la Comisión Europea publicó siete directrices perfectamente definidas, a saber: acción y supervisión humana, solidez técnica y seguridad, gestión de la privacidad y de los datos, transparencia, diversidad, no discriminación y equidad, bienestar social y medioambiental y rendición de cuentas, no obstante dejo entrever que el marco regulador deber agudizarse en una profundidad analítica mayor ante el velo de la programación algorítmica que la irradia, observándose también que debe asegurarse un margen para acoplar su vertiginoso desarrollo.

Es preciso indicar que una sanción coercible sobre las corporaciones y los Estados que las han creado, por el fundamento técnico que caracteriza a la programación informática, y la ausencia de legislación de control algorítmico al respecto, así la DUDH adolece de los mismos defectos de gran parte de la normativa internacional ante el avance vertiginoso de esta revolución informática, esto es, regulación que permita descubrir el velo de su sesgo programático, convirtiéndose así esta falta de ejecución directa de acciones sobre los Estados Partes, en derecho blando o Soft Law.

Sin perjuicio del conflicto positivo o negativo con legislaciones desarrolladas a partir de ésta, no obstante, la DUDH sí ha construido un conjunto de normas que ha servido de base para futuros tratados que tienen fuerza vinculante. En igual sentido, en un intento de modular estas abstracciones jurídicas, para 2020, se propuso un diseño de recomendaciones por el (GEE) Grupo Especial de Expertos y la UNESCO (2020), donde propugna acertadamente variables significativas de protección para el ser humano y la ética frente a la configuración de la IA. No obstante, se relativizan referencias respecto a la supervisión, evaluación del impacto y diligencia debida para garantizar la rendición de cuentas, generando con aquello, nuevo derecho blando respecto a un tema que requiere órganos rectores internacionales y disuasión jurídica global coercitiva.

Es claro así señalar, que el sistema jurídico transnacional tiene configuraciones generalizantes, que obran esgrimidas en el Pacto Internacional de Derechos Civiles y Políticos (PIDESC) y el Pacto Internacional de Derechos Económicos, Sociales y Culturales (PIDESC) que se derivan de la Declaración Universal de Leyes, que entraban en vigor si se establecía la Comisión de Derechos Humanos para supervisar la implementación y el cumplimiento del Pacto Internacional de Derechos Civiles y Políticos; de igual forma, en la Comisión de Derechos Económicos, Sociales y Culturales (CESCR) que realiza funciones de supervisión sobre los reclamos y requisitos de igualdad de derechos y libertades de las personas (Ferrer-Lues, 2007; Martínez-Hincapiere, 2014).

Finalmente, el primer intento de cristalizar los derechos de humanidad y conciencia digital en la IA, se esboza en Reglamento del Parlamento Europeo y Normas Armonizadas, emitido en Bruselas (Abril, 2021), que constituye el precursor jurídico pionero y mundial que contiene una propuesta de una medida futura de control de la repercusión de la IA.

Posibles soluciones de la Regulación Jurídica en la adaptación de la IA.

La normatividad futura de la IA requiere un corte transversal global, de la que es necesario separarse de su visión tradicional, a fin de poder definir claramente el camino jurídico a seguir. Al inicio de este estudio, se consideró que el derecho blando (Soft Law) no es suficiente para disuadir un eventual comportamiento antiético de los programadores ante la presencia dominante de la IA en su enfrentamiento al estadio actual del Derecho Internacional, latente en cada configuración abstracta de cualquiera de las disposiciones jurídicas que actúan como principios, reglas y directrices a seguir.

Para comprender esta cosmovisión jurídica es necesario distinguir que no es el derecho duro o sancionador la respuesta efectiva al sistema jurídico que esta tecnología requiere, sino que la dinámica normativa transnacional se ha vuelto inefectiva en razón del estatus neófito de la legislación internacional sumado a lo que podría aplicar discrecionalmente cada Estado Parte, al respecto.

Para clarificar y justificar la distinción de “ley dura” De Lucas (2019) exterioriza, Hard Law se caracteriza por ser el conjunto de declaraciones, resoluciones y programas de acción, que demuestran conformidad ante las normas establecidas por el Derecho Internacional con posibilidad de aplicación interna y su diferenciación con la “ley blanda” (Soft Law), es que al ser más permeable y flexibilizar la entrada de acuerdos entre naciones no tiene dicha posibilidad de transversalidad directa de la que emerge su diferenciación, aunque, en un contexto nuclear de las prerrogativas e inconvenientes relativos de la legalización dura y blanda y los diversos factores determinan las preferencias en su aplicabilidad jurídica frente a la regulación futura de la IA (Gutzman y Meyer 2010).

Se puede entonces inferir que, la primera (Hard Law) correspondiente al “derecho duro”, que se basa en la normatividad estricta y se caracteriza típicamente por un marco existente de pautas legales antepuestas, oficiales y aplicadas por las jurisdicciones justas, con el tópico garantista de aseguración del precepto aplicado, podría alentar la confianza transversal de los Estados, así como disuadir los intentos incidentales de obstaculizar los eventuales hechos que se presenten.

No obstante a aquello, el Hard Law, como todo elemento estricto, contiene ciertas características infraestructurales de su propia rigidez, respecto a la seguridad jurídica interna y la flexibilidad que podrían no adaptarse a los criterios de valor gubernamentales de cada Estado, así como la absolución de consultas de reglas. Estas características son nuevamente observadas por Guzmán y Meyer, guardando tópicos de ceñimiento a los que deben adaptarse los gobiernos, y que generan aspectos como los de coordinación legal de las normas internacionales en consonancia con las nacionales, beneficios marginales versus perdidas disuasivas del derecho sancionador, la aplicabilidad la sanción de la ley dura o la revolución de la ley blanda, y las interpretaciones realizadas por instituciones internacionales de derecho y su vinculación o no al derecho interno de cada Estado (Guzmán y Meyer 2010).

En la especie, los tipos de subcomités sobre la Protección de los Derechos Humanos de las Naciones Unidas y Protección, de conformidad con la Resolución 2003/16 de agosto de 2003, propusieron un anteproyecto de normas en el documento, anticipándose a mayores obligaciones corporativas respecto a la materia de derechos humanos, en que los Estados se responsabilizarán por la protección y el respeto de éstos, y es aquí que, en el análisis se puede predecir que no se ha asignado adecuada responsabilidad de preservación de los derechos humanos entre el Estado y las empresas, es decir, de incidentes focalizados a la determinación de responsabilidades a la IA actuante y su afectación a sus responsables programáticos (Business y Human, 2017).

El Consejo de Seguridad de la ONU (2011) como influyente protagonista de la validez jurídica de la IA, considera que dentro de las regulaciones de la humanidad se aprobó la Resolución 17/4, donde se consideran vínculos de estándares y prácticas que todo Estado y toda empresa debe de seguir, al respecto.

Esto puede verse en el lenguaje introductorio, que establece que los Principios se aplicarán a todos los Estados y a todas las empresas comerciales, tanto transnacionales como otros, aparte de zona, localidad, ubicación, propiedad y estructura. Pese a, la introducción, también deja en claro que estos Principios no son obligatorios, pues su naturaleza es absolutamente potestativa, más aún, así determina positivamente que estos deben sostener el respeto por los derechos de las empresas comerciales con las que realizan transacciones comerciales, lo que es necesario, por decir lo menos, exponerlo como una decisión gubernamental de los países hasta poder sopesarlo en los sistemas jurídicos de los Estados partes.

En materia de responsabilidad de las corporaciones, se preserva la tesis del control en tiempo real y la coercibilidad jurídica transnacional a través de los instrumentos internacionales respecto a la IA, pues tal como lo ha acertado Solar Cayón (2019), la maximización regulatoria de esta revolución tecnológica debe ser preeminente en la corporativa frente a la individual.

En la especie, estas regulaciones denotan el énfasis de generar obligaciones jurídicas transnacionales por los derechos humanos, pues desde ya consignan un soporte para la normativización del uso ético a nivel corporativo de la IA, siendo la meta laboriosa respecto a este particular, determinar jurídica y técnicamente como arribar a identificar el sesgo programático y/o el perjuicio y su nexo causal sin duda razonable, respecto a quienes obraron negligente o dolosamente (De Asís y Ansuátegui, 2020), pues, es justamente este nodo crítico el llamado a desglosar mecánica y/o pericialmente para el establecimiento de responsabilidades para las autoridades futuramente competentes.

Respecto a las consecuencias de los daños que pueda producir la IA, en un informe del Brookings Institution West (2018), se distinguieron especiales aspectos benefactores respecto al correcto desarrollo de aquélla, a saber: contratación de especialistas en ética de la empresa, generar de un código ético de inteligencia artificial, instituir juntas de revisión de inteligencia artificial, exigir pistas de auditoría internas de inteligencia artificial, implementar programas de entrenamiento; y, disponer de un medio de reparación por daños o perjuicios relacionados con la inteligencia artificial, cuyas distinciones se consideran acertadas respecto al indicado marco que debería incluir la IA.

En la parte judicial, el operador jurisdiccional de la ONU (2012), tiene competencia de absoluciones respecto a asuntos pedidos por el órgano rector, como la Asamblea General y agencias especializadas. Hasta la fecha, la Corte Internacional de Justicia no guarda precedentes judiciales respecto a perjuicios corporativos respecto al uso de la IA. No obstante, una absolución de consulta sobre estos temas podría ser solicitado por la ONU o sus estados miembros, en los que pueda alegarse abusos sobre derechos humanos, como parte de sus facultades.

En otro espacio jurisdiccional, la Corte Penal Internacional (2018), tribunal de última instancia para el enjuiciamiento de crímenes graves internacionales, como el genocidio, los crímenes de guerra y los delitos de lesa humanidad, tiene soporte en el estatuto y jurisdicción sobre las reclamaciones formuladas contra las personas e infiere a que no son imputables las empresas transnacionales, pues solo pueden ser juzgadas personas naturales.

En cuanto a la tipificación jurídica de eventuales demandas internacionales, éstos no guardan la consonancia penal de dicha competencia, ya que según el aludido Estatuto, tales reclamos únicamente pueden verse por actos de lesa humanidad, tales como atentados mundiales de genocidio, crímenes contra la humanidad y guerras, en cuyo caso un abuso de derechos humanos causado por la IA tendría que elevarse al nivel de estos crímenes, para generar un debido proceso, garantizado por la propia Corte y la ONU.

Otro punto relevante a destacar es que, ejemplarizando al Tribunal Europeo de Derechos Humanos (2023), que bien podría convertirse en una corporación jurisdiccional útil para presentar demandas por el uso indebido de la IA contra empresas transnacionales en el futuro, el particular encontrado en dicho organismo es que, no es posible la aplicación directa y transversal del reclamo del derecho hasta que se hayan agotado todos los recursos del sistema jurídico de la nación donde se origina, dejando así un vacío procedimental en los sistemas jurídicos internos, que no cuentan con este tipo de legislaciones.

De igual manera, en el Convenio Europeo de Derechos Humanos se negó los efectos que generan las compañías respecto a su alcance respecto a derechos humanos frente a la IA, y en su lugar se dispuso discutir los deberes del Estado para proteger a las personas contra las muertes de daño debido a las operaciones tecnológicas causadas por corporaciones, lo que hizo que, en un intento transversal judicial, aflore la Carta Ética Europea de Derechos Humanos (Comisión Europea para la Eficiencia de la Justicia, 2018), a objeto de responsabilizar a las corporaciones respecto al diseño y despliegue de herramientas y servicios de inteligencia artificial que implican el procesamiento de decisiones judiciales y datos (aprendizaje automático o de otro método derivado de la ciencia de datos).

Este último precedente sugiere que se constaten casos en el indebido uso de la IA, como han sido los incidentes graves ejemplarizados de su impacto en la humanidad, lo que hace que se detecte como absolutamente necesaria una cooperación inter partes de Estados a nivel internacional que descubra la necesidad de hacer emerger un órgano rector de regulación de responsabilidades corporativas principales y solidarias de esta tecnología, a fin de que estos aspectos presentes puedan sustanciarse y resolverse como puntos focales e inciten a un debate intergubernamental y políticas públicas transnacionales que merezcan ser declaradas de inmediatísima atención, en vista los hechos suscitados en el campo internacional del desarrollo de esta tecnología.

Esto implica sustraer inclusive, un nuevo contrato social tecnológico entre los Estados, que active la flexibilización de los diálogos de IA ético que se integren al desarrollo de esta tecnología más, allá de la deducción lógica de la norma tal como lo propugna Bart Verheij (Rodríguez Puerto, 2020), amén de balancear ponderativamente los valores de la soberanía frente a la autonomía estatal, audite integralmente la información, costes y avances autónomos de ésta, y salve los nudos críticos que puedan presentarse en el desarrollo en tiempo real de ésta (Burgoa-Toledo, 2011; Verdonck, 2016).

Conclusiones

En este estudio, se han podido identificar que frente al impacto de la IA el Derecho Internacional exige el acompañamiento de un nuevo sistema que respalde y ejecute transnacional y obligatoriamente, la regulación al sesgo subjetivo existente en la formulación, diseño, desarrollo, despliegue, aplicación y la evolución de decisiones de sistemas de este tipo, pues su estructura jurídica emerge de los elementos de base abiertos que irradia los principios contenidos en los instrumentos jurídicos transnacionales, de tal suerte que cualesquiera que estos fueren aplicados, por identificarse como reglas abiertas, no solucionarían finalmente un incidente concreto.

Un factor importante en cualesquiera de las estructuras jurídicas a aplicarse en la regulación de la IA, lo constituye la exigible atención a la arbitrariedad del pensamiento del programador humano sin la asistencia de juicios y sistemas de expertos en la ingeniería del conocimiento abordada, que coadyuven a nivel deontológico y epistemológico a sostener en el algoritmo la racionalidad subjetiva de las que carecen -en la mayoría de casos-.

La actuación unilateral de sus diseñadores y la IA ha abierto un camino peligroso que desvirtuaría el carácter ético de su ejecución de su ejecución, lo cual hace necesario reconfigurar los intereses jurídica y socialmente relevantes tales como la libertad, igualdad, dignidad, debido proceso, privacidad, libertad de expresión, en la cadena virtual de invención codificada de procesos, a través principios de humanidad y responsabilidad digital en derecho duro y blando de transversalidad internacional.

De su lado, los Estados no han impulsado -seriamente- la creación de un organismo rector internacional que controle las fórmulas tecnológicas ni jurídicas con mecanismos de responsabilidad estatal de prevención, respeto, remediación, discusión continua de actualización de estándares de la IA, buscando crear óbices de control, principios soberanos así como las políticas de guía entre el régimen jurídico de los derechos humanos, el poder de investigación y el desarrollo algorítmico de las empresas, lo que ha deprimido la latente necesidad del contrapeso que la hegemonía de la IA necesita para regularla prospectivamente.

Se hace necesario así, hacer emerger un modelo conceptual validado previamente mediante uno o varios sistemas y juicios de expertos en derechos humanos, que filtren imparcialmente la codificación irradiada de los principios rectores de éstos a manera de secuencia: Modelo conceptual-algoritmo-código, a fin de crear un Entorno Algorítmico de Aprendizaje (EAA) que rompa con la idea de los perfiles tecnológicos en el derecho de opinar y decidir acerca de la IA, recreando un necesario hábitat de sistemas socio técnicos, hacia donde efectivamente debe mirar el programador, las corporaciones digitales y los Estados.