Forma sugerida de citar:

Medina-Díaz, M. del R., & Verdejo-Carrión, A. (2020). Validez y confiabilidad en la evaluación del aprendizaje mediante las metodologías activas. Alteridad, 15(2), 270-284. https://doi.org/10.17163/alt.v15n2.2020.10

1. Introducción

En pasadas tres décadas, las exigencias del público, los gobiernos y las agencias acreditadoras en cuanto a la educación universitaria demandan del estudiantado aprendizajes variados y complejos para el desempeño en el mundo laboral y a lo largo de la vida (Erwin, 1991; Huba & Freed, 2000; Krzykowski & Kinser, 2014; McClarty & Gaertner, 2015; Pozo & Pérez-Echeverría, 2009; UNESCO, 1998). Estas expectativas suponen ciertos cambios en las estrategias de enseñanza y en las técnicas y los instrumentos que recopilan información para evaluar el aprendizaje estudiantil. Implica mirar de manera distinta el aprendizaje para atender a las características, los procesos y estilos de aprender del estudiantado y proveer actividades instruccionales, donde construyan conocimientos y destrezas, partiendo de los previos, y oportunidades de involucrarse activamente, demostrando lo que han aprendido y evaluar su desempeño (Brookhart, 2004; Erwin, 1991; Hortigüela-Alcalá et al., 2015; Huba & Freed, 2000; López-Pastor & Sicilia-Camacho, 2016). Con esta perspectiva, el énfasis radica en cómo aprender o elaborar estructuras mentales y procesos de pensar y actuar a fin de desarrollar y lograr los aprendizajes esperados. Estos son múltiples y se integran en las dimensiones cognoscitivas, afectivas, psicomotoras y sociales del desarrollo académico y personal del estudiantado en los distintos contextos educativos. Comúnmente, estos aprendizajes se enuncian como objetivos de enseñanza (“learning targets”, Stiggins, 2017, p.11); resultados o metas del aprendizaje (“learning outcomes”, “learning goals”, Huba & Freed, 2000, p. 94, p. 9, respectivamente) y competencias (Baartman et al., 2006; De la Orden, 2011; Epstein, 2007; Fernández March, 2006; García-Merino et al., 2016; Goñi Zabala, 2005; Olmos-Miguelañez & Rodríguez-Conde, 2010; Pozo & Pérez- Echeverría, 2009; Voorhees, 2001).

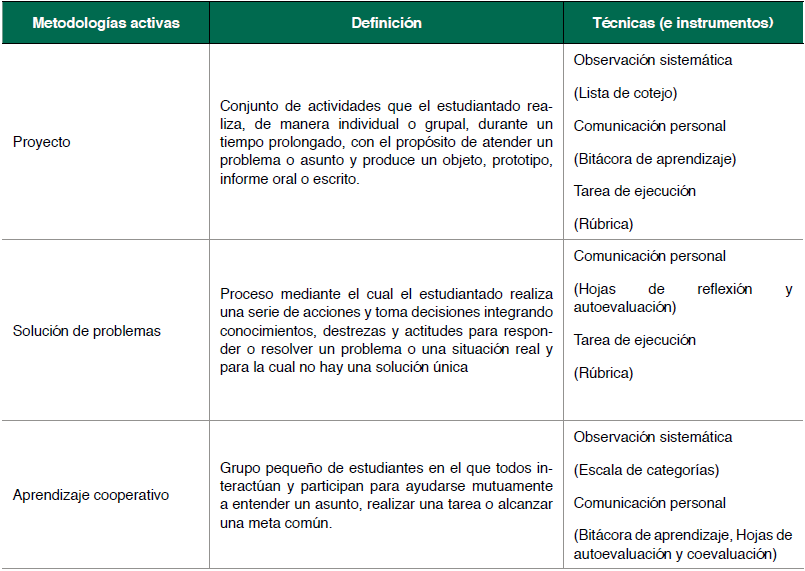

Las metodologías activas o auténticas, como estrategias de enseñanza, sirven de vehículo para facilitar su desarrollo y logro, mediante situaciones o problemas similares a los que se confrontan en el campo profesional y la sociedad. Su aplicación, requiere replantear, planificar y orientar la enseñanza de modos distintos, ubicando al o la estudiante como centro, y alineando las técnicas y los instrumentos para la evaluación. Una técnica de (o para la) evaluación se refiere al conjunto de procedimientos o acciones planificadas para recoger información acerca del aprendizaje; mientras que un instrumento es el objeto o medio específico con el cual ésta se aplica. Aquí la información abarca puntuaciones, selecciones, anotaciones, comentarios u otras maneras que muestren respuestas u observaciones. Medina Díaz y Verdejo Carrión (2019) las clasifican en cuatro grupos, con los instrumentos asociados: (a) pruebas (e.g., pruebas objetivas y subjetivas); (b) observación (e.g., listas de cotejo, escalas de categorías y rúbricas); (c) comunicación personal (e.g., entrevista, cuaderno) y (d) tareas de ejecución (e.g., proyecto, portafolio). Angelo y Cross (1993), Barkley y Major (2016), Suskie (2009) y Weimer (2013) presentan múltiples ejemplos de estas técnicas para la evaluación del aprendizaje atemperadas al contexto universitario. Se confía en que el profesorado las conoce y utiliza aquellas que armonizan con los objetivos de un curso, las estrategias de enseñanza que emplea y la diversidad de características del estudiantado, para producir información apropiada de sus aprendizajes (Banta et al., 1996; Black & William, 1998a, 1998b; Bennett, 2011; Davies & Taras, 2018; Lopéz-Pastor & Sicilia-Camacho, 2016; Newble & Cannon, 1991; Olmos-Miguelañez & Rodríguez-Conde, 2010; Rawlusyk, 2018; Webber, 2012). Conviene aclarar que una técnica o un instrumento no son exclusivos de un tipo de evaluación (e.g., diagnóstica, formativa o sumativa), sino que es el profesor o la profesora quién determina el propósito y uso de las puntuaciones o de los resultados. En esto, precisamente, descansa la validez de las interpretaciones de las puntuaciones o la información para el uso designado. Esto, con la expectativa de que mejore sustancialmente la calidad de la experiencia académica y los aprendizajes o las competencias del estudiantado universitario. La Tabla 1 presenta tres ejemplos de metodologías activas y posibles técnicas e instrumentos de recopilación de información para evaluar el logro de determinados aprendizajes.

La evaluación del aprendizaje conlleva emitir un juicio fundamentado, basado en información apropiada y pertinente acerca de los diversos aprendizajes desarrollados y logrados. Por lo tanto, uno de los grandes retos es recopilar y combinar información, tanto cuantitativa como cualitativa, recogida con múltiples instrumentos y en distintos momentos. Sin embargo, bajo el manto de la informalidad y la rapidez con que suele ocurrir la evaluación en las aulas, no se considera la validez de las interpretaciones de las puntuaciones o de la información recogida, así como la confiabilidad. Tal vez por esto, han tenido una mención exigua en publicaciones, en inglés, dedicadas a técnicas de assessment en la educación superior (Angelo & Cross, 1993; Barkey & Major, 2016; Huba & Freed, 2000; Suskie, 2009; Wolf et al., 2012), así como en las investigaciones acerca de las prácticas de evaluación del profesorado universitario en varios países (Alquraan, 2012; Andreu-Andrés & Labrador-Piquer, 2011; Bearman et al., 2017; Brown & Atkins, 1988; Erwin, 1991; Gilles, Detroz & Blais, 2010; Goubeaud, 2010; Goubeaud & Yan, 2004; Hernández, 2012; Hortigüela Alcalá et al., 2017; Pereira & Flores, 2016; Yükselii & Gündüz, 2017). También, cabe la posibilidad que, en aras de la confianza y la libertad académica, la validez y confiabilidad se dan por sentado, cuando el profesorado elabora o utiliza uno o más instrumentos para aplicarlos al estudiantado, sin contar con evidencia suficiente que lo sustente y el cuidado de ciertos elementos técnicos en su construcción y aplicación (Esteve Zarazaga, 2007; Gil Flores, 2005; Jacobs & Chase, 1992; O’Hagan, 2014; Poskanzer, 2002). La evaluación del aprendizaje integrada con metodologías activas en la enseñanza invita a considerar la calidad los instrumentos aplicados en el nivel universitario, en particular la validez y la confiabilidad de las puntuaciones o de la información que se obtiene. Este trabajo tiene como propósito principal aportar a la discusión de estos dos aspectos.

2. Metodología

Con este fin, se revisaron varias publicaciones que favorecen o debaten el cumplimiento con las consideraciones de la validez y la confiabilidad de las interpretaciones de la información recopilada con los instrumentos utilizados para evaluar el aprendizaje (American Educational Research Association et al., 2018; Brookhart, 2003, 2007; Cizek, 2009, 2015; Joint Committee on Standards for Educational Evaluation, 2018; Moss, 2003). Los Estándares para pruebas educativas y psicológicas, publicados por las organizaciones American Educational Research Association, American Psychological Association y National Council on Measurement in Education (2018) apuntan hacia las exigencias que deben cumplir los instrumentos que se construyen y administran a gran escala o con fines comerciales para asegurar la validez de las interpretaciones de las puntuaciones con el uso propuesto. Estos ofrecen un marco de referencia o guía para garantizar que se aborden cuestiones relevantes en la construcción de instrumentos educativos y psicológicos y brindan una base para revisarlos y criticarlos (American Educational Research Association et al., 2018, p.1). El Joint Committee on Standards for Educational Evaluation (2015), atiende el asunto, referente a lo que ocurrre en las aulas escolares, en el estándar “Q4 Reliability and Validity”: “Classroom assessment practices should provide consistent, dependable and appropriate information that supports interpretations and decisions about each student’s knowledge and skills” (Localización 643).

Desde nuestra perspectiva, no se pretende la misma amplitud y rigor estadístico que en los procedimientos de validación empleados en las pruebas de aprovechamiento estandarizadas y otros instrumentos aplicados en la práctica y la investigación educativa y psicológica. Sin embargo, los que se utilizan en las universidades, también, deben generar información cuantitativa y cualitativa apropiada acerca del aprendizaje estudiantil, conforme al propósito, el contenido, las estrategias de enseñanza y el tamaño de los grupos de estudiantes y otras circunstancias, así como a las inferencias y acciones derivadas. Una de estas inferencias podría ser que el o la estudiante haya logrado la competencia de solución de problemas, aplicando estadísticas descriptivas. Moss (2003), por su parte, plantea que la noción de validez no es suficiente para la práctica en las aulas y que se debe reconceptualizar. Aboga por enfoques interpretativos (e.g., basados en la teoría sociocultural y la hermenéutica) para manejar la información que se recopila continuamente. Brookhart (2003) propone el desarrollo de una teoría de medición basada en la sala de clases (“classroometric”, p.8). Ante estos planteamientos, destacamos los conceptos de validez y confiabilidad y las fuentes de evidencia que sirven de apoyo. Además, presentamos varias recomendaciones acerca de la evidencia pertinente para interpretar las puntuaciones y otra información recopilada con los instrumentos.

3. Validez y confiabilidad

3.1 Validez

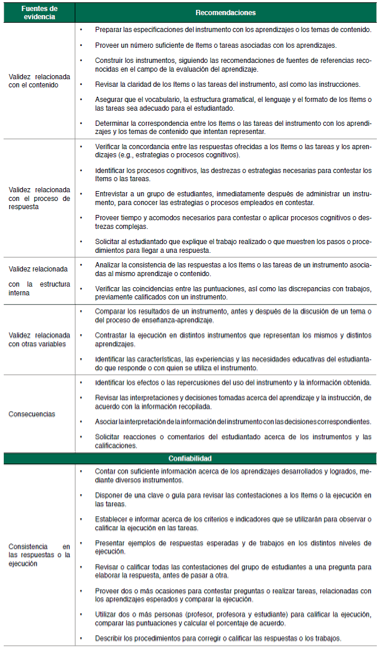

La validez se define al “grado en que la evidencia y la teoría respaldan las interpretaciones de los puntajes de una prueba o instrumento de medición para los usos propuestos” (American Educational Research Association et al., 2018, p.11). En otras palabras, comprende un juicio acerca de la interpretación de las puntuaciones o de la información obtenida con un instrumento, a la luz de la evidencia de distintas fuentes que le sirven de sostén. Estas se relacionan con el contenido, el proceso de respuesta, la estructura interna, con otras variables y las consecuencias (American Educational Research Association et al., 2018). Esta visión se fundamenta en un concepto unificador de la validez, contemplando que la evidencia integrada de estas fuentes contribuye a la validez relacionada con el constructo, de modo que sustente teórica y empíricamente que el instrumento lo mide o representa de manera apropiada y conduzca a inferencias y acciones adecuadas (Messick, 1989). Un instrumento que se utilice en las aulas universitarias, requiere evidencia relevante que apoye las interpretaciones y los usos de las puntuaciones o la información obtenida. La Tabla 2 resume algunos de los procedimientos vinculados con las cinco fuentes de evidencia, de acuerdo con Cizek (2009), Medina- Díaz y Verdejo-Carrión (2019), McMillan (2008) y Nitko y Brookhart (2011).

Tabla 2 Recomendaciones acerca para la validez y la confiabilidad de la interpretación de las puntuaciones o la información recogida con un instrumento para la evaluación

La evidencia de la validez relacionada con el contenido comienza a acumularse desde que se identifica el propósito y los aprendizajes que se pretenden representar en un instrumento. Su construcción requiere delimitar los aprendizajes, los temas de contenido, la cantidad y el tipo de ítems como parte de las especificaciones que le sirven de base. Por ejemplo, cuando se trata de una prueba de aprovechamiento objetiva, se acostumbran colocar en el formato de una tabla y se ubican los aprendizajes esperados o los temas de contenido en las filas o las columnas o simplemente, los objetivos con los ítems asociados (Medina-Díaz & Verdejo-Carrión, 2019). En este y otros instrumentos que se diseñen, como pruebas de ejecución, se espera una concordancia entre los ítems o las tareas, los objetivos, las estrategias de enseñanza y el énfasis y el tiempo dedicado a la discusión del contenido (i.e., validez instruccional). A partir de las especificaciones se elaboran los ítems o las tareas, según el número y tipo adecuado, atendiendo a los aprendizajes, el tiempo y otras condiciones del estudiantado y contexto universitario. Para elaborar las preguntas tipo ensayo o de discusión, las cuales se utilizan con mucha frecuencia en este contexto, también se considera la organización y relación entre los temas en la respuesta ideal (Brown, 2010; Medina-Díaz & Verdejo-Carrión, 2019).

Los ítems o las tareas, junto con las instrucciones, son las piezas principales de un instrumento. Por lo tanto, su selección y elaboración merecen esmero. Nitko y Brookhart (2011), Haladyna (1997), Mateo y Martínez (2008); Medina-Díaz y Verdejo-Carrión (2019) presentan numerosas recomendaciones para crearlos. Entre las generales se encuentran: (a) claridad en el vocabulario empleado, (b) sencillez en la estructura gramatical y (c) evitar incluir dos ideas y lenguaje sexista, ofensivo o discriminatorio. Asimismo, se redactan las respuestas correctas o esperadas a los ítems o tareas. Un asunto crucial es asegurarse que los ítems o las tareas requieran mostrar aprendizajes cognoscitivos, al menos de comprensión y aplicación de conceptos, acciones y procedimientos. Esto supone que el profesorado ha utilizado estrategias de enseñanza que han ayudado a desarrollarlos.

En la preparación de un instrumento también se toma en cuenta la secuencia, la edición y el despliegue físico. Esto se refleja en la apariencia y organización, así como en la ausencia de errores ortográficos en los ítems y las instrucciones. Lo anterior aplica tanto a un instrumento en formato impreso como electrónico. Estas acciones, sin duda, abonan a la evidencia relacionada con el contenido del instrumento, la cual tiene mayor envergadura en la evaluación del aprendizaje estudiantil.

Conviene recordar que la revisión de la representatividad y la relevancia de los ítems o las tareas de una prueba de aprovechamiento u otro instrumento estandarizado, dependen del juicio de personas conocedoras o familiarizadas con el contenido, los aprendizajes y el grupo estudiantil de interés (American Educational Research Association et al., 2018). En las aulas universitarias, esta labor la realiza solamente el profesor o la profesora, quien decide acerca de los aprendizajes que se van a representar, los temas del contenido y los ítems o las tareas del instrumento. Además, cabe la posibilidad de la sub- o sobre-representación de algún objetivo o tema del curso. Para minimizar esto, un o una colega podría ayudar a revisar la coherencia del instrumento con las especificaciones y la ambigüedad en las preguntas, antes de administrarlo.

La evidencia acerca del proceso de respuesta incluye establecer la afinidad entre los ítems o las tareas del instrumento con los aprendizajes cognoscitivos, afectivos y psicomotores o las destrezas de pensamiento que se requiera para contestarlos o completarlos. Para recopilar evidencia acerca de los distintos procesos cognitivos o destrezas de pensamiento u otras es necesario, al menos, identificar cómo los ítems o las tareas las modelan y capturan la información relevante. Por ejemplo, para realizar una tarea de ejecución en Matemáticas se espera que el o la estudiante emplee una estrategia general o heurística (e.g., realizar un diagrama o dibujo) para contestarla. La profesora o el profesor podrían entrevistar a varios estudiantes y solicitarles que expliquen su razonamiento para verificar si contestaron aplicando dicha estrategia en la tarea o solución al problema en cuestión. También puede observar la ejecución de un grupo de estudiantes realizando cierta tarea para indagar si el procedimiento que llevaron a cabo es el contemplado.

La evidencia de la estructura interna conlleva mostrar la cohesión de los ítems o las tareas del instrumento en representar lo que se propone (e.g., aprendizajes o temas de contenido), y la consistencia en las respuestas. Nitko y Brookhart (2011) sugieren prestar atención a los patrones de respuesta a los ítems o las tareas y a la concordancia con los de otros instrumentos administrados. Si se trata de pruebas, se aconseja analizar y comparar las respuestas de varias preguntas o tareas del mismo contenido, para determinar la consistencia de los resultados (McMillan, 2008). La evidencia de la relación con otras variables concierne a la asociación entre las respuestas a los ítems y las puntuaciones del instrumento con variables externas (llamados criterios). Esta evidencia es pertinente cuando las puntuaciones en un instrumento sirven como indicador del desempeño en otras variables (e.g., promedio académico, puntuaciones en una prueba de razonamiento lógico). En la evaluación del aprendizaje esto se podría aprovechar, primero, identificando las características, las experiencias y la diversidad de necesidades educativas del estudiantado que responde o con quien se utiliza el instrumento y luego, en buscar similitudes y diferencias en la ejecución del estudiantado en el instrumento en cuestión y en otros administrados (McMillan, 2008). También se podrían comparar las observaciones en las tareas del estudiantado, antes de iniciar la discusión del tema y al terminarla. Las discrepancias sugieren posibles cambios en los aprendizajes desarrollados. Asimismo, sería útil verificar la ejecución en varias tareas dirigidas a demostrar aprendizajes similares o asociados.

La evidencia relacionada con las consecuencias considera los posibles efectos o las repercusiones que tienen los instrumentos y el uso de la información recopilada. Exige, por ejemplo, documentar cómo se interpretaron las puntuaciones (e.g., interpretación normativa o criterial), para qué se usaron y cuáles fueron las consecuencias (e.g., aumentar la motivación o el tiempo de estudiar, reducir la cantidad de fracasos). Además, se podría indagar el impacto en el aprendizaje estudiantil de una tarea de ejecución dirigida a realizar un trabajo de investigación o práctico en una comunidad (Ricoy & Fernández-Rodríguez, 2013). Una entrevista con el o la estudiante o una reflexión escrita en el trabajo serviría de evidencia. McMillan (1997) y Taylor y Nolen (2005) otorgan énfasis a las consecuencias para el profesorado y el estudiantado, particularmente el efecto que podría tener la retroalimentación, las técnicas y los instrumentos administrados en la motivación y los hábitos de estudio.

Bonnen (2013), Gipps (1994), Medina Gual (2013), McMillan (1997) y Muñiz y Fonseca-Pedrero (2008) incluyen, además, una serie de propuestas para evidenciar la validez de las interpretaciones de la información recopilada, así como la confiabilidad. Suskie (2006, p. 37) plantea cuatro características de los instrumentos útiles (produzcan información certera y precisa, tengan un propósito claro, involucren al profesorado y el estudiantado, y se enfoquen en metas claras e importantes del aprendizaje estudiantil). Medina Gual (2013) propone un esquema con evidencias curriculares, interpretativas e instrumentales y sus respectivas estrategias. Gibbs (1994, p. 174) presenta seis criterios de calidad de los instrumentos: (a) fidelidad curricular, (b) comparabilidad, (c) dependencia, (d) credibilidad pública, (e) descripción del contexto y (f) equidad. De éstos, destacamos la equidad en el trato justo al estudiantado, proveyendo varias oportunidades y los acomodos necesarios para alcanzar los aprendizajes esperados. Por su parte, McMillan (1997, p.49) plantea los siguientes: (a) objetivos de aprendizaje claros y apropiados, (b) métodos de evaluación apropiados, (c) validez, (d) confiabilidad, (e) justicia, (f) consecuencias positivas, y (g) practicalidad y eficiencia. Estos últimos criterios incluyen varios aspectos que merecen consideración del profesorado, tales como el tiempo y los recursos que consume preparar el instrumento, administrarlo y calificar la ejecución del estudiantado, así como la complejidad de la interpretación de los resultados. Por ejemplo, la construcción de una prueba objetiva toma mucho tiempo, pero conlleva poco tiempo contestarla y corregirla. Una tarea de ejecución requiere mayor cantidad de tiempo en elaborarla, contestarla y valorar el desempeño. Por esta razón, recomendamos que se revisen y se vuelvan a usar algunos ítems o tareas, cada cierto tiempo si es posible.

3.2 Confiabilidad

La confiabilidad o fiabilidad se refiere a la precisión o consistencia de las puntuaciones o de la información conseguida con un instrumento administrado en varias ocasiones. También está atada a la precisión o exactitud de las puntuaciones u otra información de un grupo de estudiantes, con los menores errores posibles. Estos errores podrían estar vinculados con los cambios en las condiciones de administración del instrumento, la subjetividad en la corrección o calificación del profesorado, la ambigüedad en los ítems, así como a la falta de motivación y la adivinanza del estudiantado.

La cantidad de ítems, tareas y momentos en que se utilicen los instrumentos es un factor relacionado con la confiabilidad. Por lo general, aumentar la cantidad de ítems en una prueba objetiva, incrementa el coeficiente de confiabilidad. Hay tres tipos principales de coeficientes de confiabilidad que se obtienen mediante procedimientos estadísticos: (a) estabilidad (o test-retest), que se refiere a la consistencia de las puntuaciones a lo largo del tiempo o en diferentes ocasiones; (b) equivalencia, el cual concierne a determinar si dos o más formas paralelas de un instrumento producen puntuaciones o resultados similares; y (c) consistencia interna, que se enfoca en la cohesión de las respuestas a los ítems de un instrumento, que intenta medir o representar el mismo objetivo o contenido. Teóricamente, si un instrumento produce puntuaciones confiables estas deben ser similares para el grupo de estudiantes que lo contesta en dos o más ocasiones. La correlación entre las puntuaciones es el coeficiente de estabilidad.

En la mayoría de las aulas es imposible llevar a cabo una doble administración, así que se recurre a la confiabilidad basada en la consistencia interna, la cual requiere solo una. Una prueba objetiva cuenta con una clave para corregir las respuestas a los ítems, por lo cual la subjetividad en la corrección no es una limitación. El profesor o la profesora que la administra a grupos grandes de estudiantes y cuenta con el equipo y el programado de computadoras para corregirlas, podría analizar las respuestas a los ítems y calcular un coeficiente de confiabilidad (por lo general, de consistencia interna). Esto si las puntuaciones se van a interpretar con referencia a un grupo normativo. También, podría estimar el error estándar de medición, si lo desea. Este indica la precisión en las puntuaciones individuales del instrumento y depende de la magnitud del coeficiente de confiabilidad y la variabilidad de las puntuaciones; esto es, que a mayor confiabilidad menor es el error de medición. A menudo, estas estadísticas no suelen calcularse en las pruebas que administran en los cursos o departamentos universitarios. Sin embargo, tomarlas en consideración para revisar la calidad técnica es un esfuerzo meritorio, máximo cuando se proclama que “es una prueba confiable”.

Con respecto a las tareas de ejecución (e.g., proyecto, portafolio) imprescindibles en las metodologías activas, la subjetividad en la calificación se reduce, pero no se extingue, con el uso de una rúbrica, lista de cotejo o escala de categorías que contenga los criterios e indicadores apropiados (Medina-Díaz & Verdejo-Carrión, 2019; Reddy & Andrade, 2010; Selke, 2013; Van der Schaaf, Baartman & Prins, 2012). Además, el estudiantado debe conocer éstos de antemano o puede participar en su confección. Si es posible, se aconseja presentar ejemplos de respuestas esperadas, acciones o trabajos en los distintos niveles de ejecución, que la rúbrica incluya. En ausencia de estos, se describen los procedimientos para corregir o calificar las respuestas o los trabajos. Si se administran preguntas para elaborar la respuesta, se califican las respuestas de todo el grupo de estudiantes a una pregunta, antes de revisar las contestaciones de otra. Esto no solo ayuda a mantener consistencia en la calificación, sino a proveer retroalimentación al estudiantado cuando se discuten las respuestas a las preguntas.

De esta manera, la confiabilidad se manifiesta mediante la consistencia en la asignación de puntuaciones con una escala de valoración o una rúbrica para calificar la ejecución de cada estudiante en la tarea de ejecución en cuestión. Esto conlleva dos procedimientos para hallar la consistencia: intra-jueces y extra-jueces. La consistencia intra-jueces depende de cómo el profesor o la profesora aplique determinado instrumento (e.g., una rúbrica), de manera estable, para calificar las respuestas o los trabajos del estudiantado. Para esto, puede volver a valorar una muestra de trabajos, previamente revisados y hallar la coincidencia en las puntuaciones otorgadas, así como identificar las discrepancias (Cizek, 2009). El acuerdo entre-jueces requiere que dos o más personas revisen y califiquen la ejecución. En las aulas, esto es inusual, a menos que se cuente con la colaboración de otro profesor o profesora o del estudiantado. Esta es una buena oportunidad para propiciar la participación del estudiantado como observadores o jueces, a modo de coevaluación. El profesor o la profesora y uno o más estudiantes, de manera independiente, califican la ejecución de un o una estudiante, usando el mismo instrumento. Luego, se comparan las puntuaciones y se calcula un porcentaje de acuerdo u otra estadística (Stemler, 2004). Los desacuerdos en las puntuaciones que sugieren poca o ninguna confiabilidad en las puntuaciones, pueden ser provocados por aplicar el instrumento de manera distinta o por posibles sesgos en la persona que califica (e.g., leniencia o severidad). Esto es otra ocasión para involucrar al estudiantado en el diálogo y la experiencia de calificar y evaluar, así como para entender la naturaleza del proceso y las apreciaciones comunes y discordantes en la ejecución. Además, el profesorado también se beneficia al confirmar lo acertado de las puntuaciones adjudicadas.

Por otra parte, Brookhart (2003) y Smith (2003) proponen visualizar la confiablidad como suficiencia o abundancia de la información. Brookhart (2003, p.11) alude a la estabilidad de la información para detectar la diferencia entre lo esperado y el estado actual de la ejecución del estudiantado o la cantidad de información. Smith (2003, p.31) se refiere a conseguir información suficiente, para tener una visión completa del estudiante, y que conduzca a una buena decisión. Asimismo, hay que considerar si el estudiantado tuvo varias oportunidades (ítems o tareas) y momentos para mostrar sus aprendizajes y lo que es capaz de hacer. Esto permite observar la variación y la consistencia en la ejecución y así, formular interpretaciones más acertadas de los aprendizajes logrados. Un profesor o una profesora podrían utilizar esta información y otra complementaria (e.g., entrevista) para derivar inferencias acerca de los aprendizajes logrados por el estudiantado. Además, ayuda a reducir la ansiedad o temor que podría provocar si solo cuenta con una ocasión o instrumento para demostrar lo aprendido. Como se aprecia, en estos casos no se calcula, ni es necesario, un coeficiente de confiabilidad. La confiabilidad depende del uso de varias técnicas que arrojen información consistente de los aprendizajes esperados. Cabe recalcar que tener puntuaciones o información confiable no es suficiente para declarar la validez.

Por último, la conveniencia de utilizar varios instrumentos para recoger información permite superar las limitaciones de cada uno y tratar de representar la complejidad y las múltiples dimensiones del aprendizaje estudiantil. La combinación de la información cuantitativa y cualitativa acumulada a lo largo del proceso de enseñanza-aprendizaje ofrece una mirada más integral y precisa de los aprendizajes desarrollados y así, permite tomar decisiones y formular juicios adecuados y justos. Si se consideran puntuaciones, tales como las de una prueba o de la rúbrica aplicada a una tarea de ejecución, las medidas de tendencia central y variabilidad son útiles para describir la ejecución de un grupo. Estas también se comparten con el estudiantado. Cuando hay información de índole cualitativa (e.g., ensayo, reflexión) o gráfica (e.g. tirilla cómica, infograma), se consideran ciertos criterios (e.g., vocabulario, argumentación, uso de ejemplos y símbolos) para describir el desempeño o desarrollo de cada estudiante. Aquí se pueden utilizar estrategias de análisis para identificar elementos o patrones comunes o divergentes en las piezas escritas o gráficas. La información recopilada con varios instrumentos se agrega y compara (o “triangula”) para identificar temas o patrones de ejecución referentes a los aprendizajes, que convergen en decisiones y juicios acerca del estudiantado y el proceso instruccional: ¿Qué aprendizajes lograron? ¿Qué dificultades presentan? ¿Qué se infiere acerca de los aprendizajes? ¿Cómo se van a usar los resultados? ¿Qué cambios se necesitan en las estrategias de enseñanza o en los instrumentos?

4. Discusión y conclusiones

La evaluación del aprendizaje constituye un proceso sistemático de emitir un juicio fundamentado en la información recopilada acerca los aprendizajes desarrollados y logrados, a lo largo del proceso de enseñanza-aprendizaje. La confianza depositada en la información recopilada depende la calidad de los instrumentos que el profesorado construye, administra y utiliza. La validez radica en lo apropiado y creíble de las interpretaciones de las puntuaciones o la información recopilada un instrumento acerca de los aprendizajes de un o una estudiante. La evidencia recopilada mediante las distintas fuentes afianza la certeza de las interpretaciones y las inferencias, tanto del proceso de aprendizaje como del aprovechamiento logrado por el estudiantado. Además, ayuda a darle sentido a las decisiones que se toman en el proceso de enseñanza-aprendizaje (e.g., ampliar la discusión de un tema, ofrecer una experiencia práctica, utilizar un método activo en la enseñanza o recomendar tutorías) y a los juicios emitidos (e.g., “María ha logrado las competencias”). Estas decisiones y juicios, sin duda, también merecen ponderación.

La validez y la confiabilidad, como apuntamos, no han tenido suficiente atención en la discusión de las técnicas y los instrumentos de recopilar información, aplicados por el profesorado para evaluar el aprendizaje estudiantil. Posiblemente, aparezcan en una “lista de las especies en peligro de extinción” como comenta Popham (2005, p.71). Esperamos que este escrito contribuya a la reflexión y acción para preservarlos. Exhortamos a tener mayor prudencia en las interpretaciones de la información adquirida con los instrumentos que se elaboren y utilicen junto con las metodologías activas de enseñanza, si no hay evidencia de la validez que las respalde. Recomendamos, al menos, que se tome en cuenta la evidencia relacionada con el contenido y la consistencia de las puntuaciones o de la información obtenida, al emitir juicios y tomar de decisiones que afectan al estudiantado. Reconocemos, sin embargo, lo trabajoso y ambicioso de esta solicitud, ante la realidad de la labor docente y el respeto a la libertad académica que cobija al profesorado en las distintas instituciones universitarias. Frente a la posible fragilidad de las interpretaciones y decisiones derivadas de la información obtenida o acumulada, mayor evidencia apremia para respaldarlas.

Por supuesto, no basta con que el profesorado construya y administre mejores instrumentos, si no utiliza la información de manera apropiada, consistente y justa en la evaluación del aprendizaje estudiantil. Como advierten Palomba y Banta (1999) y Banta y Pike (2012), se necesita usar los resultados para cerrar el ciclo de la evaluación (planificar-recoger información-interpretarla-usar los resultados). Tampoco es suficiente la información referente a los aprendizajes cognoscitivos, si no se contemplan los afectivos, psicomotores, sociales y otros que son relevantes en las distintas disciplinas universitarias (e.g., seguridad en el manejo de materiales o sustancias, autonomía y trabajo en equipo). Además, la evaluación del aprendizaje, de manera ética y constructiva, apunta al derecho del estudiantado a recibir notificación acerca del proceso evaluativo y a participar del mismo, de los criterios, las técnicas y los instrumentos que se emplean; así como de la interpretación de la información recopilada, tanto para mejorar el aprendizaje como la enseñanza. Hay que recordar que las interpretaciones, las inferencias y decisiones tomadas tienen consecuencias (unas más graves que otras), para el estudiantado y la sociedad. Finalmente, la expectativa de mejorar el aprendizaje estudiantil no depende exclusivamente de la evaluación, si no ocurren cambios en la visión del aprendizaje, las estrategias de enseñanza, el currículo de las disciplinas, el desarrollo profesional y el liderato del profesorado y la colaboración de la administración de las universidades para apoyarla, integrarla y valorarla.