1. Introducción

Uno de los problemas con que deben tratar los docentes hoy en día, consiste en encontrar actividades adecuadas para complementar el proceso de enseñanza-aprendizaje. Las Tecnologías de la Información (TIs) han probado ser útiles para apoyar este proceso, incrementando el acceso y mejorando la relevancia de la calidad de la educación (Tinio, 2003). Además, los actuales estudiantes son nativos tecnológicos (Prenksy, 2001): más activos, aprenden dentro y fuera del salón de clase, y lo hacen de manera diferente que generaciones previas (Bennett, et al., 2008). La gran mayoría de estos estudiantes gustan mucho de los juegos y de nuevas formas de interacción con computadores. Ellos, en calidad de usuarios, son más exigentes, y por ende, satisfacer sus demandas apropiadamente se convierte en una tarea desafiante. Por lo tanto, si se busca mejorar el proceso de enseñanza-aprendizaje con el apoyo de TIs, las herramientas seleccionadas deberían permitir que los estudiantes se sientan atraídos y/o motivados a usarlas, lo cual podría lograrse mediante enfoques lúdicos.

Los diferentes actores involucrados en el proceso de enseñanza-aprendizaje disponen hoy en día de un sinnúmero de herramientas que pueden utilizar tanto dentro como fuera de la sala de clase. El uso de un computador o de un dispositivo móvil por parte de cada estudiante puede considerarse como la solución clásica. Cada estudiante interactúa con el software respectivo, como por ejemplo los juegos serios que han demostrado ser muy atractivos para los estudiantes al combinar aprendizaje con diversión (Susi, et al., 2007; Connolly, et al., 2012). No obstante, esta solución puede presentar otros inconvenientes adicionales a los costos necesarios (Groff & Mouza, 2008). Independientemente del software utilizado, y de si este se ejecuta en un computador o en un dispositivo móvil, otras aplicaciones que funcionen al mismo tiempo de realizar la actividad propuesta podrían causar distracciones como en el caso de correos electrónicos, redes sociales, etc. (Fang, 2009; Fried, 2008). Estos inconvenientes podrían evitarse si el estudiante interactuara únicamente con la aplicación deseada pero a cierta distancia, por ejemplo, mediante el uso de gestos.

La interacción basada en gestos ha sido usada por muchos años, pero recientes avances ofrecen nuevas oportunidades para el ámbito educativo. A partir del uso de guantes (Baudel & Beaudouin-Lafon, 1993), pasando por sostener un dispositivo de mando en la mano (Holzinger, et al., 2010), hasta llegar a la interacción sin contacto basada en movimientos del cuerpo y de las manos en especial (Erazo & Pico, 2014), las aplicaciones basadas en gestos pueden contribuir a hacer el proceso de aprendizaje más entretenido. Diversos trabajos dan muestras de estas oportunidades (Erazo & Pico, 2014; Kandroudi & Bratitsis, 2012; Hsu, 2011). En particular, con este estilo de interacción es posible, por ejemplo, controlar presentaciones, aprender alguna asignatura o tema en particular, simular laboratorios, etc., y en diferentes niveles educativos (Lui, et al., 2013; Johnson, et al., 2013; Meng, et al., 2013; Jagodziński & Wolski, 2015). Además, las aplicaciones de este tipo pueden ser utilizadas tanto en el salón de clase como en el hogar gracias a sus relativamente bajos costos.

Más allá de las utilidades mencionadas, la interacción basada en gestos aún podría ofrecer más oportunidades que todavía están pendientes de ser investigadas. Específicamente, existe un tipo de gestos que no ha recibido suficiente atención y que podría aportar beneficios. El tipo de gestos en mención, denominado gestos de dibujos (Erazo & Pico, 2014), es un tipo de gesto icónico que consiste en trazar en el aire el contorno de figuras (letras, números, etc.) utilizando la mano. A base de lo expuesto, este trabajo propone el uso de gestos de dibujos con fines educativos. Para el efecto, se ha llevado a cabo un estudio empírico con la finalidad de verificar si este tipo de gestos es bien acogido por los estudiantes y si se motivan a usarlos como medio de interacción con aplicaciones educativas. De ser así, el uso de aplicaciones de este tipo, en el aula o en el hogar, podría contribuir a incrementar la motivación y/o intervención de los estudiantes en la asignatura o tema correspondiente, conduciendo a mejorar el proceso de enseñanza-aprendizaje. En consecuencia, este artículo contribuye con resultados cualitativos y cuantitativos acerca de la factibilidad de esta propuesta, así como también discutiendo sus posibles implicaciones y utilidades.

2. Trabajos relacionados

A partir de la idea que las personas utilizan gestos como un medio de comunicación entre ellas, el uso de estos para “comunicarse” con computadores ha sido ampliamente estudiado a través de los años. Uno de los primeros trabajos de este tipo consistió en un sistema para controlar presentaciones que requería que el usuario usara un guante de datos (Baudel & Beaudouin-Lafon, 1993). Otras propuestas se han hecho posteriormente también usando guantes. Alternativas al uso de guantes también aparecieron más adelante, tales como aquellas basadas en marcadores de rastreo (Buchmann, et al., 2004) o en sostener un dispositivo como el Wii Remote de Nintendo (Holzinger, et al., 2010) o un teléfono celular (Kühnel, et al., 2011). No obstante, los recientes avances en visión por computador (ver por ejemplo (Wachs, et al., 2011)) junto con la salida al mercado de nuevos dispositivos, como MS-Kinect y Leap Motion, han permitido eliminar el uso de marcadores y el contacto físico con dispositivos. Todo esto, junto también con las mejoras en hardware en general, ha facilitado el desarrollo de aplicaciones de este tipo. Así, las interfaces basadas en gestos en la actualidad han trascendido el campo del entretenimiento (Wachs, et al., 2011), aunque su uso aún no se ha masificado. Una cantidad considerable de investigaciones confirman sus bondades en diferentes escenarios tales como museos (Mehler, et al., 2014), negocios (Giovanni, et al., 2012), hogares (Panger, 2012), entre otros. En todos estos casos el usuario controla las aplicaciones mediante movimientos de su(s) mano(s) (o de otra parte del cuerpo) sin tener contacto con dispositivo alguno.

De manera similar, diversos estudios han proporcionado evidencias de la utilidad de la interacción basada en gestos sin contacto en ambientes educativos (Erazo & Pico, 2014; Kandroudi & Bratitsis, 2012; Hsu, 2011). En términos generales, este estilo puede facilitar y mejorar el proceso de enseñanza-aprendizaje porque provee interacciones significativas (Hsu, 2011). Los docentes pueden emplear aplicaciones de este tipo en las salas de clases, o los alumnos pueden usarlas como complemento educativo en sus hogares. En el primer caso, ellas pueden contribuir a incrementar la participación de los alumnos, facilitar la manipulación de material educativo, fomentar la discusión y crear clases más entretenidas (Hsu, 2011). Entre las utilidades que han sido ilustradas en investigaciones previas se pueden mencionar:

Apoyar en la enseñanza de asignaturas como matemáticas o anatomía. Por ejemplo, en el primer caso se pueden controlar funciones algebraicas o entender conceptos trigonométricos con movimientos corporales (Johnson, et al., 2013; Nandi, et al., 2016), mientras que en el segundo es posible manipular modelos tridimensionales que representan a órganos del cuerpo (Meng, et al., 2013)

Controlar presentaciones empleando gestos manuales, tales como tocar un hombro o “presionar” botones con la mano (Lui, et al., 2013)

Aprender otros idiomas, en cuyo caso el uso de la interacción gestual puede contribuir a motivar el aprendizaje, por ejemplo, del inglés (Lee, et al., 2012). Así mismo, el uso de gestos puede apoyar la adquisición de lenguaje porque la lectura de libros en sistemas basados en gestos puede ser una actividad interesante y atractiva para los niños (Homer, et al., 2014)

Crear laboratorios virtuales tales como un laboratorio de química en el cual los alumnos pueden llevar a cabo las mismas actividades que realizarían en un laboratorio real (Jagodziński & Wolski, 2015). Así por ejemplo, se simulan las acciones de sujetar el equipo necesario y combinar sustancias

Convertir una superficie cualquiera, como la pared de un salón de clases, en pizarras interactivas con costos inferiores a los de una pizarra interactiva convencional (Şimşek & Durdu, 2014)

Asimismo, los estudiantes pueden reforzar lo aprendido en clase manteniendo las ventajas antes señaladas. Aunque en general se pueden utilizar en el hogar las mismas aplicaciones empleadas en las instituciones educativas, algunas de ellas pueden ser más adecuadas de utilizar en el hogar debido a, por ejemplo, limitaciones de espacio o tiempo, o esfuerzo físico requerido. Algunos ejemplos de aplicaciones que podrían estar dentro de este grupo son descritos por Kandroudi y Bratitsis (2012).

Las aplicaciones antes mencionadas ponen de manifiesto claramente la utilidad del uso de gestos como medio de interacción con software con fines educativos, pero pocos trabajos han abordado el uso de gestos de dibujos manuales sin contacto. Estos gestos son representaciones visuales de símbolos (Piumsomboon, et al., 2013); es decir, su ejecución consiste en trazar o describir icónicamente una ruta en el aire. Los trazos realizados típicamente corresponden a letras, números o figuras geométricas, y usualmente son ejecutados manteniendo una pose estática de la mano (Piumsomboon, et al., 2013)-por ejemplo, la mano cerrada o el dedo índice levantado. Un ejemplo del uso de estos gestos consiste en trazar una “X” para cerrar la aplicación correspondiente. A pesar de las evidencias que existen en cuanto a las preferencias de los usuarios hacia este tipo de gestos (Piumsomboon, et al., 2013), su uso con fines educativos ha sido escasamente explorado. Básicamente, los gestos de dibujos han sido empleados con la finalidad de incrementar el nivel de aprendizaje de un segundo idioma y practicar las tablas de multiplicar (Akazawa, et al., 2014b; Akazawa, et al., 2014a). En estos dos casos la evaluación realizada proporcionó evidencia inicial de su utilidad, pero ambos presentan también limitaciones. En el primero (Akazawa, et al., 2014b) los participantes manifestaron haber disfrutado la experiencia pero el número de ellos fue muy limitado (dos personas). El otro estudio (Akazawa, et al., 2014a), a pesar de contar con la participación de más niños, no consideró ciertos aspectos importantes para concluir si el uso de gestos de dibujos puede ser adecuado o no con fines educativos. Dichos aspectos corresponden a métricas de rendimiento al realizar las tareas y opiniones de los participantes. Por lo tanto, el estudio descrito en este artículo busca también superar las limitaciones previas según se explica en la siguiente sección.

3. Metodología

En esta sección se describe el estudio realizado con la finalidad de analizar la viabilidad de utilizar gestos de dibujos como forma de interacción con aplicaciones educativas. En términos generales, el estudio, llevado a cabo en un ambiente controlado, consistió en ejecutar varios gestos de este tipo para interactuar con la aplicación desarrollada. Esto permitió recolectar datos cuantitativos y datos subjetivos para verificar la propuesta. Los detalles del estudio son descritos a continuación.

3.1 Materiales

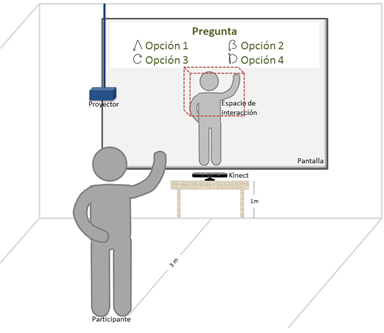

En primer lugar se procedió a desarrollar el software experimental a utilizar en el estudio (Figura 1). La aplicación consistió en hacer preguntas de opción múltiple a los usuarios quienes debían responderlas realizando un gesto de dibujo en el aire con su mano. La utilidad de este enfoque de preguntas/respuestas en educación ha sido demostrada previamente (Beekes, 2006) y además puede ser aplicado en cualquier área. La aplicación mostraba automáticamente una pregunta a la vez y registraba la respuesta correspondiente. Las respuestas eran ingresadas por los participantes en forma de gestos grafiti (Castellucci & MacKenzie, 2008) que correspondían a las cuatro primeras letras del alfabeto. Las representaciones gráficas de los gestos/letras, indicando el punto de inicio, fueron colocadas junto a cada una de las cuatro posibles respuestas (ver Figura 1). El reconocimiento de gestos se llevó a cabo usando el algoritmo “Dynamic Time Warping” (Senin, 2008), que es uno de los algoritmos exitosos para este tipo de tareas (Wachs, et al., 2011). Las respectivas plantillas requeridas para hacer las comparaciones fueron generadas previamente con la colaboración de otra persona (que no participó en el estudio). El uso de estas plantillas, la precisión del algoritmo (aunque esta ha sido ampliamente demostrada) y los demás aspectos del estudio fueron verificados en pruebas preliminares. La aplicación también siguió el paradigma de realidad aumentada, que consistió en aumentar la percepción de lo que el sujeto veía en su entorno real con los controles empleados como parte de la interfaz de usuario (Piumsomboon, et al., 2013; Giovanni, et al., 2012). Es necesario tener en cuenta también que este enfoque ya ha sido empleado adecuadamente en trabajos previos (Akazawa, et al., 2014b; Akazawa, et al., 2014a), pero a diferencia de ellos, en este estudio se optó por no mostrar el dibujo del gesto con la finalidad de evitar efectos de “feedback” (retroalimentación) visual (Kim, et al., 2012). Además, el espacio de interacción fue definido según lo sugerido por Erazo y Pico (2014) facilitando así la interacción (ver Figura 1). Adicionalmente, la aplicación realizaba los cálculos y registros necesarios tal como se explica más adelante.

El hardware utilizado (Figura 1) consistió en el computador en el cual se ejecutó la aplicación antes descrita, y en un sensor Kinect y un proyector conectados a dicho computador. El uso de Kinect y de su SDK para Windows, facilitó la tarea de hacer seguimiento de la mano mediante las coordenadas obtenidas en tres dimensiones y la creación del ambiente aumentado usando las imágenes RGB. El Kinect fue colocado aproximadamente a un metro de altura y debajo de la pantalla proyectada.

3.2 Participantes

Veinte estudiantes, diez hombres y diez mujeres, aceptaron participar en el estudio. Las edades de ellos estuvieron comprendidas entre 18 y 19 años, y cinco fueron zurdos. Todas estas personas se encontraban cursando el primer año de Ingeniería en Sistemas al momento de realizar el estudio, por lo cual eran usuarios habituales de computadores. Ninguno de ellos recibió compensación alguna por su participación.

3.3 Datos recolectados

Durante el estudio se recolectaron datos tanto cuantitativos como cualitativos. Estos datos fueron recolectados de varias maneras, según se detalla a continuación:

Tiempo: la aplicación fue desarrollada de manera que calcule automáticamente el tiempo requerido para ingresar cada respuesta; o sea, ejecutar el gesto. El tiempo fue calculado como el intervalo desde que el participante levantaba la mano para responder hasta cuando la regresaba a su lugar original (junto a las caderas) después de haber contestado. Estos valores fueron guardados en forma de “logs” para todos los participantes.

Errores: se contaron como errores las veces en las cuales la aplicación no fue capaz de reconocer el gesto ingresado por el participante, en cuyo caso debió repetir el gesto. Este registro también se realizó en forma automática.

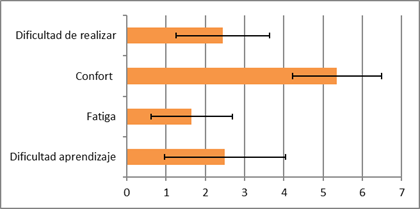

Cuestionario: los participantes completaron un cuestionario de seis preguntas al terminar la tarea encargada. Este cuestionario tuvo dos clases de preguntas. Las primeras cuatro, que debían responderse usando una escala de Likert de 1 (extremadamente baja o nada) a 7 (extremadamente alta) se refirieron a la dificultad de aprendizaje, fatiga, confort y dificultad de realizar la tarea. Las otras dos preguntas solicitaban a los participantes opinar abiertamente sobre posibles problemas experimentados y sobre la interacción.

3.4 Procedimiento

El estudio inició con una descripción general de él y la confirmación de participación de los estudiantes luego de ser debidamente informados. Después de ello, los participantes recibieron instrucciones sobre cómo realizar la tarea. Las instrucciones indicaban también la forma de iniciar y terminar la respuesta a cada pregunta; es decir, usar la mano dominante y no levantarla hasta tener preparada mentalmente la respuesta a ingresar. Esto permitió registrar exclusivamente el tiempo requerido para realizar el gesto, ya que el estudio no se concentró en las operaciones mentales necesarias para obtener la respuesta. Además, usando tales posiciones iniciales y finales se evitó incrementar la fatiga que puede originarse cuando los usuarios mantienen sus manos en el aire durante períodos de tiempo prolongados o innecesarios (Ren & O'Neill, 2013).

Después de recibir las instrucciones cada participante se colocó de pies, aproximadamente a tres metros de la pantalla (tomando en cuenta las limitaciones del sensor (González-Jorge, et al., 2013)). Desde ahí respondió a cada una de las preguntas que fueron mostradas una por una en forma aleatoria. Las preguntas fueron elaboradas previamente a base del contenido de una de las asignaturas que los participantes se encontraban estudiando durante el semestre en curso. Cada participante respondió un total de doce preguntas (cuatro opciones por tres veces cada una) dibujando el gesto correspondiente (gestos grafiti “A” - “D”, Figura 1). Sin embargo, debido a que ninguno de ellos tenía experiencia previa con gestos de dibujos hechos en el aire (aunque algunos habían utilizado algún juego basado en Kinect previamente) se consideró adecuado no incluir en el análisis la primera ejecución de cada gesto.

4. Resultados

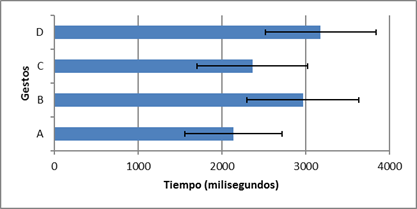

Los resultados reportados en esta sección fueron calculados con un total de 40 gestos para cada letra; es decir, se utilizaron un total de 160 gestos. El análisis de varianza (ANOVA) reveló la diferencia significativa entre gestos (F 3,54 = 37.117, p < 0.0001). El orden de ingreso (la segunda y tercera ejecución de cada gesto) no tuvo efecto en el tiempo (F 1,18 = 0.002, ns), pero sí se observó un efecto de interacción entre gestos y orden de ingreso (F 3,54 = 3.691, p < 0.05). Sin embargo, el test de comparación de pares (PostHoc) mostró que no hubo diferencias entre las segundas y terceras ejecuciones de cada gesto, por lo cual se decidió usar el promedio de ambas. El análisis estadístico también mostró que no hubo diferencia significativa por sexo (F 1,18 = 0.709, ns), ni efecto de interacción entre sexo y gestos (F 3,54 = 0.157, ns). Así, la Figura 2 muestra los tiempos promedio requeridos para realizar cada uno de los gestos.

La presencia de errores fue escasamente observada en el estudio. El número total de errores fue de siete entre todos los participantes, pero fueron cometidos únicamente por cinco de ellos. Dos personas cometieron dos errores para el gesto “B” (uno en la misma respuesta y la otra en diferentes respuestas). Los otros tres errores correspondieron al gesto “D”.

La Figura 3 muestra los puntajes en promedio asignados por los participantes a cada una de las preguntas del cuestionario. Tanto la dificultad de aprender como de interactuar con la aplicación usando los gestos propuestos recibieron puntajes de 2.5. Así mismo, la fatiga reportada fue baja (1.7), mientras que el confort alcanzó un valor de 5.4.

Aunque en general los participantes respondieron positivamente las preguntas abiertas, hay algunos detalles que se considera necesario mencionar. Tres participantes señalaron haber experimentado cierto tipo de problema. Dos de ellos dijeron que su “seudo” problema fue “olvidar las alternativas a ingresar (pero que se solucionaría con práctica)”, mientras que los otros dos manifestaron haber sentido una ligera incomodidad al responder pero sin dar detalles adicionales. Aunque cuatro participantes no proporcionaron ningún comentario general, once dijeron explícitamente que la tarea les pareció interesante, entretenida y/o fácil de realizar. Las personas restantes hicieron ciertas sugerencias como “mostrar el dibujo del gesto quizá podría ser de utilidad” y “mejorar el punto que indicaba el inicio del gesto”, pero no manifestaron estar en desacuerdo con la propuesta.

5. Discusión

Los resultados descritos en la sección previa confirman la viabilidad de la propuesta de usar aplicaciones basadas en gestos de dibujos como un complemento educativo. Sin embargo, es necesario mencionar algunos aspectos adicionales referentes al diseño de aplicaciones de este tipo y sus posibles usos.

En primer lugar, el rendimiento de los usuarios podría incrementar o disminuir según ciertas condiciones. En este estudio los tiempos fueron calculados a base de posiciones iniciales y finales específicas, pero en la realidad los usuarios pueden adoptar otras posiciones que podrían influir en el tiempo requerido. Estas posiciones también podrían tener influencia en la fatiga de una o más partes del cuerpo. Otro aspecto que también podría incrementar la fatiga, así como el tiempo y errores, es la forma de realizar los gestos. En el estudio se pudo observar cierta incomodidad en los participantes que utilizaron su mano izquierda para realizar los gestos. Este es un detalle entendible debido a que se fijó un punto inicial para los gestos. Sin embargo, esta limitación podría resolverse creando plantillas con otros puntos de inicio, o mejor aún, utilizando un algoritmo que no dependa de un punto inicial específico como el descrito por Anthony y Wobbrock (2010).

El feedback visual es otro factor que podría tener efecto en el rendimiento de los usuarios. En base a hallazgos previos (Kim, et al., 2012), la aplicación desarrollada no mostró el trazo de los gestos realizados. Aunque algunos de los participantes propusieron mostrar el “dibujo”, esto podría hacerse en ciertos casos. Se puede así sugerir que si el objetivo perseguido requiere visualizar el trazo realizado, entonces se puede incorporar este feedback visual en la aplicación. Por el contrario, si los gestos corresponderán a comandos, entonces podría omitirse su visualización, pero el comando ejecutado deberá informar al usuario que la acción se ha llevado a cabo, como es el caso de la aplicación aquí usada (es decir, se acepta la respuesta).

Las limitaciones del hardware actual también podrían afectar no solo la eficiencia de los usuarios sino además la experiencia de interacción en general. Así por ejemplo, si se utiliza el Kinect (u otro sensor similar) en ambientes expuestos a la luz solar o si se incrementa mucho la distancia a la que se encuentra el usuario, la precisión en el reconocimiento disminuirá (Gonzalez-Jorge, et al., 2013).

Además, aunque el estudio fue realizado en un ambiente de laboratorio, a base de otros trabajos antes mencionados se puede inferir que el estilo de interacción propuesto podría usarse para complementar el proceso de enseñanza-aprendizaje adecuadamente ya sea en el hogar o en la sala de clases. En primer lugar, la aplicación empleada incluyó preguntas de un área concreta, pero esta podría ser de utilidad también en otras áreas simplemente cambiando las preguntas y respuestas. De hecho, la aplicación podría ser mejorada hasta convertirse en un producto terminado que permita al docente gestionar sus propias preguntas y respuestas, así como también incorporar otras opciones adicionales como número de respuestas, gestos usados para responder, etc. Este software resultante podría ser empleado en clase, por ejemplo, para preguntar a los estudiantes sobre su entendimiento del tema abordado pero de forma lúdica. En este caso, la interacción podría no necesariamente realizarse desde un lugar específico sino más bien desde el asiento del alumno que participa, lo que requiere abordar otros problemas como la resolución de conflictos al tener varios usuarios (Plaumann, et al., 2016) y el número de personas que se pueden reconocer y seguir simultáneamente. Por el contrario, el mismo software podría ser empleado para complementar el aprendizaje pero desde el hogar. Un posible ejemplo de esto es que el alumno repase el tema estudiado en clase, o que incluso lo haga en compañía de sus familiares o amigos, caso en el cual quizá sería más adecuado darle el enfoque de juego serio (Susi, et al., 2007). En definitiva, la aplicación desarrollada para este estudio constituye un ejemplo del uso que se le puede dar a los gestos de dibujos en ambientes educativos.

Desde luego, muchas otras aplicaciones podrían considerarse a futuro usando el mismo estilo de interacción propuesto. De hecho, algunas de las aplicaciones desarrolladas en trabajos relacionados podrían incorporar el uso de gestos de dibujos, y en particular los juegos serios (Susi, et al., 2007; Connolly, et al., 2012). Un ejemplo de estas aplicaciones puede consistir “dibujar” el número que corresponde a la respuesta de una operación matemática (similar a la propuesta de Akazawa et al. (2014a)). Otro ejemplo es ingresar la letra que corresponde a una palabra que se trata de adivinar (como en el juego “el ahorcado”) o cuya pronunciación ha sido emitida en forma auditiva (análogo a lo planteado por Akazawa et al. (2014b)). Otras opciones podrían incluir también el uso de figuras geométricas o símbolos, por ejemplo, para complementar una clase donde se usen fórmulas.

6. Conclusiones

Si se tiene en cuenta que una cantidad considerable de trabajos han reportado beneficios de las interfaces basadas en gestos para apoyar el proceso de enseñanza-aprendizaje, este artículo ha abordado un tipo de gestos que no ha sido suficientemente estudiado: los gestos de dibujos en el aire. Efectivamente, los resultados del estudio realizado confirman la utilidad de este tipo de gestos con fines educativos de acuerdo con las métricas utilizadas y las opiniones de los participantes.

En primer lugar, los tiempos requeridos para realizar los gestos se pueden considerar aceptables (2.7 segundos en promedio). Aunque superiores, estos valores son comparables tanto con los reportados por otras técnicas para hacer selecciones basadas en gestos en el aire (Ren & O'Neill, 2013) (asumiendo que se pretende seleccionar una respuesta de otra forma) como con los requeridos para ejecutar el mismo tipo de gestos en otros estilos de interacción (Castellucci & MacKenzie, 2008). En cualquier caso, estas diferencias de tiempo podrían no ser tan relevantes en comparación a los demás beneficios que el uso de este estilo de interacción puede aportar.

El aceptable rendimiento al realizar los gestos según el factor tiempo se complementa con la pequeña cantidad de errores observados. Este aspecto es notable especialmente porque todos los participantes ejecutaban este tipo de gestos por primera vez. Además, estos errores, al igual que el tiempo requerido, deberían disminuir aún más con la respectiva práctica.

De manera similar, los resultados obtenidos a base del cuestionario complementan lo inferido a partir de las métricas. Según la opinión de los participantes, los gestos utilizados fueron fáciles de aprender y de ejecutar, se sintieron confortables al realizarlos y les ocasionaron una fatiga mínima. Adicionalmente, más de la mitad de ellos expresó claramente haber disfrutado la experiencia. Todo esto permite concluir que los gestos de dibujos son bien acogidos por los estudiantes y podrían contribuir a incrementar su motivación al momento de realizar tareas educativas.

Finalmente, los aspectos referentes al diseño de aplicaciones del tipo propuesto y sus usos adicionales antes discutidos podrían considerarse en investigaciones futuras. Así mismo, podrían abordarse otros aspectos tales como contar con diferentes tipos de participantes (por ejemplo, niños), realizar la evaluación en un ambiente real (por ejemplo, durante una clase) y verificar en qué medida contribuye el uso de gestos. Tanto los resultados aquí reportados como los de estos posibles trabajos futuros deberían conducir a mejores aplicaciones basadas en gestos que ayuden a complementar y mejorar el proceso de enseñanza-aprendizaje.