Introducción

Los gobiernos y otras instituciones están considerando las transformaciones derivadas del uso de la inteligencia artificial (IA), con el objetivo de evaluar sus posibles efectos y consecuencias. Para abordar el tema, en este texto se utilizará la definición proporcionada por la Comisión Europea: son sistemas de software y hardware diseñados por seres humanos. Esos sistemas actúan en las dimensiones física o digital, mediante la percepción de su entorno a través de la obtención e interpretación de datos que recopilan, decidiendo las acciones más favorables para alcanzar un objetivo (Dirección General de Redes de Comunicación, Contenido y Tecnologías de la Comisión Europea 2019).

La IA se presenta como una tecnología prometedora para el desarrollo, lo cual también incluye la mejora de los medios de comunicación. Ofrece oportunidades para combatir la desinformación, mejorar la gestión de la privacidad y promover un enfoque ético que evite sesgos en la toma de decisiones informativas. Sin embargo, plantea riesgos como la automatización de las tareas en busca de una audiencia más amplia y la posibilidad de que el periodismo se aleje del reportaje de noticias y se enfoque exclusivamente en la investigación, lo que requerirá una reestructuración de las empresas periodísticas (Manfredi y Ufarte 2020). Se necesitará tiempo para comprender las consecuencias de modificar el modelo de negocio y permitir que los profesionales del periodismo se adapten a las nuevas infraestructuras y herramientas, y adquieran formación digital (Túñez-López, Fieiras-Ceide y Vaz-Álvarez 2021).

La inclusión de la IA en los medios plantea la pregunta de si es necesario establecer un control en las decisiones relacionadas con su uso. En caso afirmativo, los actores involucrados en el diseño, la implementación y el desarrollo de la IA, así como las personas responsables de su introducción en el sector de la comunicación, deberían participar en dichas decisiones y mitigar los riesgos derivados del uso de IA, a través de una regulación clara. La normativa en el ámbito tecnológico ha generado debates sobre las posibilidades de regulación, cómo y qué regular (Galli 2021).

Aunque la IA plantea numerosas interrogantes sobre el futuro de la prensa y las nuevas políticas de comunicación que se establecerán al respecto, su incorporación suscita, sobre todo, problemas relacionados con cuestiones éticas. Estos problemas podrían resolverse mediante la aplicación de normativas que fomenten buenas prácticas y responsabilidad, abordando los cambios introducidos por la IA desde una perspectiva jurídica y ética (Monti 2018). El objetivo principal de este estudio es proporcionar una visión comparativa de las regulaciones sobre IA en España, la Unión Europea (UE) y los Estados Unidos (EE. UU.), considerando a este último como un país clave en el avance de la IA. Además, se busca examinar cómo estas regulaciones pueden influir en la formulación de políticas de comunicación y su impacto en los medios.

Metodología

Para lograr el objetivo de este estudio, se identificaron hallazgos clave a través de la investigación documental, mediante un análisis exhaustivo de informes de la UE, la Organización para la Cooperación y el Desarrollo Económicos (OCDE) y la Organización de las Naciones Unidas para la Educación, la Ciencia y la Cultura (UNESCO). Además, se han analizado estudios relacionados con la IA y el periodismo.

Los aspectos de las regulaciones sobre IA que pueden influir en la formulación de políticas de comunicación son los siguientes: transparencia, protección de datos, responsabilidad, discriminación y sesgos.

Una vez identificados, se realizó un análisis comparativo de regulaciones sobre IA, con los siguientes objetivos:

comprobar si los hallazgos clave están incluidos en las diferentes regulaciones sobre IA;

observar similitudes y diferencias;

analizar las orientaciones de las regulaciones planteadas y cómo podrían afectar a los medios de comunicación, y

encontrar posibles enfoques para orientar políticas de comunicación.

¿Por qué es necesario comparar? La comparación es fundamental para construir un conocimiento empírico sobre el fenómeno analizado. Se realiza mediante el examen de los datos existentes, estableciendo similitudes y diferencias con el objetivo de comprender la subjetividad e intencionalidad en la elaboración de políticas (Grau Creus 2002). Con ese fin, se utilizó una matriz de elaboración propia, basada en la propuesta de Hernández Prieto, Badilla Matos y De la Peña Pérez Alaejos (2018). Dado que las iniciativas de regulación de IA analizadas corresponden a diferentes niveles de regulación, se puede comprobar cómo se implementan y articulan en contextos nacionales y supranacionales. Los resultados proporcionan una aproximación al tipo de políticas de comunicación que podrían formularse, lo cual determinará el futuro desarrollo de la IA en el ámbito de la comunicación (Monti 2018).

Relación de la IA con el periodismo

La IA se utiliza para identificar tareas noticiables, recopilar contenidos, rastrear bases de datos y generar noticias de manera automatizada o transcribir textos. Associated Press y Los Ángeles Times tienen su propia IA, la cual genera noticias online (Salazar García 2018). En Europa, aproximadamente un 68 % de las empresas la utilizan para mejorar la productividad de la plantilla. Sin embargo, la innovación con IA no siempre es la solución a dificultades existentes (Beckett 2019).

En España, el uso periodístico de la IA se centra en la edición automática de noticias. El periodismo automatizado es definido como el que usa algoritmos o software de IA para convertir datos en textos con una intervención humana escasa o nula, excepto en la programación del algoritmo, implica la recolección y selección de datos estructurados de diversas bases de datos según criterios predefinidos (Pérez-Tornero et al. 2020). Aunque la incorporación de la IA en las redacciones pueda aliviar la carga de trabajo o controlar la desinformación, su adopción se ve con cautela.

Para establecer normas de funcionamiento es necesario comprender las necesidades de empresas y profesionales de la comunicación, así como las preocupaciones relacionadas con el uso de la IA (Flores Vivar 2019). Además, existe la inquietud de que con la IA no se transmita a la sociedad cuestiones de interés público o no respete la privacidad de las audiencias, debido a la extracción de datos personales (Ventura Pocino 2021). Entre los efectos adversos de la IA en los medios se encuentran: desaparición de puestos de trabajo, amplificación de información errónea, debido a que los algoritmos priorizan ciertos contenidos y monopolización del uso de datos, lo que cual favorece el control y la influencia sobre el usuario (Izsak et al. 2022).

¿Por qué son necesarios nuevos planteamientos en políticas de comunicación?

Tal y como afirma María Antonia Martín (2003), definir la política de comunicación supone establecer un debate entre los conceptos de poder y comunicación desde diferentes puntos de vista: social, individual, tecnológico y económico. Su desarrollo estará determinado, por un lado, por las nuevas características de los medios, con procesos integrados en la personalización basada en datos y otras tecnologías de IA. Por otro lado, por procesos de regulación muy complejos. Los enfoques existentes para “controlar” el impacto de la IA dependen de cada país.

Existen diferentes maneras de abordar el desarrollo de las políticas de comunicación y regulaciones con respecto a la IA, por ejemplo, la UE opta por la intervención, mediante un paquete de medidas regulatorias de la IA. Sin embargo, EE.UU prefiere no tener derechos especiales para los medios, ni proteger el periodismo de la IA (Tambini 2021). Actualmente es importante tener en cuenta quién y cómo gobierna y quién elabora las políticas de comunicación (Roth 2014).

Análisis: marcos regulatorios

Se prevé que la regulación de la IA pueda ser tan complicada de abordar como otras innovaciones. Al regular, lo mejor sería invocar una base legitimadora de obligaciones internacionales con consentimiento estatal de sumisión a estas normas. Frente a los riesgos de una expansión descontrolada de la IA, la solución puede estar en el principio de necesidad, vinculado al principio de dignidad humana (García San José 2021).

La regulación, en este campo, se caracteriza por la complejidad del objeto a regular, los diversos intereses y grupos de presión. Sin embargo, como argumenta Petit, no se puede dejar la IA a la autorregulación. Hay que provocar un cambio de mentalidad: No son restricciones impuestas por el Estado, sino oportunidades para crear normas de interés a las preferencias colectivas y que generen confianza de que estas expectativas se cumplirán en la práctica (Erdélyi y Goldsmith 2018). En la última década, se implementaron medidas para proteger la privacidad y la seguridad, antimonopolio, entre otros. Las disposiciones destinadas a controlar contenidos generan desconfianza, porque existe el riesgo de que puedan afectar derechos fundamentales, limitando o “etiquetando” lo que puede ser o no conveniente (Neuman 2022).

¿Hasta dónde se permite el desarrollo independiente de la IA y al mismo tiempo, evitar el progreso de aspectos negativos?, ¿cómo establecer políticas de comunicación que engloben esa complejidad? La agilidad para reaccionar sobre lo que puede ser justo y positivo dentro de la innovación tecnológica es esencial para desarrollar buenas prácticas y una convivencia en el futuro. Para establecer políticas de comunicación resulta necesario aclarar si el objetivo de estas políticas es proteger y fomentar los intereses ciudadanos o si, por el contrario, se puede dejar la regulación al albedrío de la autorregulación y los códigos éticos, sin riesgos para las personas y las democracias. Sin regulación o limitaciones definidas las tecnologías pueden tomar decisiones que afecten a las personas simplemente porque han sido creados para lograr objetivos de manera eficiente (Ruaro y Guimarães Reis 2020).

4.1 Marco regulatorio supranacional: la UE

El fundamento en la elaboración de regulaciones europeas sobre tecnología busca unificar la difusión de los valores y no perder la “carrera” económica unida a la innovación tecnológica (Martín 2003). Por experiencia, la UE tomó la iniciativa en el control de la IA, aprobó regulaciones para limitar el poder de las grandes empresas y controló la desinformación (Neuman 2022). La Comisión Europea dejó clara la necesidad de adoptar un enfoque multifactorial en las regulaciones y mantener la independencia en cuanto a la capacidad industrial, sin excluir aspectos éticos y derechos fundamentales. Asimismo, la regulación es importante para fortalecer el aspecto económico que acompaña la implementación y desarrollo de la IA, ya que representa un volumen importante de negocio.

La UE ha propuesto tres iniciativas normativas interrelacionadas:

Un marco jurídico europeo que aborda cuestiones relacionadas con los derechos fundamentales y riesgos de seguridad derivados del uso y desarrollo de la IA.

Normas de la UE encargadas de analizar cuestiones sobre responsabilidad en los sistemas de IA.

Revisión de actos jurídicos normativos de seguridad sectorial.

En la misma línea de protección y orientación, el Grupo de Expertos Europeo de alto nivel sobre Inteligencia Artificial (Comisión Europea 2021b) elaboró pautas centradas en el ser humano, las cuales incluyen siete requisitos claves: Acción y supervisión humanas; solidez técnica y seguridad; privacidad y gobierno de datos; transparencia; diversidad, no discriminación y equidad; bienestar ambiental y social; rendición de cuentas. Estas son necesarias para que los sistemas de IA se consideren confiables. Además, añadieron 33 recomendaciones para que sea más competente, sostenible e inclusiva.

El entramado regulatorio de la UE pasa por la creación de la Alianza de IA, que impulsa la generación de políticas desde un enfoque participativo. Esta alianza lleva a cabo discusiones sobre logros y perspectivas de sus políticas y presenta los aspectos principales del Libro Blanco de la Comisión sobre Inteligencia Artificial, cuyo objetivo es coordinar un enfoque europeo de regulación que aborde las implicaciones éticas y humanas de la IA (Comisión Europea 2021).

Sin embargo, la propuesta central de la UE es el Reglamento sobre la IA de 2021, para afrontar los problemas que pueden surgir en el desarrollo de la IA. Este afectará el funcionamiento de los medios y las plataformas digitales. Se aplicarán obligaciones de transparencia en los sistemas que “generen o manipulen contenido o si un sistema de IA se usa para generar, manipular imágenes, audios o vídeos que parezca contenido auténtico debe informarse que el contenido ha sido generado por medios automatizados excepto si responden a fines legítimos” (Comisión Europea 2021a, 18).

Con todo, el reglamento es aprobado por el Parlamento Europeo el 14 de junio de este año y modificará determinados actos legislativos. Incluye enmiendas relativas a sistemas de IA consideradas de alto riesgo y la obligación de explicitar si los contenidos han sido generados por IA. Una de las novedades importantes hace referencia a la aprobación de la definición de sistemas de IA y la inclusión de definiciones nuevas, como la relacionada con la “ultrafalsificación” o la “elaboración de perfiles” (Parlamento Europeo 2023, 44).

El Reglamento supone la primera regulación de carácter global conocida y la primera regulación jurídica de IA. Refleja una toma de posición de la UE ante la irrupción de la IA. Además de las enmiendas y como novedad, en el texto destaca la inclusión en la regulación a implementadores y proveedores de sistemas de IA establecidos en la UE.

También se regulan como sistemas de alto riesgo los de identificación biométrica de control masivo en tiempo real y los biométricos en diferido, solo se permitirán a las fuerzas de seguridad con autorización judicial para delitos graves. Las plataformas de Redes Sociales (RRSS) tendrán que modificar o revisar sistemas de recomendación de contenido para que se supervisen y reduzcan el sesgo de conformación. La aprobación del texto definitivo mostrará cómo se gestionan y regulan cuestiones como la prohibición o la introducción de normas que limiten la vigilancia masiva, el sesgo y protejan a la ciudadanía y a colectivos vulnerables.

El marco regulatorio europeo se refuerza gracias a los siguientes instrumentos jurídicos:

Ley de Mercados Digitales;

Ley de Datos: eliminará los obstáculos al acceso de datos para el sector público y privado. La creación de un espacio europeo de datos garantizará las soluciones de IA en la UE, y

Ley de Servicios Digitales (DSA): promueve un entorno en línea más seguro. Los prestadores de servicios intermediarios dirigidos a usuarios europeos deberán adaptar sus servicios a la normativa europea.

La UE recomienda lo siguiente a las personas encargadas de formular políticas:

1. Fomentar el uso de sistemas basados en blockchain para permitir almacenar y compartir datos sin perder el control en la propiedad.

2. Agrupar datos en Europa para desarrollar IA culturalmente diversa.

3. Fomentar y desarrollar herramientas de evaluación para supervisar estándares y cumplimiento.

4. Adoptar reglas claras que sirvan de marco de referencia sobre la responsabilidad en las decisiones de la IA.

5. Adoptar reglas para que las plataformas en línea publiquen una guía de usuario sobre los sistemas de recomendación.

6. Fomentar la reducción del sesgo en aplicaciones de IA (Izsak et al. 2022).

Este entramado regulatorio no resuelve todos los problemas, algunas de las dificultades más importantes como la responsabilidad por parte de las plataformas en línea aún carecen de solución (Arroyo Amayuelas 2021).

4.2 España

Las políticas de comunicación en España se demoraron debido al desarrollo de nuestro sistema mediático. Aquellas elaboradas en las décadas de los 80 y 90 mostraron muchas contradicciones. En la actualidad es necesario orientar de manera normativa el funcionamiento de los medios y herramientas tecnológicas, por su impacto en la gestión de la información. Las nuevas tecnologías requieren mecanismos públicos para orientarlas (Martín 2003).

En el ámbito mediático, predomina la autorregulación. Se elaboró una legislación laxa sobre comunicación, entre otros aspectos, debido a un pasado nada democrático y a la relación entre política y medios de comunicación. Además, hay que añadir la existencia de grupos de interés que intentan influir en la elaboración de políticas públicas. Por tanto, elaborar una legislación para regular aspectos del sistema mediático genera desconfianza (Hernández Prieto 2015), lo que podría obstaculizar el desarrollo de políticas orientadas a los medios y al interés público. España sugiere diseñar políticas basadas en los desafíos de la IA, centrándose en el acceso a los datos, la transparencia y la financiación, e incluyendo a actores clave (Caramiaux 2020). Para ello, plantea seis ejes estratégicos, resumidos en el informe de estrategias nacionales de IA (diciembre de 2020):

1. impulso a la investigación, desarrollo tecnológico e innovación;

2. fomento de las capacidades digitales;

3. desarrollo del talento nacional y atracción del internacional, avance de infraestructuras que den soporte a la IA;

4. integrar la IA en la transformación de la economía;

5. impulsar el uso de la IA en las estrategias nacionales, y

6. establecer un marco ético que garantice los derechos individuales.

El Sistema Español de Ciencia, Tecnología e Innovación (SECTI) coordina las políticas de investigación en IA. Se establece un plan de digitalización del sector público para el período 2021-2025, así como una Carta de Derechos Digitales y un nuevo marco legislativo (Van Roy et al. 2021). La Estrategia Nacional de IA (ENIA) tiene como objetivo principal vertebrar la acción de las diferentes administraciones y crear un marco de referencia para el sector público y privado. Esta estrategia es uno de los elementos fundamentales de la Agenda España Digital 2025, en la cual la IA se considera un elemento de transformación social. Los objetivos de la ENIA incluyen la promoción de la innovación y la excelencia científica, la creación de empleo cualificado, la transformación del tejido productivo, el establecimiento de un entorno de confianza, el impulso al desarrollo de valores humanistas asociados con la IA, así como la promoción de la inclusividad y sostenibilidad. Se prevé que los medios de comunicación sean uno de los sectores que experimenten un impacto de 6,7 %, debido al desarrollo de la IA (Gobierno de España 2020).

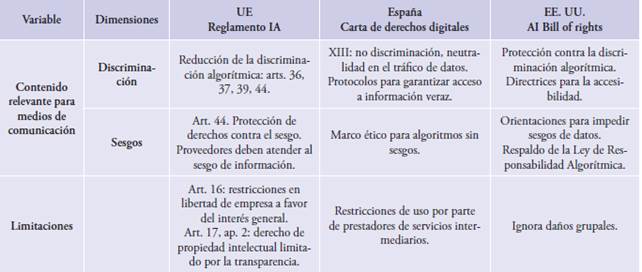

La iniciativa regulatoria más amplia es la Carta de Derechos Digitales, producto del trabajo del Grupo Asesor de Expertas/os de la Secretaría de Estado de Digitalización e IA del Ministerio de Asuntos Económicos y Transformación Digital. El objetivo es desarrollar nuevos derechos digitales que no difieran de los derechos fundamentales, perfilar los más relevantes en entornos digitales y describir derechos auxiliares. Esta normativa se basa en los derechos digitales establecidos en el Título X de la Ley Orgánica 3/2018 de 5 de diciembre de Protección de Datos Personales y Garantía de Derechos Digitales y en el RD Ley 28/2020 de 22 de septiembre. Los capítulos de esta Carta relacionados con la comunicación se visualizan en la tabla 1.

Tabla 1 Capítulos de la Carta de Derechos Digitales relacionados con la comunicación

Fuente: elaboración propia con datos de la Carta de Derechos Digitales, Gobierno de España 2021.

Las administraciones públicas quieren impulsar tecnologías para el bienestar y adelantarse a las consecuencias negativas que puedan surgir. La regulación debe ser flexible, la implicación pública servirá para salvaguardar objetivos que van más allá de lo económico o evitar la discriminación (García Blanco 2020). En España, la autorregulación es el principal mecanismo ético, pero en el código ético de la Federación de Asociación de Periodistas de España (FAPE), por ejemplo, no hay mención expresa a la IA. Es necesario indicar qué noticias ha realizado esta para que pueda ceñirse a los criterios del periodismo y controlar los sesgos del algoritmo. El periodista debería ser supervisor del trabajo que realiza la IA (Ufarte, Calvo y Murcia 2021).

Abordar seriamente las políticas de comunicación españolas, de manera coherente con la realidad en la que se desarrollan, constituye una necesidad. Su implementación puede contribuir a un mayor conocimiento de nuestro sistema comunicativo (Ruaro y Guimarães Reis 2020). La autorregulación y las políticas pueden establecer un sistema de gobernanza de la IA. La efectividad del derecho puede reforzarse mediante políticas y estrategias éticas en el ámbito de la IA. La ética puede servir de inspiración para la creación de normativas y diversas políticas (Cotino 2019).

4.3 Estados Unidos

La regulación estadounidense es sectorial; adopta enfoques para áreas concretas como privacidad, seguridad y ética. La ley sobre IA más avanzada y pionera es la de Privacidad del Consumidor y Protección de datos en California. En la elaboración de normativa, las agencias gubernamentales tienen un papel destacado. Se han presentado propuestas para la transparencia de los algoritmos y la responsabilidad de organismos autónomos, como el Acta de Transparencia de Algoritmos y la Ley de Responsabilidad de Sistemas Autónomos.

Estados Unidos es líder en el uso y desarrollo de la IA, por lo que la observación y el análisis de su gestión regulatoria pueden sentar las bases para futuras regulaciones en otros países. Aunque aún no cuenta con amplias regulaciones nacionales, se ha desarrollado una estrategia nacional de IA y existen propuestas de proyectos de ley que son también producto de la participación de empresas o grupos privados (Kerry 2019).

La falta de regulaciones en EE. UU tiene su origen en las características propias de su configuración institucional (Abdalá, Lacroix y Soubie 2019). Según Frank Pasquale (Belsunces 2022), la dificultad regulatoria en cuanto a los medios de comunicación, el periodismo y la tecnología se explica, en gran medida, porque la libertad de expresión es un valor público y, de acuerdo con la tradición liberal, los derechos individuales son más importantes que los colectivos. Por tanto, cualquier intento de regulación del área mediática o tecnológica va a enfrentar reclamos. Aun así, en 1976, el Congreso de Estados Unidos creó la Office of Science and Technology Policy (OSTP), la cual se dedica a asesorar al presidente y a la oficina de la presidencia en asuntos de ciencia y tecnología. La OSTP supone una ventaja en cuanto a la previsión y coordinación de diferentes medidas que se puedan tomar con respecto a la introducción de novedades tecnológicas y científicas.

El 12 de octubre de 2016 Estados Unidos comenzó a abordar la actividad de la IA con el informe Preparing for the future or Artificial Inteligence. Presentado por el Comité de Tecnología del National Sience and Technology Council (NSTC 2016), muestra las estrategias del gobierno sobre la IA. Este informe deja claro que la regulación del mercado debe centrarse en proteger la seguridad pública y evaluar los posibles riesgos derivados de la inclusión de la IA, ya que la normativa existente no es suficiente.

El respeto a los derechos civiles y a la innovación resulta fundamental en las regulaciones estadounidenses. Las primeras aproximaciones se centran en los ámbitos de defensa y seguridad. El informe de 2016 define la IA y establece una comisión independiente: la Comisión de Seguridad Nacional sobre IA. Creada para asesorar al entonces presidente Trump, cesó sus operaciones el 1 de octubre de 2021 con pocos resultados extrapolables al impacto de la IA.

Como complemento al informe de 2016, se promulgó el Algorithmic Accountability Act of 2019 (Congress.gov 2019). Esta Ley busca evitar la discriminación provocada por los algoritmos (López 2021). Según resume Will Douglas Heaven (2021), este proyecto de Ley de responsabilidad algorítmica se presenta para mejorar la transparencia, la equidad en las decisiones y, sobre todo, la rendición de cuentas.

La existencia de normas comunes para que las empresas tengan en cuenta el impacto de la IA es clave, ya que tendrán que remitir informes regulares a la FTC (Federal Trade Comission) sobre su actividad con la IA y los algoritmos. Además, los consumidores y defensores podrán consultar los informes. La FTC cuenta con el apoyo bipartidista en el Senado y tiene la facultad de hacer cumplir la normativa. A diferencia de las recomendaciones de la UE, lo que caracteriza a la FTC es que tiene un gran poder regulatorio sobre el territorio nacional, lo que le permite evaluar los sistemas antes de su lanzamiento al mercado (Tutt 2016).

La Carta de Derechos de IA (Bill of Rights of IA), presentada en 2021 por la OSTP tiene la ventaja de contar con el Comité de Tecnología del NSTC. El NTSC supervisa el uso de IA en la industria, promueve el debate y permite la participación pública (Trejo 2019). La Carta es el marco general normativo nacional no vinculante más importante. Se erige sobre cinco pilares estratégicos: sistemas seguros y eficaces; protecciones contra la discriminación algorítmica; protección de datos, notificación y explicación; alternativas humanas; consideración y retroceso.

Para mayor efectividad, se elabora un manual que incorpora medidas protectoras que orientarán las acciones destinadas a evitar que la IA impacte en derechos, oportunidades o acceso del público a cuestiones básicas. Las medidas se dirigen a proteger a las personas sin excluir a las grandes empresas. Se trata de una guía para proteger a la sociedad de las posibles amenazas derivadas del uso de la IA.

Según un estudio de Harvard, existen 55 organizaciones estadounidenses que, entre 2018 y 2022, formularon recomendaciones para políticas relacionadas con la IA, sobre todo en relación con la industria. Sin embargo, apenas se encontraban recomendaciones para los medios de comunicación. En 2022 se aprobaron varias leyes en cinco estados. Algunas prohíben usar el reconocimiento facial en investigaciones criminales, otras, como la de California, promueven la inversión para el desarrollo de IA en guarderías. En Maryland, se establece financiación para su uso en el estudio y la generación de soluciones climáticas (Maslej et al. 2023).

Sin embargo, las medidas proteccionistas siguen siendo escasas. No hay regulaciones suficientes para proteger a la ciudadanía y las que existen no resultan estrictas (Heikkilä 2022). Según el congresista Ted Lieu (2023), en un artículo publicado en el New York Times, pasar de una regulación casi nula de la IA a crear una agencia federal reguladora no sería aprobado por el Congreso. La alternativa sería crear una comisión no partidista para brindar recomendaciones y dejar claro qué se debe regular.

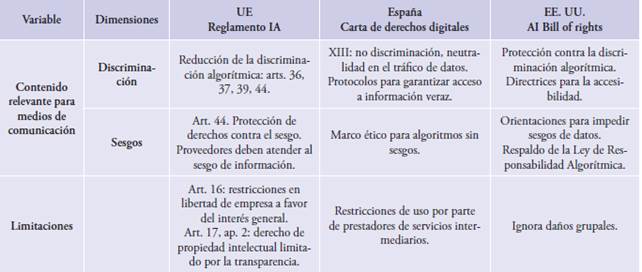

Los aspectos analizados en los diferentes marcos regulatorios quedan reflejados en la tabla 2, donde se comparan las propuestas sobre IA teniendo en cuenta los hallazgos clave.

Tabla 2 Matriz propuesta para el análisis comparado de casos, basada en los hallazgos clave (transparencia, protección de datos, responsabilidad, no discriminación y sesgos)

Fuente: elaboración propia con base en el diseño de Hernández Prieto, Badilla Matos y De la Peña Pérez Alaejos (2018).

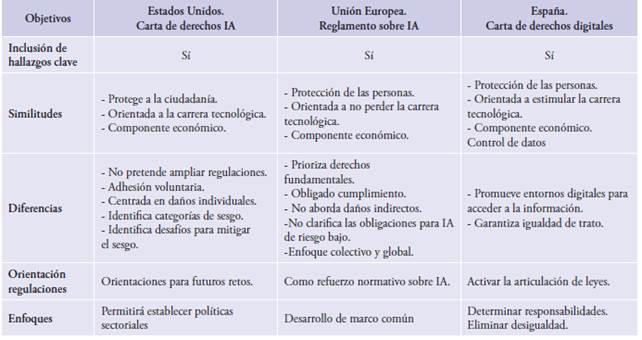

Una vez analizadas y comparadas las regulaciones, se da respuesta a los objetivos planteados al comienzo del análisis (tabla 3):

Tabla 3 Comparación de objetivos entre Estados Unidos, Unión Europea y España

Fuente: elaboración propia

Las regulaciones analizadas incluyen todos los hallazgos clave. En la UE se aprecia en la aprobación del Reglamento europeo de IA de 14 de junio de 2023, en el que la definición de sistemas de IA está en consonancia con las definiciones de la OCDE (OECD Legal Instruments 2019). Además, en el caso estadounidense la protección de datos es uno de los pilares de la carta. En todos los casos hay coincidencia en la protección a las personas sin olvidar el componente económico y de desarrollo tecnológico.

Las diferencias, aportan evidencias sobre el desarrollo de la IA y sus necesidades específicas: evitar y controlar el sesgo o promover los derechos fundamentales y la igualdad.

En cuanto a la orientación de las políticas de comunicación en EE. UU, la Carta de derechos IA estadounidense puede provocar que los medios de comunicación se adapten solo a las disposiciones generales. A pesar de la resistencia estadounidense a ampliar regulaciones, la Carta ha suscitado la aparición de normativa sobre IA en diferentes estados. Pero no se prevé ningún tipo de protección especial a los medios ni a las empresas mediáticas. Se anticipan dificultades en el proyecto de crear una agencia federal reguladora de la IA por la tradicional resistencia norteamericana a las regulaciones. La Carta, influirá en futuras normas relativas a la transparencia y control de sesgos, pero al ser de adhesión voluntaria se encontrarán diferentes niveles de transparencia en los medios de comunicación y su introducción dependerá de la filosofía de cada empresa.

En la UE, la orientación de las políticas de comunicación se dirige a reforzar la normativa europea sobre IA. Pero puede existir dificultad en la elaboración de políticas de comunicación específicas complicada por la aparición de regulaciones paralelas, como las Directivas sobre responsabilidad civil y el control de datos respaldado por el Reglamento General de Protección de Datos (RGPD). En cuanto a su impacto en los medios tendrá que esperar a su articulación con la futura Ley de Medios de la UE.

En España, la Carta establece la base para la activación de otras leyes. El capítulo XV de la Carta aborda la cuestión de la delimitación de contenidos y el riesgo de censura indirecta en los medios de comunicación. Sin embargo, es importante destacar que la Carta española no proporciona criterios claros para esta delimitación de contenidos. Por lo tanto, será necesario establecer criterios precisos y transparentes en este ámbito

Los enfoques de las regulaciones estadounidenses se dirigen a permitir el establecimiento de políticas sectoriales centradas en ámbitos más específicos. Las políticas de comunicación van a tener que dirigirse hacia una visión nacional común en aspectos relacionados con la protección a los usuarios y el respeto a los derechos civiles. El enfoque de las políticas europeas, no va a dejar mucho margen de acción al resto de los Estados miembros porque el Reglamento es de obligado cumplimiento y estará guiado por el entramado de normativa tecnológica, de protección de datos y la futura ley de prensa.

El enfoque de las políticas de comunicación en España persigue generar nuevas leyes relacionadas con la IA como la Ley 15/2022, de 12 de julio, integral para la igualdad de trato y la no discriminación (BOE de 13 de julio). Esta Ley establece que los algoritmos de IA implicados en la toma de decisiones han de minimizar sesgos, aumentar la transparencia y la rendición de cuentas. Las políticas pretenderán evitar la discriminación y prevenir el perfilado de datos limitando el refuerzo ideológico o de estereotipos. Se desarrollarán políticas de comunicación para fomentar pequeñas empresas o empresas independientes de comunicación.

Conclusiones

Se observa un impulso global en la necesidad de establecer regulaciones para gobernar la IA, debido a problemas como la discriminación y el sesgo. Con respecto a los medios, es indudable que la IA puede modificar el modelo de negocio y la profesión. Necesitaremos intervención humana para controlarla y que el interés público o la verificación de los hechos no pasen por alto. Una vez implantada la IA en el entorno comunicativo, surgen nuevos problemas. Por tanto, es necesario diseñar políticas que respalden a las pequeñas y medianas empresas de comunicación.

Las regulaciones planteadas desde la UE y las políticas perfiladas desde España vienen marcadas por un componente económico y de protección de derechos. No hay que buscar solamente soluciones fiscales o limitar el poder de las empresas tecnológicas dominantes, se necesitan soluciones conjuntas que protejan a los medios y a la ciudadanía.

Las regulaciones analizadas se dificultarán. Las resistencias entre los Estados de la UE, las generadas por grupos de interés, lobbies y grandes empresas que operan a escala mundial confluyen en Europa. Intentar cohesionar modos de protección a los derechos fundamentales con la libertad de empresa y la competencia resulta complejo, y se desconoce hasta qué punto va a influir en las políticas nacionales. Lo interesante de la regulación europea es la armonización de principios comunes y la inclusión de la perspectiva de derechos humanos en la regulación de las tecnologías emergentes. Sin embargo, la tradicional resistencia norteamericana a una regulación más amplia puede generar problemas y hacer que se traten estas cuestiones dentro de regulaciones nacionales que no están necesariamente orientadas al uso de la IA.

Las regulaciones y el desarrollo de políticas han de incluir una perspectiva ética y de derechos humanos. La autorregulación puede evitar que poderes públicos y privados se excedan y utilicen la carencia de políticas de comunicación para intervenir en el espacio comunicativo. Los planteamientos para las nuevas políticas de comunicación deben tener en cuenta la multifactorialidad, reforzar sistemas de comunicación libres e independientes y encontrar un equilibrio entre la protección, la flexibilidad y la no intervención.