Forma sugerida de citar:

Mellado-Moreno, P.C., Sánchez-Antolín, P., & Blanco-García, M. (2021). Tendencias de la evaluación formativa y sumativa del alumnado en Web of Sciences. Alteridad, 16(2), 170-183. https://doi.org/10.17163/alt.v16n2.2021.01

1. Introducción y estado de la cuestión

Las decisiones que se toman acerca de la evaluación del alumnado no se hacen de forma aislada, sino que son reflejo del posicionamiento epistemológico que se adopta sobre el proceso de enseñanza-aprendizaje en su conjunto. Estas posiciones han sido variadas a lo largo del siglo XX y XXI, con teorías y visiones pedagógicas dispares, que confrontan sobre qué se debe evaluar, para qué y cómo hacerlo (Acosta-Baldivián & De la Cruz, 2016; Ballano-Olano et al., 2011; Escudero-Escorza, 2003; López-Pastor & Pérez-Pueyo, 2017), llegándose a elaborar cerca de 50 modelos distintos distribuidos entre los que emplean un paradigma positivista orientado a la calificación (que caracterizamos como evaluación desde el marco pedagógico de la racionalidad técnica o evaluación sumativa) o un paradigma cualitativo orientado al aprendizaje (que caracterizamos como evaluación desde el marco pedagógico de la racionalidad crítica o evaluación formativa) (Gros-Salvat & Cano-García, 2021; López-Pastor & Palacios-Picos, 2012; Luzuriaga, 1985; Negrín-Fajardo & Vergara-Ciordia, 2006).

Estos marcos pedagógicos (racionalidad técnica y racionalidad crítica), que dan lugar a unas prácticas evaluativas que le son propias (sumativa y formativa) y que conforman el estado de la cuestión del estudio, se entienden como teorías distintas cuyo desarrollo histórico explica su conceptualización, pero que no son necesariamente excluyentes y pueden ser integradas de manera complementaria en la práctica educativa, dado que, como se verá a continuación, satisfacen necesidades distintas.

1.1. La evaluación desde el marco pedagógico de la racionalidad técnica: La evaluación sumativa

Partiendo del modelo de producción taylorista (Sancho, 2017), la evaluación educativa positivista adopta un modelo empresarial y economicista con referentes como Henry Fayol (Rodríguez-Laguía et al., 2010), teórico clásico del enfoque funcional de la administración (Hernández-Palma, 2011), que estableció en 1916 un método de evaluación administrativa basado en segmentar y descomponer los elementos de la totalidad, distinguiendo entre previsión, organización, dirección, coordinación y control; para su análisis, planificación y posterior evaluación (González-Díaz, 2010). Estos principios de evaluación empresarial se aplicaban a la educación a través de la evaluación sumativa para analizar el rendimiento del alumnado, controlando los objetivos propuestos y el tiempo empleado como pretendida garantía de objetividad y obtención rigurosa de evidencias (Casanova, 2019).

Por ello, la evaluación sumativa conlleva normalmente instrumentos y técnicas de evaluación del alumnado sencillas, escasas y centradas en el diseño experimental, mediante pruebas estandarizadas o entrevistas personales (Stufflebeam & Shinkfield, 1985). Instrumentos que buscan medir el rendimiento del alumnado, que la evaluación desempeñe un papel de refuerzo operativo positivo o negativo, que permita observar el resultado de un producto acabado y que obvia el proceso de transformación y las condiciones de inicio, simplificando así la conducta humana (Pérez-Gómez, 2004).

Esta corriente continúa su recorrido histórico poniendo el enfoque en el desarrollo curricular de Ralph Tyler, que plantea en su obra Basic Principles of Curriculum and Instruction (1949) un modelo basado en el diseño de objetivos, indicando que el profesorado se guía por conocimientos intuitivos a través de los cuales se establecen los criterios sobre qué materiales seleccionar, qué contenido es procedente, qué procedimientos hay que efectuar y qué examinar. Aunque admite la existencia de una controversia en torno a enseñar lo mismo y evaluar a todo el alumnado de la misma manera, defiende que existen necesidades comunes en el alumnado, o al menos, entre el alumnado norteamericano en un momento histórico concreto de gran expansión de la escolarización en EEUU caracterizado por una ausencia de planificación sistemática para el diseño de la práctica docente (Wraga, 2017). Por lo tanto, Tyler diseña una evaluación por objetivos iguales para todos, elaborando un cuadro de doble entrada que cruza los objetivos propuestos para la consecución de la asignatura con siete ítems conductuales, marcándose por parte del evaluador aquellos que se consideren alcanzados satisfactoriamente.

Años después, Bloom (1956) con su taxonomía de objetivos educativos profundiza sobre el planteamiento base de Tyler (Tian et al., 2018) tomando como precedente la organización taxonómica de las especies en la biología, tratando de hacer una clasificación de los aprendizajes análoga a la clasificación de las especies y que actualmente todavía se utiliza para clasificar conocimientos de múltiples disciplinas (Bedford et al., 2017; Brewer & Brewer, 2010; Sisson & Mazzuchi, 2017; Sönmez, 2019). En materia evaluativa, Bloom (Amer, 2006; Shugert, 1968) realiza una clasificación más racional de los objetivos operativos y los ítems de Tyler a la hora de diseñar las pruebas escritas (test) con los que se sigue evaluando el aprendizaje del alumnado. Quizás lo más novedoso es la noción que aporta William (2006) sobre la obra de Bloom; planteando que la intencionalidad del evaluador se debe considerar como el elemento diferenciador que puede superar la naturaleza del instrumento, ya que una misma prueba puede ser empleada para realizar tanto una evaluación sumativa como formativa según los objetivos y estrategia evaluativa que se marque el docente al respecto.

El siguiente paso en la evolución de la evaluación sumativa lo aporta Mager (1973), cuyo objetivo es alcanzar la máxima objetividad a la hora de evaluar. Por ese motivo, propone reformular cualquier objetivo que requiera de una interpretación docente o requiera de una adaptación a las necesidades específicas del grupo o del contexto, reformulando esos objetivos considerados ambiguos. Así, todo aprendizaje que no pueda ser observado de manera clara e inequívoca y evaluado por un cuestionario resulta problemático, debiendo ser sustituido por otro.

En la década de los ochenta destaca Stufflebeam (1985) que, en línea con el Joint Committee on Standars for Educational Evaluation (Diamond, 1985), establece un modelo de evaluación curricular llamado Context-Input-Process-Product (CIPP) que determina la utilidad de lo que se enseña y se evalúa en lo que quiere el “cliente” y no el evaluador, basando la fiabilidad de los estándares de evaluación en su aplicabilidad al mundo real, su conveniencia en su carácter ético y constitucional, y su exactitud en la aceptación que merezca a través de un juicio técnico (Stufflebeam, 1985). Así, las decisiones sobre qué evaluar y cómo implican determinar cuáles son las expectativas de las familias del alumnado, qué aporta a la sociedad aquello que se enseña y evalúa, determinar hasta qué punto es necesario y si los recursos que requiere consumir lo hacen viable.

Con la llegada de la década de los 90 y la tercera revolución tecnológica en el ámbito de la información y comunicación, se alumbra la llamada sociedad del conocimiento (Barroso-Jerez, 2013; Taberner-Guasp & García-Marín, 2013), que tiene implicaciones en la manera en la que aprendemos (Zambrano-Farias, 2017), la manera en la que debemos enseñar (Muñoz-López et al., 2018) y la manera en la que debemos evaluar (Juárez-Hernández & Ponce-López, 2020). Pero a la vez que se sucede la transformación y digitalización de la economía y la sociedad, la psicología y la filosofía hegemónicas abrazan de nuevo el conductismo y el positivismo, que impulsa el enfoque de una evaluación del aprendizaje del alumnado objetiva, científica y fragmentable (Forde et al., 2016), con una enseñanza programada y basada en la taxonomía de objetivos operativos de aprendizaje (Torres- Santomé, 2017) y un nuevo auge de pruebas de evaluación estandarizadas (Rizvi & Lingard, 2010; Robinson & Aronica, 2016).

Bajo el marco pedagógico de la racionalidad técnica, la evaluación sumativa del aprendizaje del alumnado se define como la búsqueda objetiva de resultados a través de la obtención de evidencias con una función fundamentalmente acreditadora y operatoria de refuerzos positivos y negativos. El resultado de la evaluación sumativa determina la distancia entre lo que la norma establecida considera aceptable y la posición mesurable en la que se encuentra el alumnado con respecto a ella. Los objetivos operatorios deben ser concretos, clasificables y comprendidos perfectamente tanto por el profesorado como por el alumnado. Las pruebas de evaluación han de ser estandarizadas, universales, procedimentalmente sencillas y diseñadas a gran escala para todo el sistema educativo, por lo que preferiblemente adoptarán el formato de test.

1.2. La evaluación desde el marco pedagógico de la racionalidad crítica: La evaluación formativa

De forma paralela al desarrollo de la evaluación desde el enfoque de la racionalidad técnica, surgen distintas ideas de renovación crítica ante una enseñanza tradicional basada en la autoridad, en el magistrocentrismo, la pasividad del alumnado, la reproducción de las desigualdades sociales y la supuesta objetividad del profesorado examinador de evaluaciones sumativas (Álvarez-Méndez, 2003; Barrios-Graziani, 2005; Campdepadrós-Cullell & Pulido, 2009). Son pedagogías que se pueden encuadrar en el marco tanto del idealismo como del materialismo pedagógico, según las fuentes y bases teóricas empleadas en cada caso para la crítica (Murillo-Torrecilla & Hernández-Castilla, 2015; Vilanou-Torrano, 2015; Zuleta-Medina & Chaves-Torres, 2009) y que surgen como reacción a la pedagogía positivista, entendiendo que el aprendizaje y su evaluación son procesos demasiado complejos como para reducirlos a estándares (Clarke & Moore, 2013), ya que se considera que los aprendizajes son elementos fundamentalmente prácticos, construidos social e históricamente (Tapiero-Vásquez, 2000) y donde el interés del alumnado por el asunto a aprender se alza como el elemento fundamental (Wiliam, 2011) dentro de un ambiente y un trasfondo familiar que determina en mayor medida los resultados del alumnado que la propia variable escolar (Chomsky, 2014).

Aunque la aparición del término de evaluación formativa se lo debemos a Scriven (1967), que junto con otros autores norteamericanos como Stake (1967) o Stenhouse (1975) entendían que la evaluación sumativa era una limitación para la innovación y la mejora progresiva de la educación, las alternativas a la evaluación sumativa tradicional hunden sus raíces en la corriente renovadora progresista norteamericana que combinaba la reforma educativa con la reforma social, y que tiene en Dewey uno de sus pedagogos más influyentes (González-Monteagudo, 2001). Dewey (2002) relaciona el concepto de evaluación con el de la valoración, y lo hace en un doble sentido. Se parte de que una valoración es para estimar algo, para apreciarlo, pero también para emitir un juicio de valor que sirva para compararlo con otro. En el primer caso nos encontramos ante una valoración intrínseca, donde las cosas tienen un valor por sí mismo, no son objeto de juicio y, por tanto, invalorables. En el segundo, hacemos una valoración extrínseca, por la cual podemos establecer categorías comparables y ordenables para determinar lo que es mejor de lo que es peor.

En España este movimiento se replica a través de la Escuela Unificada, de inspiración krausista y orteguiana, destacando Giner de los Ríos entre sus pensadores implicados en la pedagogía. Para Giner de los Ríos los exámenes son percibidos por el alumnado como interrogatorios (García-Velasco, 2015), que desvirtúan el sentido de la educación, provocan aprendizajes efímeros y aparentes, y no es una herramienta al servicio de la educación sino lo contrario (Giner De los Ríos, 1894).

La alternativa a la evaluación del alumnado desde una perspectiva crítica adquiere un mayor peso teórico con la pedagogía freireana, donde se renuncia al castigo y al suspenso (Araújo-Freire, 2017) o a la educación bancaria que se limita a la repetición mecánica de aquello que se le ha dicho al alumnado en clase (Gomes-Arelaro & Martins-Cabral, 2017), tratando en su lugar de averiguar, a través de la evaluación, si el alumnado es capaz de acceder por sí mismo a un determinado conocimiento (Delbosco, 2018) que habrá de ser útil para la vida social del ser humano (Gauterio- Cruz et al., 2014).

La visión freiriana de la evaluación coincide con el análisis crítico que realiza la pedagogía materialista, que relaciona la educación con el trabajo y analiza la pedagogía desde un punto de vista histórico-culturalista (Barros-Ferreira & Vicentini, 2017). Este es el caso de Basil Bernstein (1975), que reflexiona sobre la necesidad de examinar las implicaciones sociales y las relaciones de poder que subyacen al proceso de evaluación del alumnado y que define la función de la evaluación como la determinación de los contenidos que deben ser transmitidos socialmente y que está condicionada por la ideología del docente, lo cual provoca una alta disparidad entre lo que cada docente enseña y lo que su respectivo alumnado aprende. Apple (1994) comparte el mismo planteamiento, pero entiende que además de la económica hay que considerar la dominación que se ejerce en el plano cultural, de manera que no sitúa a las clases medias en términos de explotación económica sino de subordinación cultural. Esas relaciones de poder entre clases establecen límites a lo que es posible en el sistema educativo, donde el discurso y la identidad juegan un papel crucial.

Así pues, desde la pedagogía crítica, se defiende una evaluación formativa con características subjetivas (Becerra-Hernández & Moya-Romero, 2008), contextualizada, comprensora, permanente, heterogénea, comunicativa, dialéctica y diseñada para que nos dé la información oportuna de la evolución de cada uno de los individuos que forman parte del proceso de enseñanza (Antón-Sancho & Sánchez-Domínguez, 2020; Borjas, 2014; Fonseca, 2007; Maureira-Cabrera et al., 2020; Molina-Soria et al., 2020). Una evaluación formativa integrada en la práctica educativa (Allal & Pelgrims Ducrey, 2000) con unos objetivos flexibles adaptados a las necesidades e intereses personales de cada individuo como forma de satisfacer un interés público: la inclusión educativa (House, 2000). Esta evaluación formativa pretende ampliar la evaluación hacia destrezas y actitudes (Acebedo, 2016; Puiggali-Allepuz & Tesouro-Cid, 2021) para reorientar el proceso de aprendizaje enfocado a mejorar la ayuda pedagógica que se presta al alumnado (Valero-Flores, 2017).

Desde el marco pedagógico de la racionalidad crítica, la evaluación formativa se define como la búsqueda subjetiva, en tanto que individual y personal, de la evolución que ha experimentado cada sujeto gracias a la intervención educativa. La función operatoria de la evaluación sumativa da paso a la función informadora de la evaluación formativa que tiene como finalidad, no acreditar conocimientos, sino mejorar el proceso de enseñanza-aprendizaje. El resultado de la evolución no es determinista y comparable, pero tiene un valor intrínseco y descriptivo acerca de los logros alcanzados a través de unos objetivos flexibles y adaptados a cada individuo. Los instrumentos de evaluación son heterogéneos, empleados permanentemente, contextualizados y variados.

2. Metodología

El enfoque metodológico del estudio es el propio de los estudios bibliométricos, realizando un análisis mediante estadística descriptiva, centrado en el análisis de frecuencias de la producción de artículos y sus principales indicadores bibliométricos como son el año, citas recibidas, área temática, revista, institución de afiliación del autor y país en el que se ha hecho cada publicación (González et al., 2015), entendiendo que son estos los indicadores que mayor relevancia tienen para los objetivos del estudio (Molas-Gallart & Ràfols, 2018) y estudiando, además, la existencia de correlaciones positivas o negativas (Reguant-Álvarez et al., 2018) entre la producción científica sobre evaluación formativa y sumativa y las citas recibidas en dichos estudios a lo largo de la última década.

El análisis inicial, de carácter cuantitativo, se ha realizado con el software SPSS v.26. Posteriormente, se ha empleado el software Atlas ti v.7.5.4 para el análisis de contenido de los cinco estudios con mayor impacto sobre evaluación formativa y los cinco estudios con mayor impacto sobre evaluación sumativa en el periodo 2010-2020, asumiendo una definición de impacto asociada al número de veces que el artículo ha sido citado (Belter, 2015).

La muestra se ha obtenido buscando en las investigaciones disponibles en la base de datos de carácter científico Web of Science debido al elevado número de investigaciones de alto impacto disponibles (Cuervo-Carabel et al., 2018) y que incluye, además de su propia base de datos, los resultados de la búsqueda en las bases de datos City Colleges of Chicago (CCC), Derwent Innovations Index Database (DIIDW), Korean Journal Database (KJD), Medline, Russian Science Citation Index (RSCI) y Scielo. Se han realizado dos tipos de búsqueda, por un lado, con los operadores booleanos TS=(“evaluación formativa” OR “formative evaluation” OR “formative assessment”) para hallar los estudios de evaluación formativa, obteniendo 7609 resultados, y por otro, con los operadores booleanos TS=(“evaluación sumativa” OR “summative evaluation” OR “summative assessment”) para hallar los estudios de evaluación sumativa, obteniendo 2664 resultados.

Posteriormente se ha aplicado como criterio de exclusión la fecha de publicación, limitando la búsqueda al intervalo 2010-2020, ambos años inclusive. Esto ha reducido el resultado de la búsqueda de las publicaciones sobre evaluación formativa a 5904 y las de evaluación sumativa a 1.921, constituyendo así nuestra muestra definitiva (N=7825).

Todos los datos analizados fueron obtenidos el 1 de enero de 2021 a las 12:00 horas.

3. Resultados

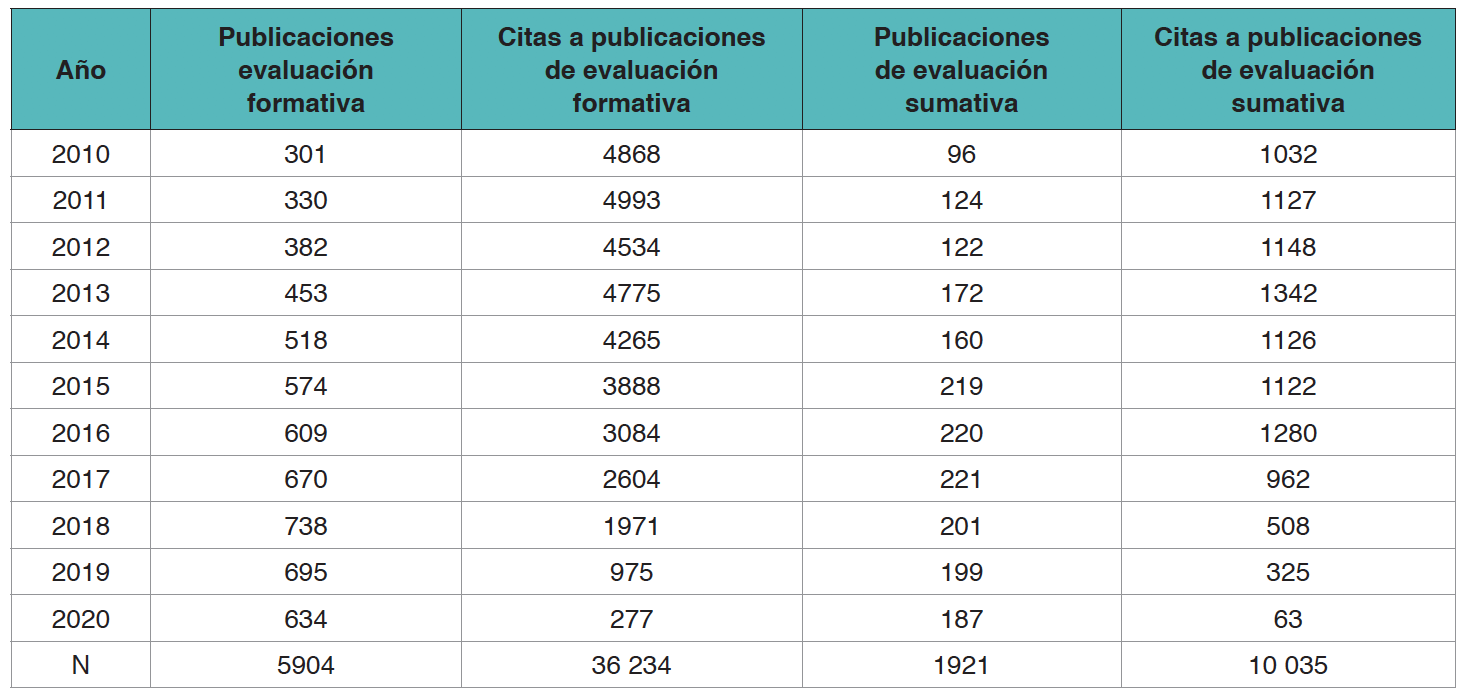

Sobre el total de la muestra (N=7825), resulta superior la investigación realizada sobre la evaluación formativa (N=5904, 75,45 %) que la realizada sobre la evaluación sumativa (N=1921, 24,55 %), una distribución entre ambos tipos de evaluación cuya desproporción se incrementa aún más en el número de citas recibidas por la evaluación formativa (N=36 234, 78,31 %) frente a la sumativa (N=10 035, 21,69 %).

La evolución que han tenido las publicaciones sobre evaluación formativa ha sido mucho mayor que la evolución en el número de publicaciones sobre evaluación sumativa. No obstante, coinciden en que ambas se encuentran en un punto menor que el pico alcanzado en años anteriores, y aun así, se mantienen por encima del número alcanzado en el año de partida (2010) en ambos casos.

En cuanto a las citas recibidas por estas publicaciones, podemos ver cómo el número de citas recibidas por las publicaciones sobre evaluación formativa aumenta a medida que nos remontamos en el tiempo, mientras que en el caso de las publicaciones sobre evaluación sumativa se mantienen relativamente estables desde 2016.

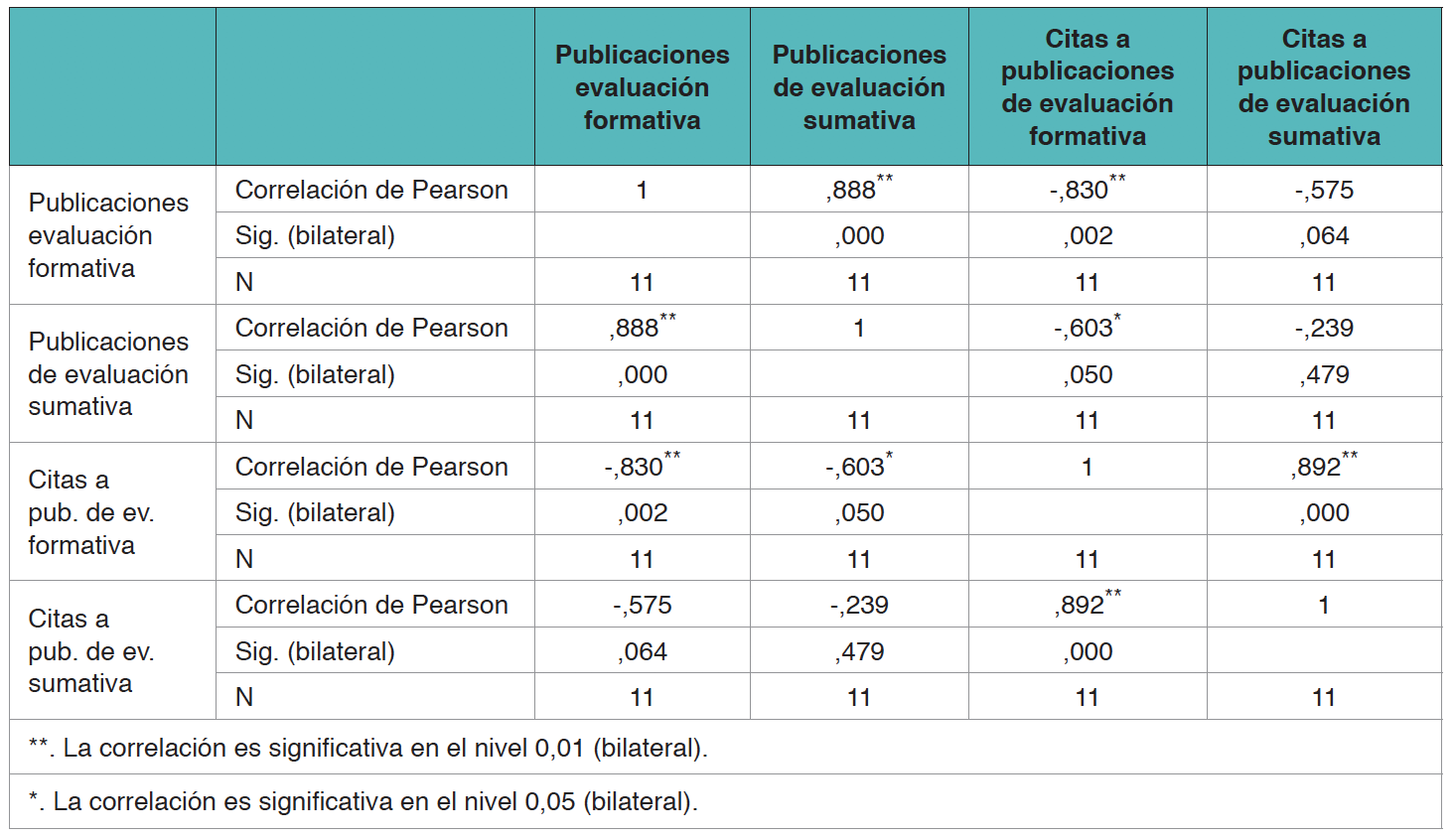

Estas tendencias en el número de publicaciones y citas recibidas arrojan una correlación significativa positiva existente entre el número de publicaciones de evaluación formativa y sumativa (0,888), una correlación significativa negativa ente el número de publicaciones en evaluación formativa y las citas que han recibido (-0,830) y otra correlación significativa negativa ente el número de publicaciones en evaluación sumativa y las citas que han recibido (-0,603).

En cuanto a las áreas de conocimiento en las que se encuadran las investigaciones, aunque con ciertas alteraciones en el orden, coinciden en ambos casos las cinco principales áreas: investigación educativa, psicología, ciencias informáticas, medicina y ciencias del comportamiento.

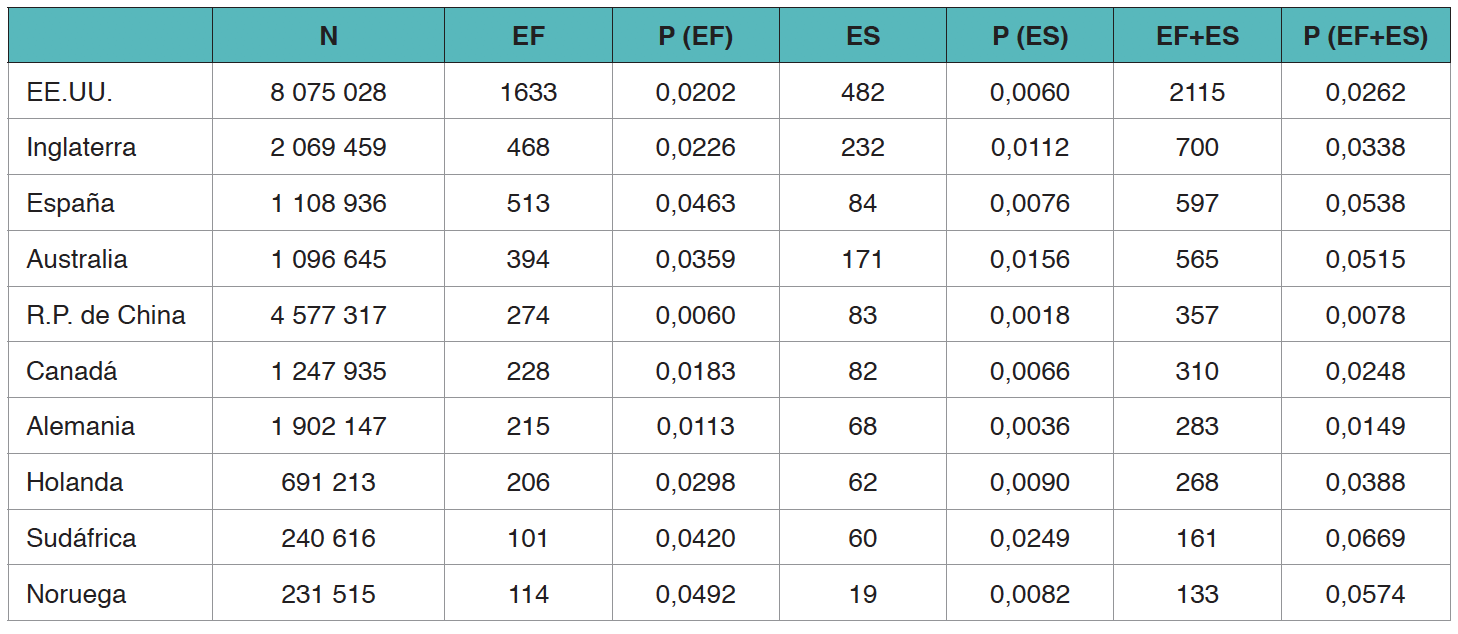

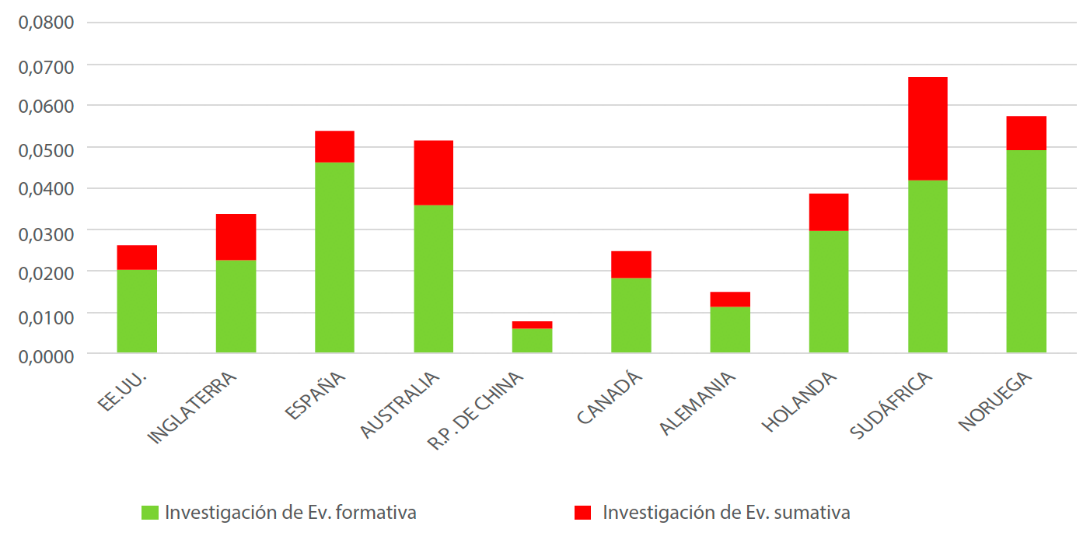

Para conocer el interés investigador que despierta en los países con más publicaciones sobre evaluación formativa y sumativa, presentamos en la Tabla 3 una comparación entre la frecuencia de las publicaciones de un tipo de publicación y otra comparada con sus publicaciones en cualquier otro campo científico durante el mismo periodo de estudio. De esta manera podemos observar cuál es el peso relativo que tienen las investigaciones sobre evaluación formativa y sumativa, por separado y en conjunto, frente a su producción nacional total de literatura científica (Gráfico 1).

Tabla 3. Publicaciones sobre Evaluación Formativa (EF), Evaluación Sumativa (ES) y porcentaje sobre el total de publicaciones (P)

Se manifiesta un dominio anglosajón (EEUU e Inglaterra) que sucede fundamentalmente al observar los datos absolutos, pero si son relativizados en función de la producción científica total de cada país, se pueden ver los datos eliminando el efecto que produce sobre ellos que esos países sean a su vez los que mayor investigación producen en todos los campos científicos. De esta manera, podemos ver que existen países anglosajones donde la investigación en este campo tiene un mayor interés, como es el caso de Sudáfrica y Australia, pero también otros países no-anglosajones tienen un interés que puede ser considerado relevante como es el caso de Noruega, España y Holanda.

Gráfico 1. Tasa de publicaciones de evaluación formativa y sumativa sobre la producción científica total

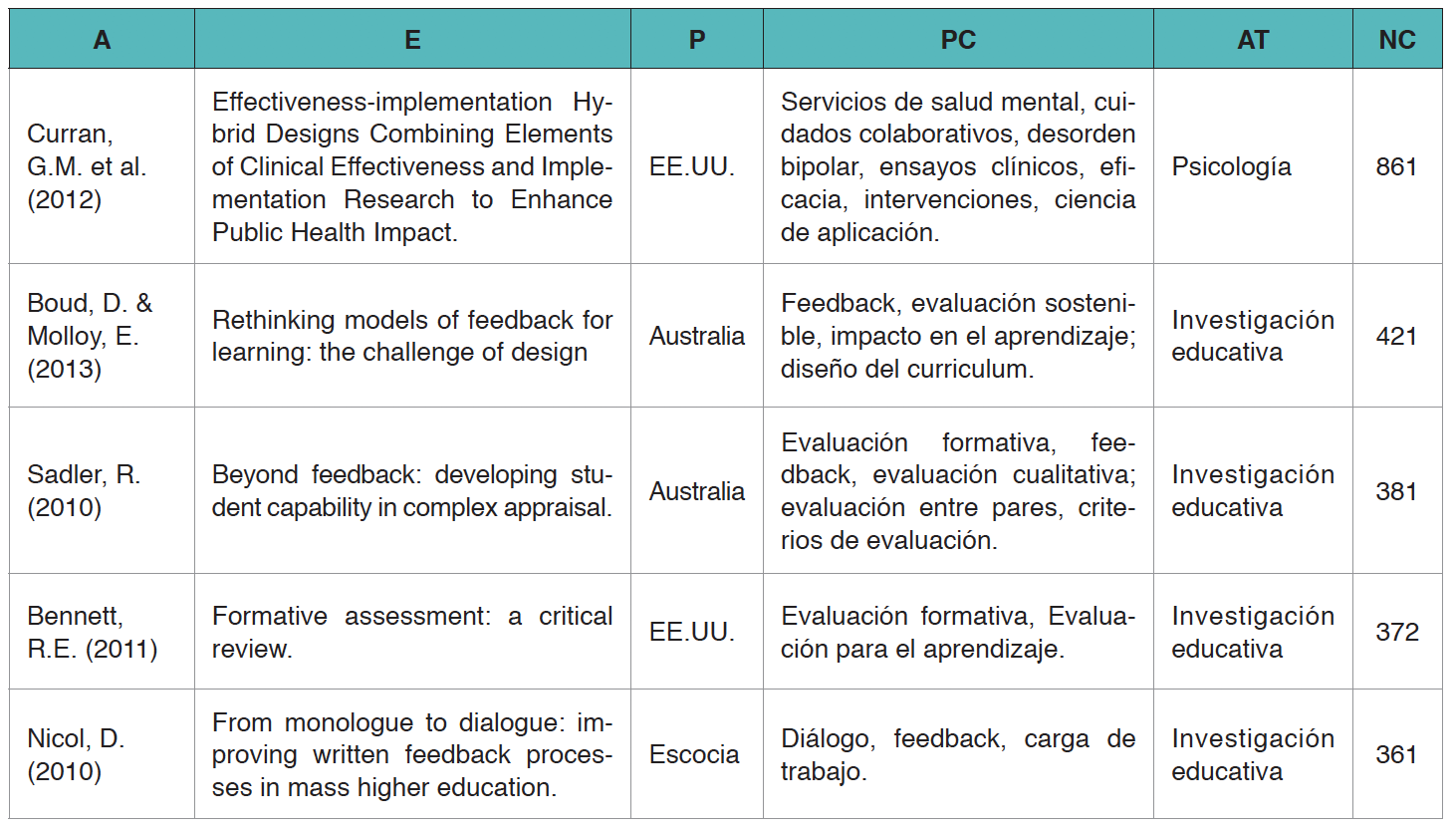

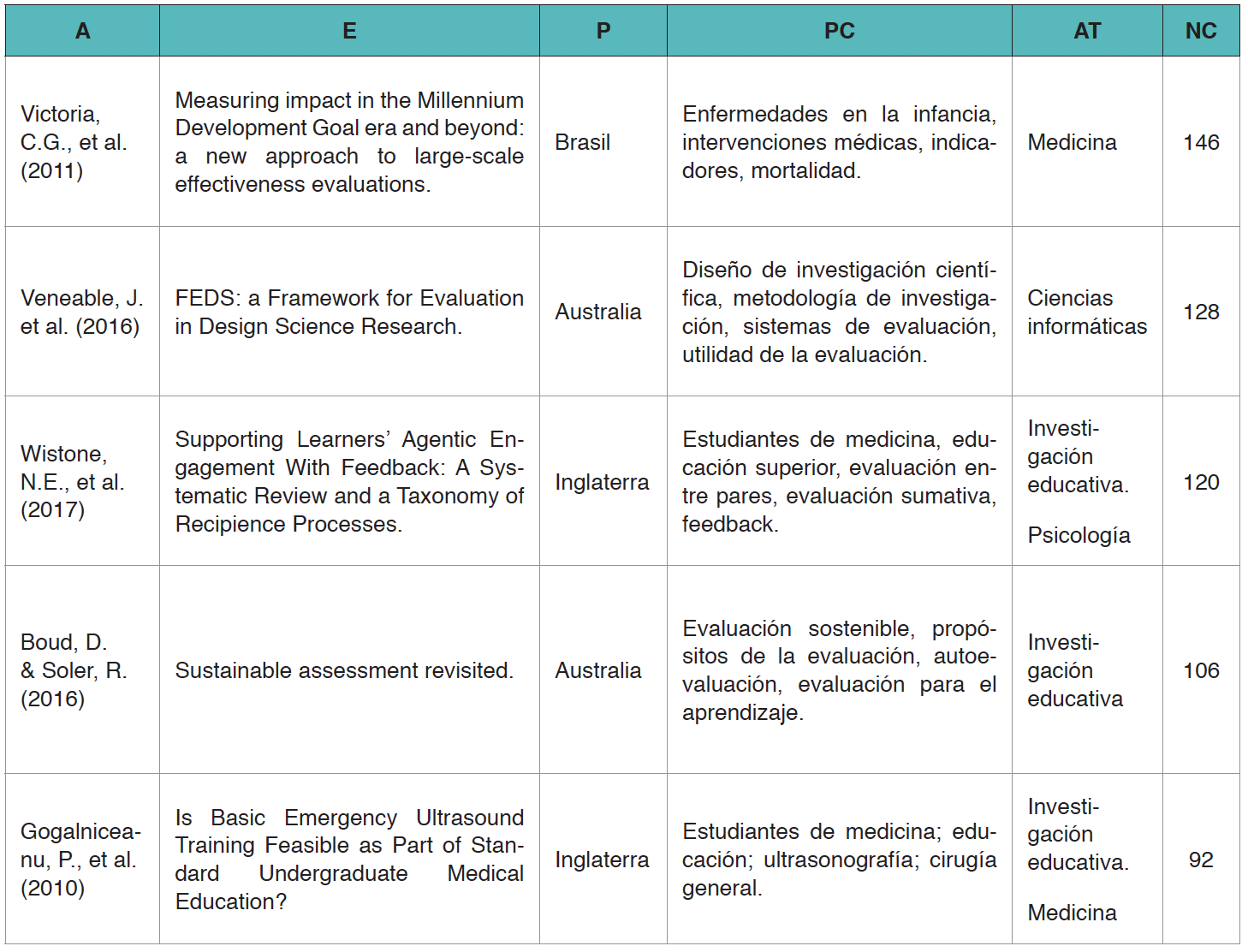

En lo que se refiere a los estudios sobre evaluación más relevantes, hemos recogido en la siguiente tabla los cinco estudios con mayor impacto sobre evaluación formativa (Tabla 4) y los cinco estudios con mayor impacto sobre evaluación sumativa (Tabla 5) de la década.

Tabla 4. Estudios (E) sobre evaluación formativa clasificados por autor y año (A), país (P), palabras clave (PC), área temática (AT) y ordenados por mayor número de citas (NC)

En cuanto al contenido de estas investigaciones, las tendencias de la investigación formativa señalan el feedback como un elemento fundamental para la evaluación formativa. Se obtiene una mayor satisfacción con el feedback escrito que con el feedback oral cuando se traslada el protagonismo del feedback del profesorado hacia el alumnado (más dialógico), cuando participa más de un docente (más colectivo) y más de un estudiante (menor carga académica) en el mismo proceso y cuando se encuentra mejor secuenciado (más cohesión). El feedback tiene que aportar información sobre los criterios de evaluación, sobre la calidad del trabajo y consejos de mejora para realizar tareas similares en el futuro (feedforward).

Se detectan ciertas limitaciones, como es el posible escaso interés por participar del feedback. Por ello, se identifica como necesidades mejorar el desarrollo profesional del profesorado a través de una mayor investigación sobre el uso de la evaluación formativa, así como crear entornos de aprendizaje que funcionen eficazmente y mejoren la comprensión de las tareas, de la calidad exigida de las respuestas y de los criterios de evaluación establecidos. Mención diferenciada merece la investigación sobre la mejora de la salud pública que, a pesar de abordar un ámbito no educativo, aporta evidencias de cierta transferencia de conocimiento del área educativa a otras áreas científicas y de cómo la evaluación formativa ayuda a proporcionar un contexto que explica los resultados de las evaluaciones sumativas.

Tabla 5. Estudios (E) sobre evaluación sumativa clasificados por autor y año (A), país (P), palabras clave (PC), área temática (AT) y ordenados por mayor número de citas (NC)

Por su parte, las tendencias de la evaluación sumativa demuestran una alta eficacia de este tipo de evaluación para recoger datos a gran escala, permitiendo una cobertura geográfica amplia y obteniendo unos resultados que aportan evidencias de gran alcance. Los instrumentos y técnicas de evaluación sumativa tienen una gran importancia en el ámbito de las ciencias aplicadas para evaluar los resultados de diseño y de productos o para la detección de estrategias de trabajo eficaces. Permite combinarse con la evaluación formativa empleándose como estrategia de evaluación temprana que pueda subsanar errores del planteamiento inicial.

Algo que también es aplicable a la evaluación de los aprendizajes del alumnado en los que se pueden emplear estrategias formativas para, por ejemplo, garantizar que el alumnado conoce los criterios de éxito en una tarea para luego evaluarla de forma sumativa. La evaluación limitada a la calificación también puede mejorar el proceso porque se puede completar con juicios fundamentados que reorienten el aprendizaje del alumnado. Así, se entiende que emplear de forma exclusiva la evaluación sumativa es un planteamiento reduccionista y que puede ser compatible con otros elementos no sumativos, como son la autoevaluación, la evaluación continuada o evaluaciones intermedias para mejorar un proceso con diseño flexible o el uso del feedback al final del periodo de intervención educativa.

4. Discusión y conclusiones

Considerando las 7825 publicaciones científicas halladas en Web of Science sobre evaluación formativa y sumativa, podemos concluir que existe una tendencia de dominio claro del primer fenómeno frente al segundo. Ello se traduce en un impacto científico que es incluso mayor, existiendo un efecto multiplicador entre producción e impacto que explica que la diferencia en el porcentaje de citas sea superior proporcionalmente a la diferencia en el porcentaje de producciones. Se ha detectado una correlación clara entre las publicaciones de un tipo y otro de evaluaciones, lo que sugiere que existe cierta retroalimentación que provoca que el interés por investigar uno y otro fenómeno tiene una estrecha relación. Un hecho que se ve corroborado en el análisis de contenido de las investigaciones de evaluación sumativa, en las que aparece de manera recurrente la combinación de instrumentos y técnicas de evaluación sumativas con otras propias de la evaluación formativa.

El dominio de la producción científica sobre ambos tipos de evaluación corresponde a la esfera anglosajona y aunque se realizan dentro del área educativa, no lo es en exclusiva, pues tiene aplicaciones a áreas relacionadas con la educación como es la psicología o las ciencias del comportamiento, pero también otras como informática o medicina, provocado por la existencia de investigaciones que emplean métodos de evaluación de sistemas de diversa índole y por el estudio del rendimiento académico del alumnado de educación superior en dichas áreas. Esto demuestra que la investigación en el área de la evaluación no solo aporta avances en el área de la educación, sino también puede suponer avances en otras ramas del conocimiento.

En definitiva, la evaluación del alumnado como objeto de estudio, tanto en el caso de la evaluación formativa como sumativa, además de tener una larga trayectoria histórica como se ha visto en el estado de la cuestión, resulta ser una línea de investigación de interés y actualidad en el ámbito académico internacional que publica mayor número de investigaciones al final de la década que al principio, generando una producción científica numerosa y relevante, que se retroalimenta entre sus distintas variables y que genera transferencia tecnológica con otras áreas de conocimiento en sus contextos más prácticos.